编程解剖 in rust

以rust为例分享学习编程常考虑的方方面面

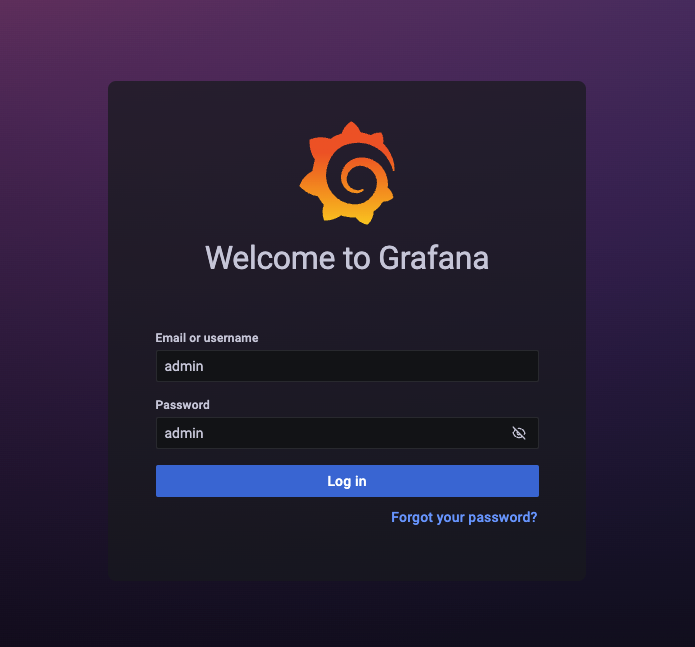

本地运行

cargo install mdbook

mdbook serve

git lfs配置

git lfs install

git lfs track '*.img'

项目基础结构

{{#check

- 每个文件夹下的同名md文件介绍当前文件夹的内容

- 关于待完成内容:主要基于mdbook-checklist插件

- [待完成](checklist.md)

- 添加待完成锚点的格式

check空格之后的内容不能有空格, 且只能为英文 “ | “之后的内容可以有空格,可以为中文

<a id="Note-1"></a>Note-1

- checklist页面渲染效果:

- <SUMMARY对应标题名>

- [This is an important note](Note-1)

这种写法会自动在本地生成md文件:src/checklist.md, 但是不用管它,最后渲染还是以mdbook-checklist的内容为准

用到的工具

mdbook-checklist: 整理待办事项

ANSSI-FR/mdbook-checklist: mdbook preprocessor for generating checklists and indexes

cargo install mdbook-checklist

mdbook-checklist - crates.io: Rust Package Registry

mdbook-pagetoc: 添加业内目录

JorelAli/mdBook-pagetoc: A page table of contents for mdBook

mdbook-admonish: 使用新的css文件

相关资源

- tommilligan/mdbook-admonish: A preprocessor for mdbook to add Material Design admonishments.

- mdbook-admonish - crates.io: Rust Package Registry

- Overview - The mdbook-admonish book

- Admonitions - Material for MkDocs

All supported directives are listed below.

特别语法

自定义标题

内嵌代码

自定义样式

可折叠

常用格式

note

Rust is a multi-paradigm, general-purpose programming language designed for performance and safety, especially safe concurrency.

abstract, summary, tldr

Rust is a multi-paradigm, general-purpose programming language designed for performance and safety, especially safe concurrency.

info, todo

Rust is a multi-paradigm, general-purpose programming language designed for performance and safety, especially safe concurrency.

tip, hint, important

Rust is a multi-paradigm, general-purpose programming language designed for performance and safety, especially safe concurrency.

success, check, done

Rust is a multi-paradigm, general-purpose programming language designed for performance and safety, especially safe concurrency.

question, help, faq

Rust is a multi-paradigm, general-purpose programming language designed for performance and safety, especially safe concurrency.

warning, caution, attention

Rust is a multi-paradigm, general-purpose programming language designed for performance and safety, especially safe concurrency.

failure, fail, missing

Rust is a multi-paradigm, general-purpose programming language designed for performance and safety, especially safe concurrency.

danger, error

Rust is a multi-paradigm, general-purpose programming language designed for performance and safety, especially safe concurrency.

bug

Rust is a multi-paradigm, general-purpose programming language designed for performance and safety, especially safe concurrency.

example

Rust is a multi-paradigm, general-purpose programming language designed for performance and safety, especially safe concurrency.

quote, cite

Rust is a multi-paradigm, general-purpose programming language designed for performance and safety, especially safe concurrency.

github action

- rust-cargo-install · Actions · GitHub Marketplace

- ekalinin/github-markdown-toc: Easy TOC creation for GitHub README.md

- 设置token:Personal access tokens

- 给指定repository设置secret:repository -> settings -> secrets -> Actions

- 新建一个名为GH_MD_TOC的repository secret,将第一步的token设置进去

- 将这个secret设置为action环境变量

待完成

Substrate介绍与源码解读

Gavin Wook、Polkadot and Substrate

Gavin Wook与波卡跨链

所以对于开发人员来说,比起大家耳熟能详的v神(Vitalik Buterin),更重要的人是实际上撑起整个以太坊世界的灵魂人物Gavin Wood。更何况很多山寨币实际上就是在以太坊的模型上修修改改,所以在我看来Gavin Wood是撑起了当前半个区块链世界的人。

而Gavin Wood 离开了以太坊之后,开启的一个新项目叫做Polkadot(波卡),这个项目的目的就是跨链,为了把各个割裂的区块链孤岛能够联系一起 。虽然目前有很多的项目都号称自己在做跨链,但是目前在我看来唯一在推进,逻辑上是可推理,之后可能成功的跨链项目就只有波卡能够成功。(后半段可能存在一定误导性,Polkadot的跨链可能在大部分人理解下应该是分片的变种,也就是基于Substrate开发的区块链可以部署到Polkadot上,经过Polkadot平台互相沟通)。

从波卡到Substrate

而Gavin Wood 在开发的波卡的过程中,经过不断地思考,认为其实区块链发展这几年,大家做的很多事情都是相同的。

那么在以往的软件开发中,当大家发现大家都在做相同的事情的时候,就会将这件事情进行抽象,然后造“轮子”,将这些高层次的东西做封装,成为“开发框架”,将背后复杂的基础设施都封装起来,而使用这个“框架”的开发人员,就可以更加专注于自己的业务逻辑,而不必花费大量的精力去造“轮子”去完成那些每个链都要做的事情。

Gavin Wood 在开发波卡的中途先暂停了波卡的开发,将波卡及以太坊已有的成果进行抽象,命名为substrate作为区块链开发的基础框架,并把全部精力都转移到了substrate开发中。

跨链的重要性

另一方面,在软件开发领域或者互联网领域,大家其实都发现了占据了框架的地位实际上一定程度上占据了这个领域开发的生态,更何况对于跨链来说,当大家的链都比较同质化后,跨链会更加的方便。现在大家都把跨链当作区块链下一个引爆点,而跨链的属性界定了做“跨链”的人基本上只能一家独大,成为垄断地位。而接入跨链的链越多,这个跨链就越垄断( 因为大家使用跨链就是为了在不同的链之间兑换代币,能换的代币越多,使用这个跨链的人就越多,生态就越集中),

而Gavin Wood 提供的substrate框架又能解决大部分链都在重复解决的问题,所以大家就更倾向于使用substrate开发自己的链。

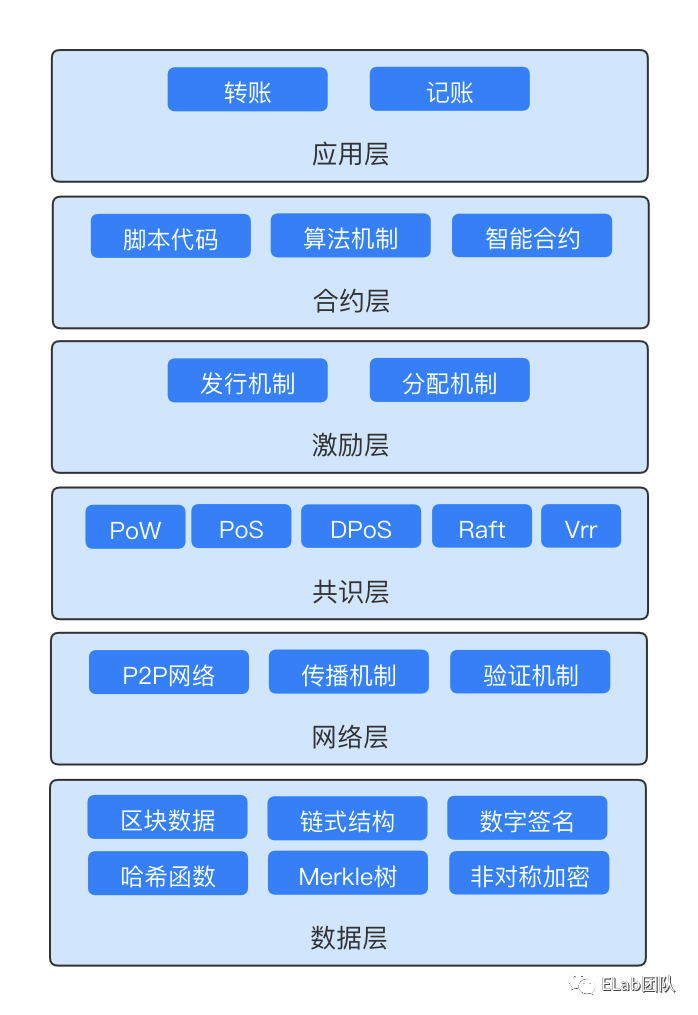

总体设计

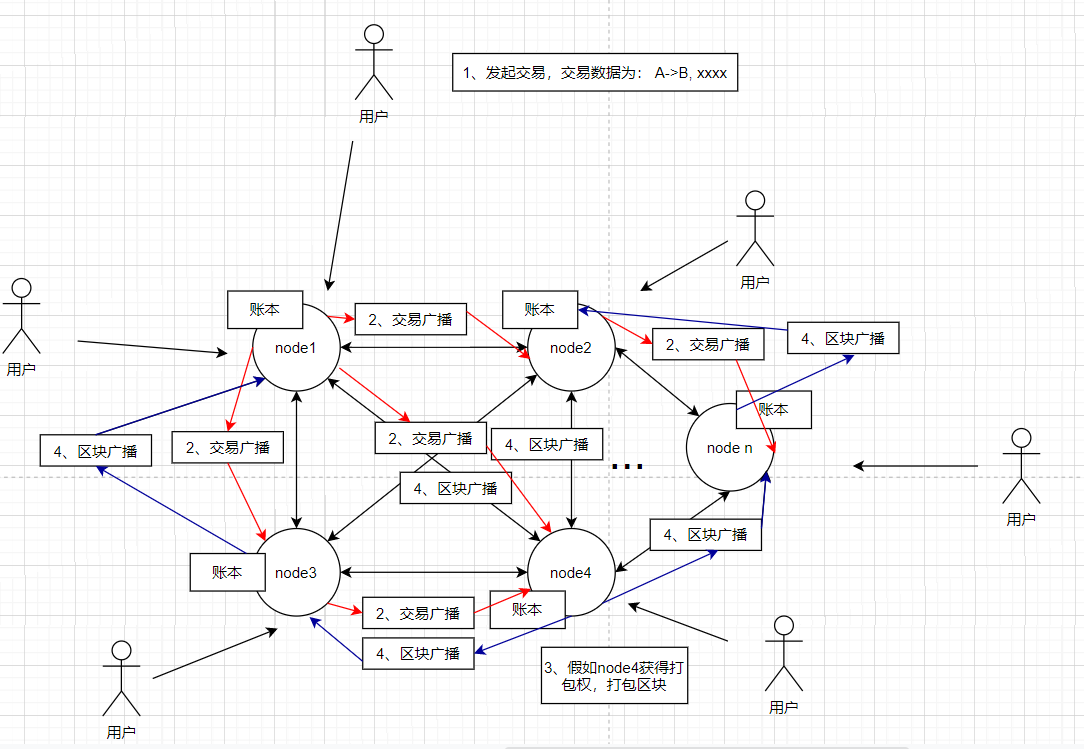

常见区块链设计

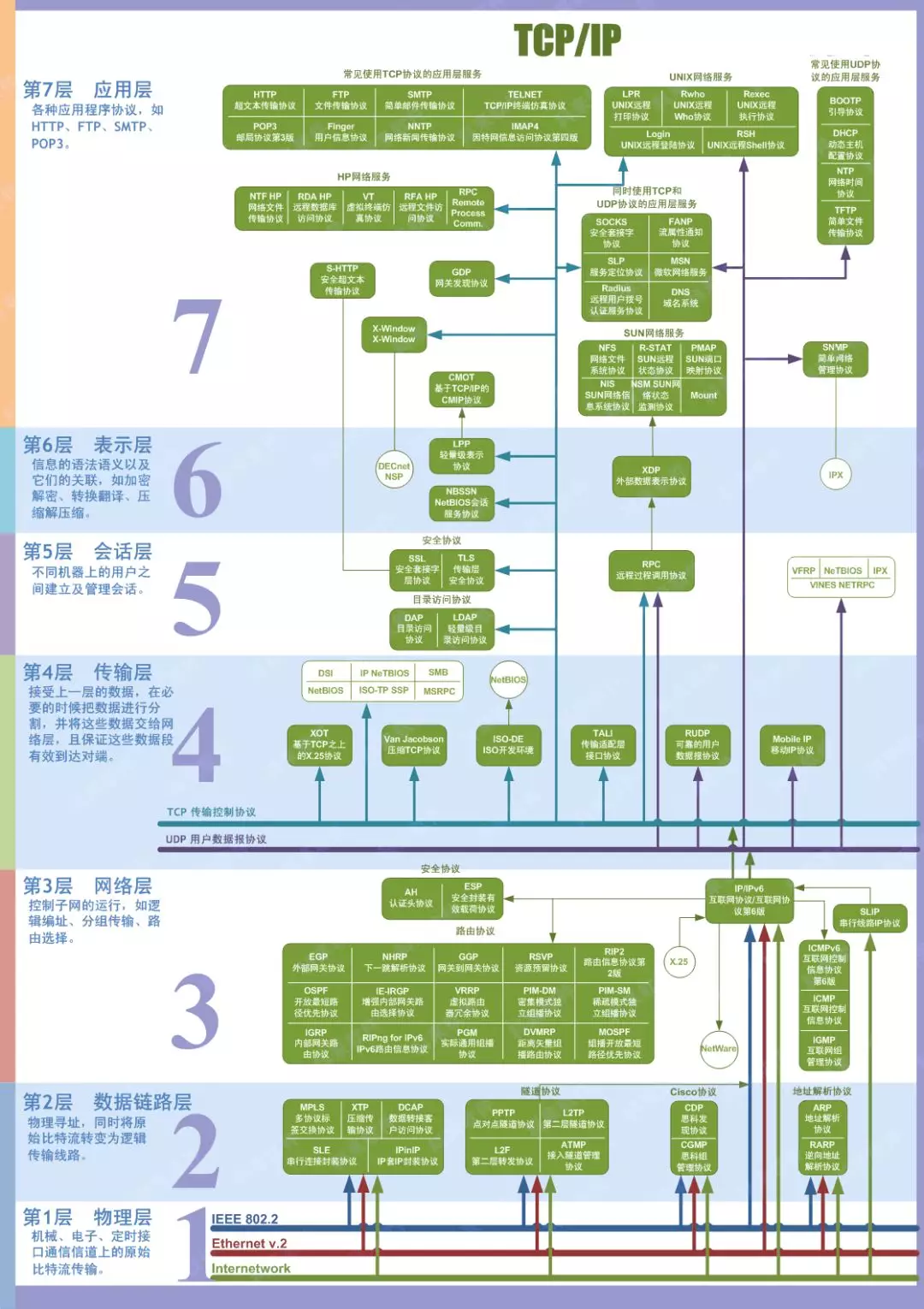

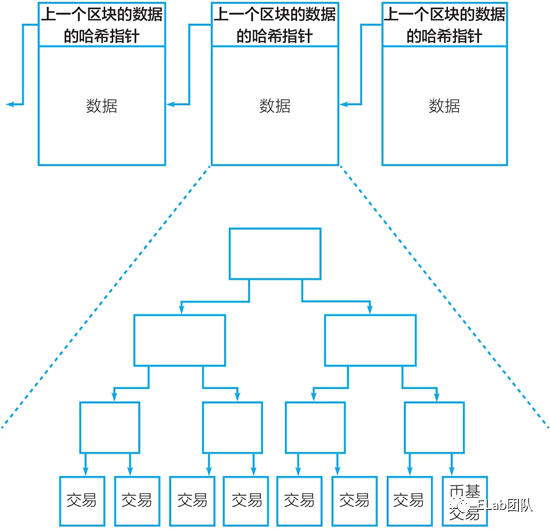

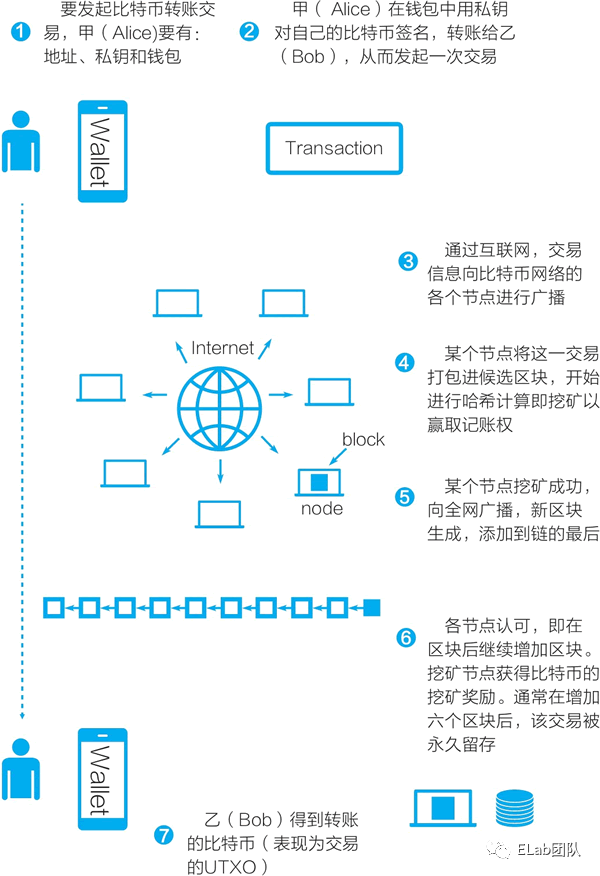

目前所有的区块链系统几乎都是从比特币/以太坊模型演变而来。一般来说,一个区块链系统应该具有:

区块链系统基础部分

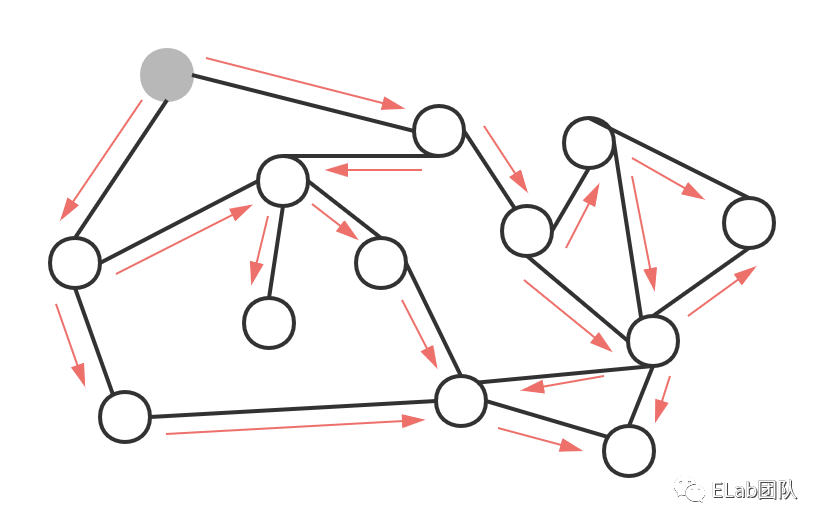

- 共识系统 (区块链分布式基石)

- p2p连接与广播系统

- 存储系统

- 交易池系统

- rpc系统(区块链与外界交互主要通道)

链的功能

链功能是区块链间相互竞争的关键部分. 与系统基础部分相比,这部分差异很大,提供的是除去区块链模型外,这条链能够提供的功能。另一方面在区块链升级中,一般来说系统基础部分改动较小,而链的功能部分改动较大,特别是许多链为了追求开发速度,一开始只能提供转账功能,在后续的版本中才慢慢升级其他功能

例如:

- 比特币的UTXO结构加上交易脚本

- 以太坊的虚拟机与智能合约

- eos的账户系统及虚拟机

- 有的山寨币特化部分智能合约或部分native层成为系统级功能:

- 提供随机数

- 提供质押对赌

- oracle数据输入

- 引入复杂密码学方案

- 等等。。。

Substrate理念

先认识一下:什么是区块链框架

简单来说,或者从本质上讲,区块链框架是一个(巨大的)工具和库的集合,用于构建一个完整的、可运行的、安全的、功能完整的(尽管是基本的)区块链。

区块链框架负责处理以下方面的大部分繁重工作:

- 共识P2P网络

- 帐户管理

- 基本的区块链逻辑(区块、交易等)

- 区块链交互的客户端

接着说说Substrate与web3

Substrate 可以被描述为一个区块链框架——具体来说,一个用于构建定制区块链的框架。这些区块链可以完全自主运行,这意味着它们不依赖任何外部技术来运行。

然而,Substrate 背后的公司 Parity(由以太坊联合创始人 Gavin Wood 共同创立)也建立了 Polkadot 网络。 Polkadot 本质上是一个分散的、基于协议的区块链平台,用于实现安全的跨区块链通信。

由于它们是由同一个人开发的,因此 Substrate 对与Polkadot的集成具有一流的支持,因此您使用Substrate创建的任何区块链都可以无缝连接到 Polkadot。

Substrate 还提供无分叉运行时升级——在不触发硬分叉的情况下升级区块链状态转换功能的能力。

用web框架、游戏引擎类比

一个更好的比较可能是一个成熟的游戏引擎(想想 Unity),它为你需要的一切功能提供基本实现,以及可能需要的许多扩展点,供自定义。

当然,这意味着已经在架构方面做出了一些决定:你将无法轻易更改。

根据你的用例,可能需要更多的可定制性,而框架可能会以某种方式对其进行限制。

这是标准的权衡:区块链框架可以节省你的时间,但代价是你不得不忍受的一些事情。

然而,正如我们将在下面更详细地探讨的那样,Substrate在这方面提供了一些灵活性。

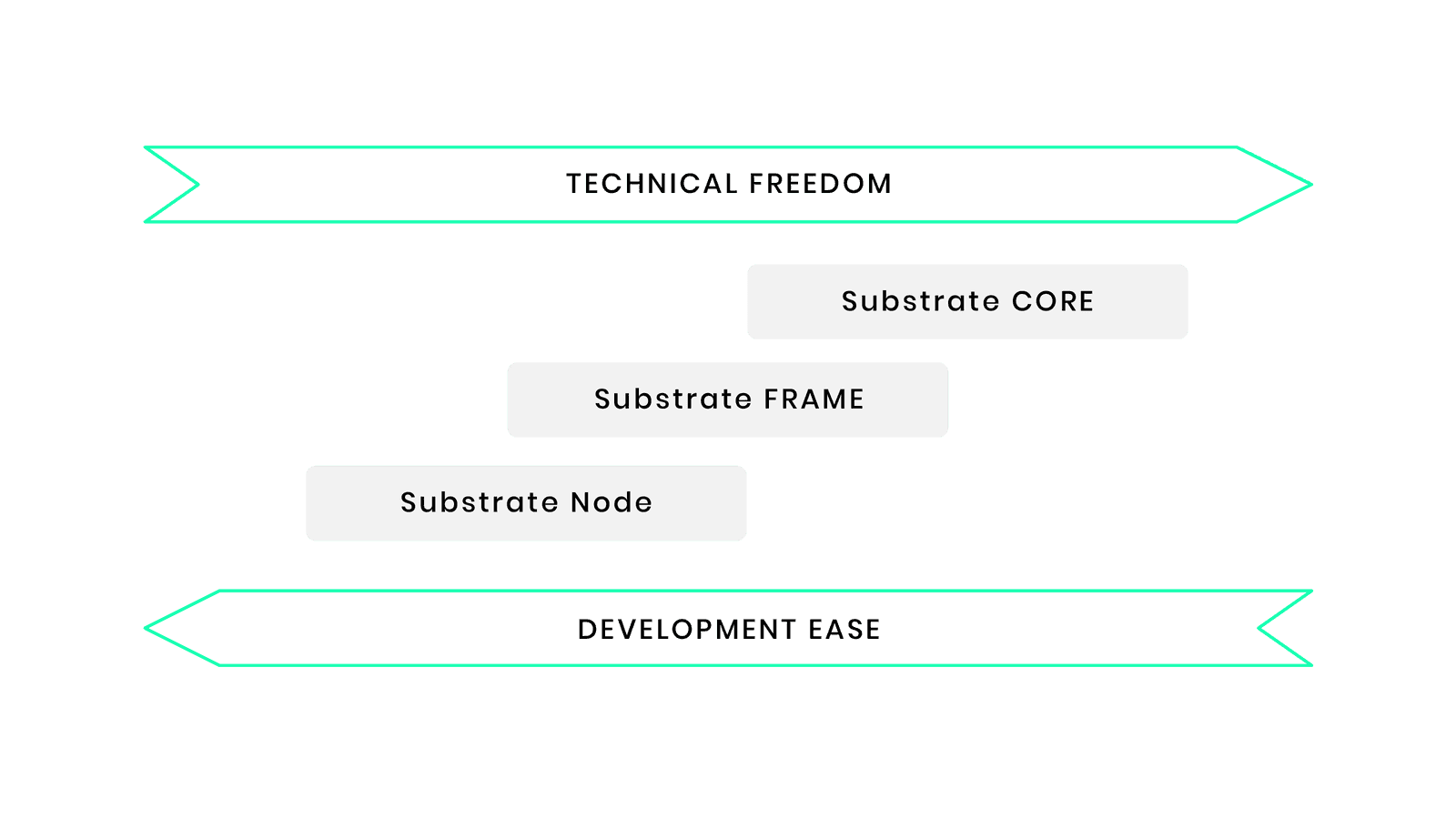

使您能够在多个阶段在更多的技术自由和易于开发之间进行选择。

Substrate的后端是用 Rust 构建的。它(以及 Parity 通常所做的大部分工作)也是完全开源的。

因此,您不仅可以使用 Substrate,还可以通过回馈和分叉其中的一部分来改进它,以根据您自己的需求进行定制。

Substrate Architecture

Gavin Wood 作为以太坊实际核心的开发者,自然早已对这套系统的框架了然于心,所以从Substrate框架提出的开始(2018年9月),就对区块链系统作出了2个关键的区分:

┌───────────────────────────────────────────────────────────────────────────────────────────────────────┐

│ │

│ │

│ ┌─────────────────┐ ┌─────────────────┐ ┌─────────────────┐ ┌─────────────────┐ │

│ │ fund management │ │ Account │ │ Contract │ │ Democratic │ │

│ │ transfer │ │ system │ │ VM │ │ referendum │ │

│ └─────────────────┘ └─────────────────┘ └─────────────────┘ └─────────────────┘ │

│ │

│ ###### # # # # ####### ### # # ####### │

│ ┌─────────────────┐ ┌─────────────────┐ # # # # ## # # # ## ## # │

│ │ Equity │ │ etc. │ # # # # # # # # # # # # # # │

│ │ calculation │ │ │ ###### # # # # # # # # # # ##### │

│ └─────────────────┘ └─────────────────┘ # # # # # # # # # # # # │

│ # # # # # ## # # # # # │

│ # # ##### # # # ### # # ####### │

├───────────────────────────────────────────────────────────────────────────────────────────────────────┤

│ │

│ ┌─────────────────┐ ┌─────────────────┐ ┌─────────────────┐ ┌─────────────────┐ │

│ │ Consensus │ │ Network system │ │ Trading │ │ │ │

│ │ mechanism │ │ (p2p) │ │ Pool │ │ RPC │ │

│ └─────────────────┘ └─────────────────┘ └─────────────────┘ │ │ │

│ └─────────────────┘ │

│ ##### ####### ###### ####### │

│ ┌─────────────────┐ # # # # # # # │

│ │ etc. │ # # # # # # │

│ │ │ # # # ###### ##### │

│ └─────────────────┘ # # # # # # │

│ # # # # # # # │

│ ##### ####### # # ####### │

│ │

└───────────────────────────────────────────────────────────────────────────────────────────────────────┘

从Rust看Substrate

开发者只需要关注Runtime(链功能)

根据这样的划分,当开发者使用Substrate框架的时候,无需关心区块链基础功能也就是Core部分的工作,而只需关心自己链能够提供的功能,也就是Runtime部分的工作。

明晰Runtime

这里一直强调Runtime是“链的功能”有一些通俗与不严谨,这里使用一个更抽象的描述:

这个定义比较抽象,且由于需要对“世界状态”或类似概念有比较深入的了解才好解释,故不展开讲解。更严格来说,“需要对运行结果进行共识的功能组件”是“链的功能”的一个子集。

判断标准

这里有一个简单的判定标准判断某个功能是否应该放在Runtime内:

对于某个功能,若只改动一个节点的代码对于所有的逻辑运行的结果与其他不改动的节点运行的结果相同,则认为这个部分应该放在Runtime之外,如果运行结果不同,则认为应该放在Runtime之内。

举个例子:比如我改变了交易池的排序代码,使得对某个账户有利的交易能优先打包。这个改动会令自己这个节点产出的区块不公平的打包交易,但是只要打包出来的区块大家都可以认可,则所有节点共识的“状态的变化”仍然是一致的。很明显,这个功能组件不应该是Runtime的功能,因为它不会改变对于验证一个区块时的“状态变化”的验证。比如我改变了转账功能的代码,能给某个账户凭空增加钱,那么显然,这种改动对于这个改动过的节点执行的结果将会与其他节点不同,则共识不会通过。所以转账这个功能就应该放在Runtime当中,让所有节点执行的都是一致的。

这部分结合native与wasm后会容易理解

所以到底什么是Runtime,我认为使用“链上功能”来描述最为恰当,因为其隐含了对于执行结果的共识问题。

Substrate的Runtime

Substrate的Runtime当然没有止步于仅将区块链系统做了模块化划分,提供框架功能这一步,事实上,由于抽象出了Runtime,Substrate实现了以往所有区块链都无法实现的一个功能:区块链系统升级。

中心化升级流程

┌────────────────────────────────Centralized System Upgrading(Internet App)────────────────────────────────┐

│ │

│ │

│ ┌───────────────────┐ ┌─────────────┐ ┌─────────────┐ ┌─────────────┐ │

│ ┌──▶│ Update Code │ │ Deploy │ │ Upgrade │ │ Centralized │ │

│ .─────────. │ │(Backend/Frontend)─┼──────▶ Server │───▶│ Sucessful │────▶Upgrade Easy │ │

│ ╱ ╲ │ └───────────────────┘ └─────────────┘ └─────────────┘ └─────────────┘ │

│ ( Bug/Upgrade )───┤ ┌─────────────┐ │

│ `. ,' │ │ Somebody │ │

│ `───────' │ ┌─▶│ Upgrade ├─┐ │

│ │ ┌───────────────────┐ ┌─────────────┐ │ └─────────────┘ │ ┌─────────────┐ │

│ └──▶│ Update Code │ │ Publish │ │ │ │ Fragmented │ │

│ │ (App) ─┼──────▶ App Store │─┤ ┌─────────────┐ ├─▶│ version │ │

│ └───────────────────┘ └─────────────┘ │ │ Somebody │ │ └─────────────┘ │

│ └─▶│ Reject │─┘ │

│ └─────────────┘ │

│ │

│ │

└──────────────────────────────────────────────────────────────────────────────────────────────────────────┘

对于中心化的互联网系统而言,由于代码与数据的控制权在自己手上,所以可以随时进行版本的升级与修改。但是即便如此,也只有网页H5,后台代码可以做到随时升级,在移动互联网中,app还是需要用户自行更新。其中android生态尤为突出,apk版本的碎片化一度是困扰开发者的难题。为了应对app应用的碎片化,推出了许多功能各异的框架能够用户在不更新app的情况下进行“热更新”,一度成为技术的热门追捧。这些热更新的框架本质上都是允许从后台下载一段更新代码,通过各种方式加载运行新的代码来完成。一般情况下通过这种热更新提供的功能都会带来一定的性能损耗以运行最新的热更新代码。但是即便是热更新,更新代码的控制权也同样处于中心化组织的手中。

无央化升级流程(原先)

┌───────────────────────────────────Decentralized System Upgrading(Blockchain Dapp)────────────────────────────────────┐

│ ┌─────────────┐ │

│ │ Upgrade │ │

│ ┌───Yes───────▶│ Sucessful │ │

│ │ └─────────────┘ │

│ Λ │

│ ╱ ╲ │

│ ╱ ╲ │

│ ╱ ╲ │

│ ┌────────┐ ╱ ╲ │

│ │ Deploy │ Most deployments │

│ ┌──Support─▶│ Node │─────▶(Under Byzantine │

│ │ └────────┘ Fault Tolerance) │

│ │ ╲ ╱ │

│ Λ ╲ ╱ │

│ ╱ ╲ ╲ ╱ │

│ ╱ ╲ ╲ ╱ │

│ ╱ ╲ V ┌──────────────────┐ │

│ .─────────. ┌─────────────┐ ╱ ╲ │ │ Upgrade Fail │ │

│ ╱ ╲ │ Update Node │ ╱ Running ╲ └───No────────▶│(Cause Fragmented)│ │

│ ( Bug/Upgrade ─────▶ Code ├────▶ Node ▏ └──────────────────┘ │

│ `. ,' └─────────────┘ ╲ (Minner ╱ ▲ │

│ `───────' ╲ ╱ │ │

│ ╲ ╱ │ │

│ ╲ ╱ │ │

│ .─────────. ╲ ╱ │ │

│ ,─' '─. V │ │

│ ; Community : │ ┌────────┐ │ │

│ : proposal ; │ │ Reject │ │ │

│ ╲ (BIP/EIP) ╱ └───Reject─▶│ Deploy │───────────────────────────────────────┘ │

│ '─. ,─' └────────┘ │

│ `───────' │

└──────────────────────────────────────────────────────────────────────────────────────────────────────────────────────┘

区块链领域就大大不同了。 即便代码更新的权力在某个组织的手上,但是运行这些代码的人可不一定会听这个组织的指挥,无法容易的命令分散节点统一的进行新代码的部署更新。

比特币社区就是这个领域下的一个典型,由于比特币社区的分裂,部分人并不认同不更改区块大小而是采用隔离见证的方案,分裂出了BCH,对BTC的生态产生的极大的损害。ETH的升级同样也困难重重,每次升级都需要进行长时间的等待以防有节点未升级而产生的分叉。

EOS由于其中心化的特点使得升级稍微简单一些,但仍然出现了由于升级带来的分叉的恶性事件。我们可以形象把区块链下的系统升级称为“全球升级”,因为其要求分布式环境下的大部分节点都更新了代码才使得升级能够成功。相较于中心化控制的系统,区块链系统的升级困难重重且充满风险。

同时区块链的升级还有另一个问题:高度判断

一个区块链系统升级后,不得不在代码中加入许多的“高度判断”,以区分不同高度下运行的代码,保证同步能够正常执行,兼容老数据。这种做法很原始但是又无法绕开,给开发者带来极大的思维负担,且需要大量的测试来保证不出现Bug。

比如目前比特币的源码中就有许多的区块高度判定使得在同步老区块的时候执行老代码,新区块的时候执行新代码。而中心化系统的数据控制权在自己手上,并且也不存在需要从某个数据源同步的情况,所以完全不需要担心这个问题。

Substrate的不同

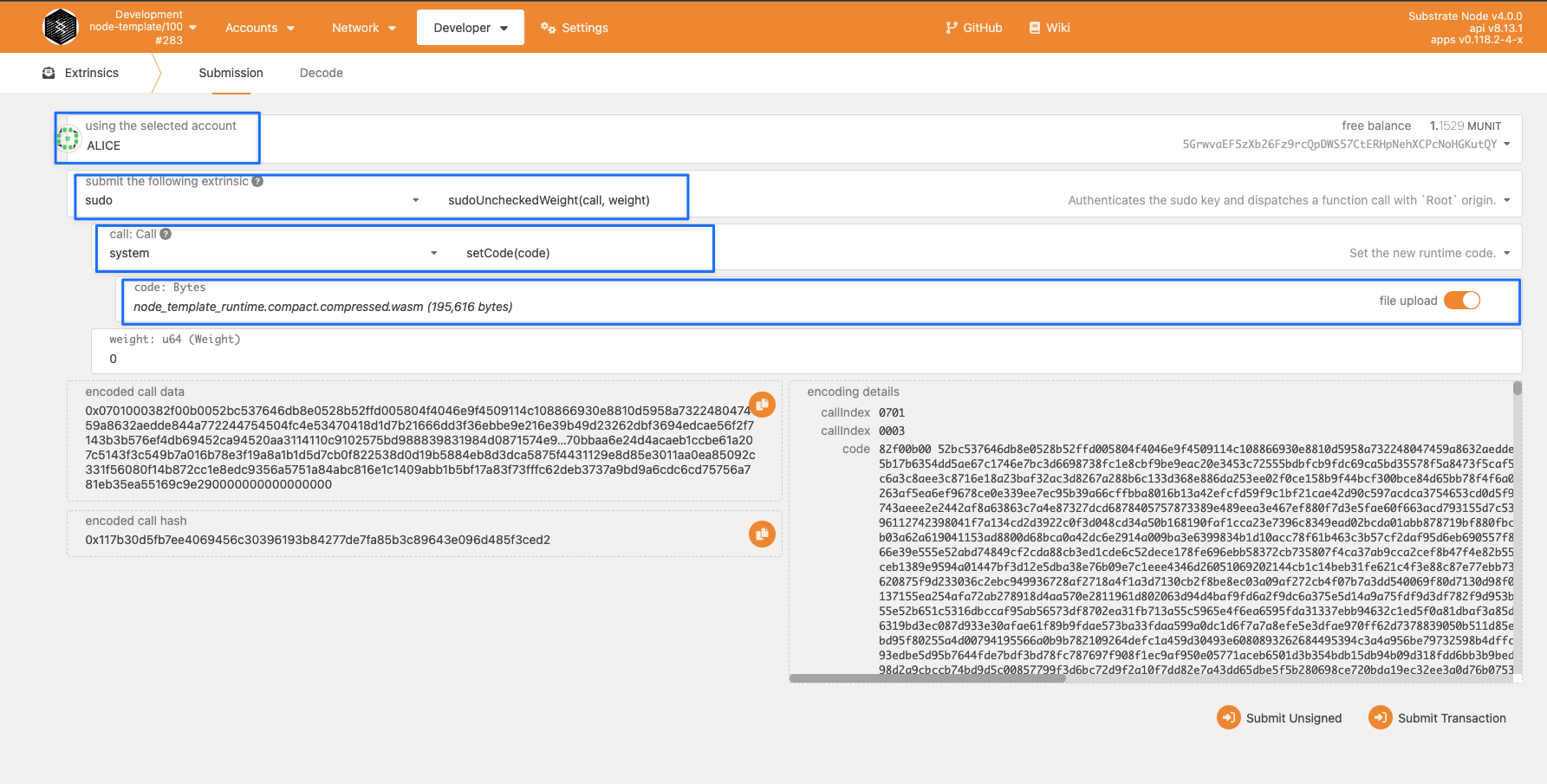

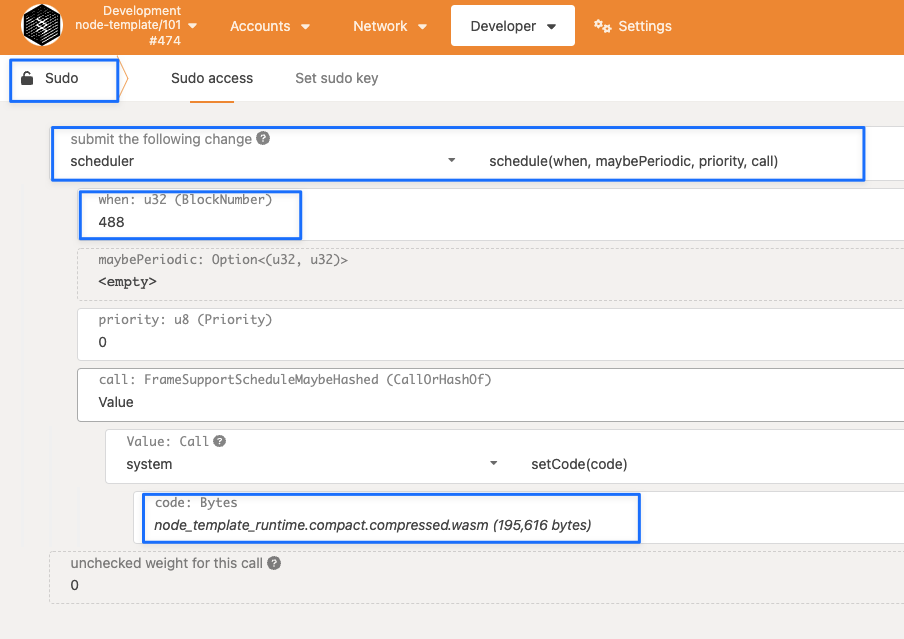

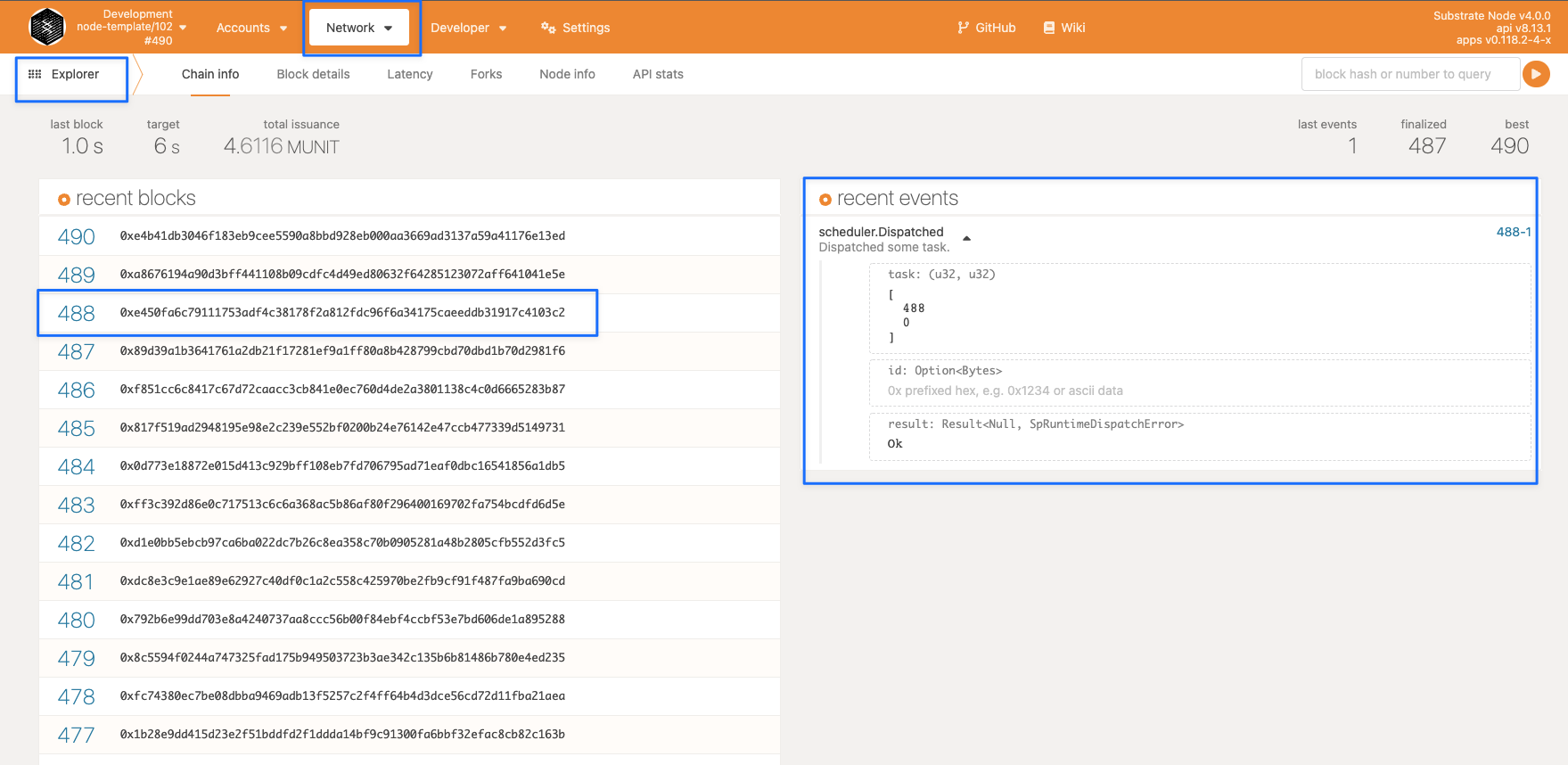

Substrate横空而出,推出了目前区块链领域最完美的升级方案。其采用“链上代码”的思想,将整个Runtime都做成了可直接更新的组件,让所有节点能够强制运行最新的Runtime代码。

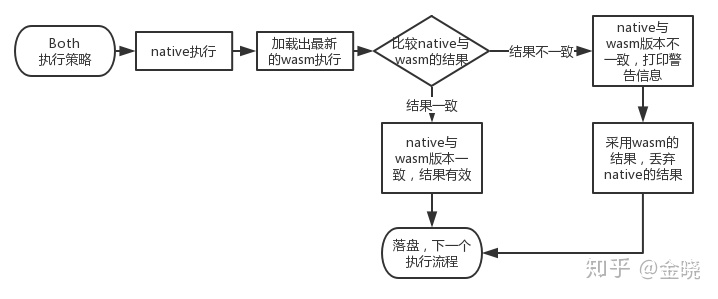

简单来说,Runtime在Substrate框架下,将会用同一份代码编译出两份可执行文件:

- 一份Rust的本地代码,我们一般称为native代码,native与其他代码无异,是这个执行文件中的二进制数据,直接运行。在Substrate的相关代码以native命名

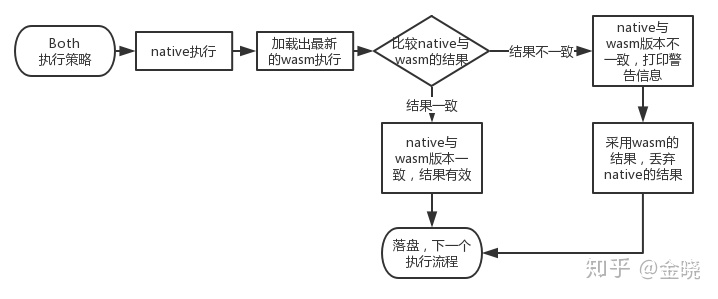

- 一份wasm的链上代码,我们一般成为wasm代码,wasm被部署到链上,所有人可获取,wasm通过构建一个wasm的运行时环境执行 。在Substrate的相关代码以wasm命名 在节点启动的时候可以选择执行策略,使用native, possible,wasm或者both。不同的执行策略会执行不同的执行文件

由于这两份代码是由相同的代码编译出来的,所以其执行逻辑完全相同 (有一些很小的暗坑要注意)。其中wasm将会部署到链上,所有人都可以获取到,也就是说即使本地运行的不是最新版本的节点,只要同步了区块,一定可以获取到最新的wasm代码。

换句话说,一个写在Runtime内部的代码,也就是代表这条链功能性的代码,存在两份,分别是native与wasm。wasm代码被部署到链上,是“链上数据”,可以通过同步区块所有人统一获取并执行。这样就可以保证在区块链中所有矿工执行的都是最新的代码。

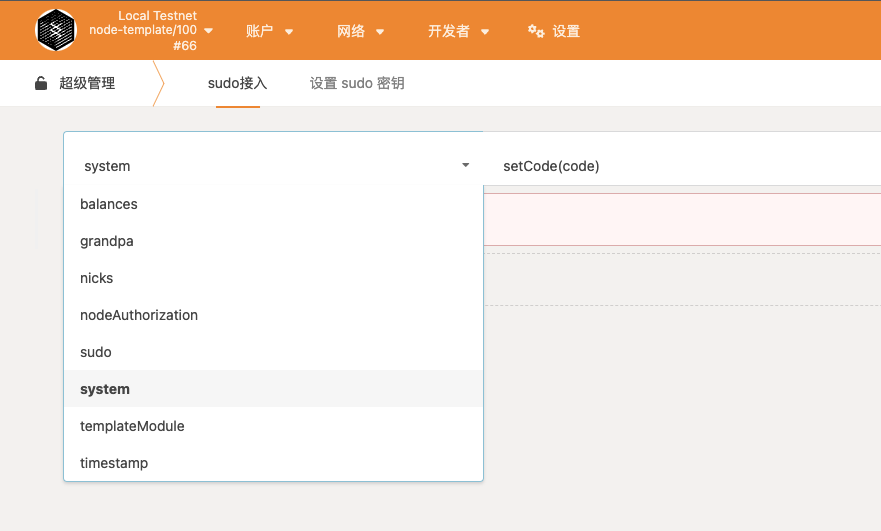

这里需要强调,代码的部署可以通过“民主提议”,“sudo控制权限”,“开发者自定一种部署条件”等方式进行,到底哪种方式“更区块链”,“更合理”,不在本文讨论范围内,这与这条链的设计目的相关。Substrate只是提供了这种“热更新”的强大机制,如何使用这种机制是这条链的问题。

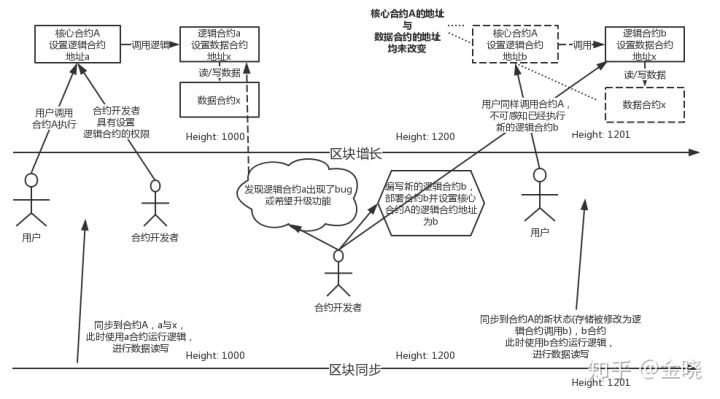

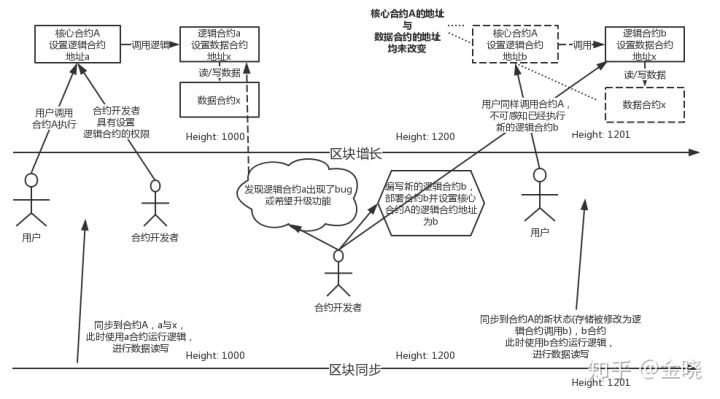

以太坊合约更新策略

由于以太坊部署一个合约后,其地址已经被固定,且数据完全存储在这个合约地址下,若这个合约需要升级功能或出现Bug,将会带来许多的问题(比如许多垃圾山寨币的ERC20合约有溢出漏洞,被攻击后损失惨重,只能通过重新部署合约,** 并将老合约的数据重新导入的方式**进行合约升级,且此时的合约地址只能使用新的了)。

许多开发人员不断探索后发展出了如下的以太坊合约升级方式:

熟悉以太坊的开发人员应该很容易理解上图表达的意思。

其核心思想是将一个合约拆分成为“逻辑合约”与“数据合约”,并使用一个“核心合约”将它们串在一起,这个核心合约就是用户的入口。

由于以太坊部署后的地址是固定的,所以将逻辑合约做成一个独立的合约,并将其地址设置在核心合约当中。那么只要更改核心合约中设置的地址,就可以更改核心合约执行的逻辑了。

并且由于以太坊的合约部署后都存在于“世界状态”当中,那么在同步区块时,老数据就会自动使用老的逻辑合约执行,而新的数据使用新的逻辑合约执行。

Substrate对应‘合约更新策略’

那么将Substrate的框架对应过来,其中:

- “核心合约”的部分就是节点采用wasm执行去从“状态”存储中加载出最新的合约代码

- “逻辑合约”的部分就是这条链的Runtime

- “数据合约”的部分就是这条链自己的状态数据

由此可见,由于wasm代码的存在,可以保证即使节点没有更新到最新版本,仍然能够以最新的代码运行,保证不会因为代码的不同而分叉。同时在节点同步老数据的过程中也不会因为本地代码是最新的而导致同步出错

项目结构

客户端架构

架构图

┏━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ___ _ _ ___ ___ _____ ___ _ _____ ___ ___ _ ___ ___ _ _ _____ ┃

┃ / __| | | | _ ) __|_ _| _ \ /_\_ _| __| / __| | |_ _| __| \| |_ _| ┃

┃ \__ \ |_| | _ \__ \ | | | / / _ \| | | _| | (__| |__ | || _|| .` | | | ┃

┃ |___/\___/|___/___/ |_| |_|_\/_/ \_\_| |___| \___|____|___|___|_|\_| |_| ┃

┃ ┃

┃ ┃

┃ ┌───────────────┐ ┌──────────────────────────────────────────────────────────┐ ┃

┃ │ │ │ │ ┃

┃ │ │ │ │ ┃

┃ │ │ │ RPC │ ┃

┃ │ │ │ │ ┃

┃ │ P2P │ │ │ ┃

┃ │ NETWORK │ └──────────────────────────────────────────────────────────┘ ┃

┃ │ │ ┌────────────────────────────────────────┐ ┌───────────────┐ ┃

┃ │ │ │ │ │ │ ┃

┃ │ │ │ ┌───────────────┐ │ │ │ ┃

┃ │ │ │ │ │ │ │ CONSENSUS │ ┃

┃ └───────────────┘ │ │ Wasm │ │ │ │ ┃

┃ .───────. │ │ Runtime │ │ │ │ ┃

┃ ,─' '─. │ │ │ │ └───────────────┘ ┃

┃ ╱ ╲░ │ └───────────────┘ │ ┃

┃ ; NATIVE :░ │ │ ┌───────────────┐ ┃

┃ : RUNTIME ;░░ │ │ │ │ ┃

┃ ╲ ╱░░░ │ STORAGE │ │ │ ┃

┃ ╲ ╱░░░ │ │ │ TELEMETRY │ ┃

┃ '─. ,─'░░░ │ │ │ │ ┃

┃ ░`─────'░░░░░ │ │ │ │ ┃

┃ ░░░░░░░ └────────────────────────────────────────┘ └───────────────┘ ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

现在我们知道了 Substrate 是什么,让我们对框架、它的移动部分以及我们可以用来创建自定义区块链的扩展点进行高级概述。 由于我们在这里处理的是去中心化的点对点系统,所以我们谈论的基本单元是节点,这是我们的区块链运行的地方。 该节点在客户端内部运行,并提供系统运行所需的所有基本组件,例如p2p网络、区块链的存储、块处理和共识的逻辑,以及从外部与区块链交互的能力。

模块说明

substrate客户端是基于substrate实现的区块链的节点客户端(可以理解为全节点), 它主要由以下几个组件组成(以下也就是告诉我们实现一条链由哪几部分组成):

存储

用来维持区块链系统所呈现的状态演变。substrate提供了的存储方式是一种简单有效的key-value对存储机制的方式。

Runtime

这里就可以回答上面的问题,什么是runtime?runtime定义了区块的处理方式,主要是状态转换的逻辑。在substrate中,runtime code被编译成wasm作为区块链存储状态的一部分。

p2p网络

允许客户端和其它网络参与者进行通信。

共识

提供了一种逻辑,能使网络参与者就区块链的状态达成一致。 substrate 支持提供自定义的共识引擎。

RPC

远程过程调用。

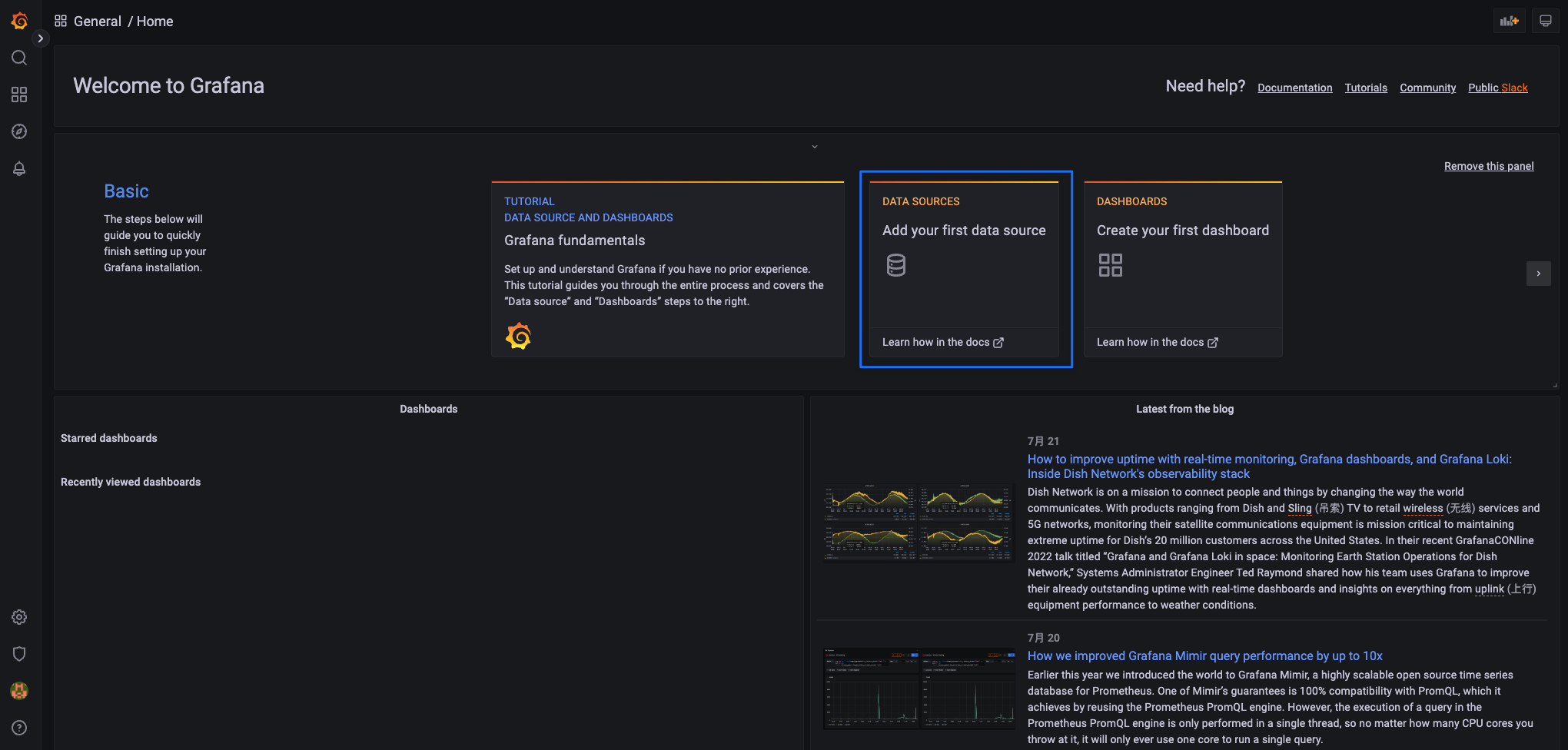

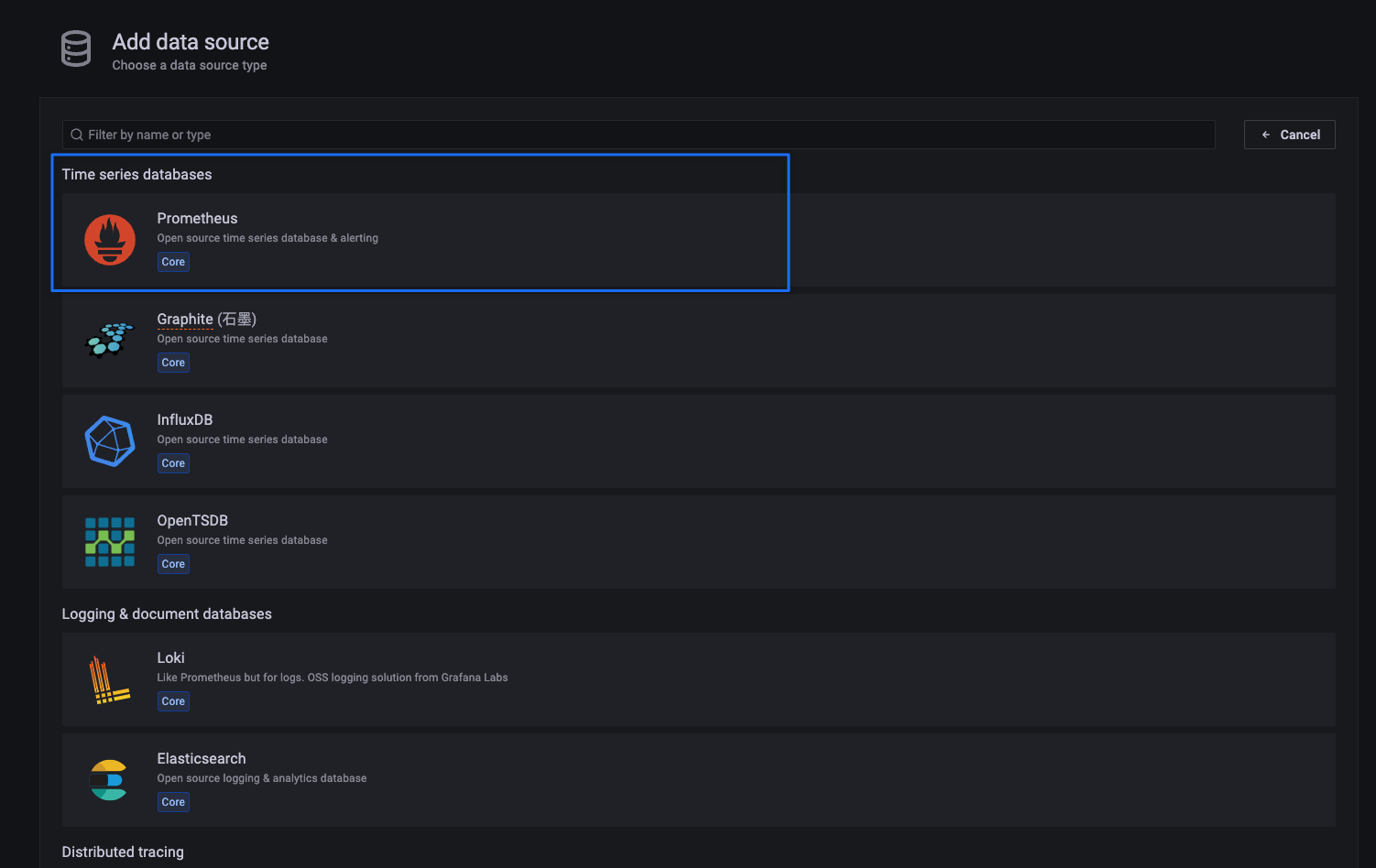

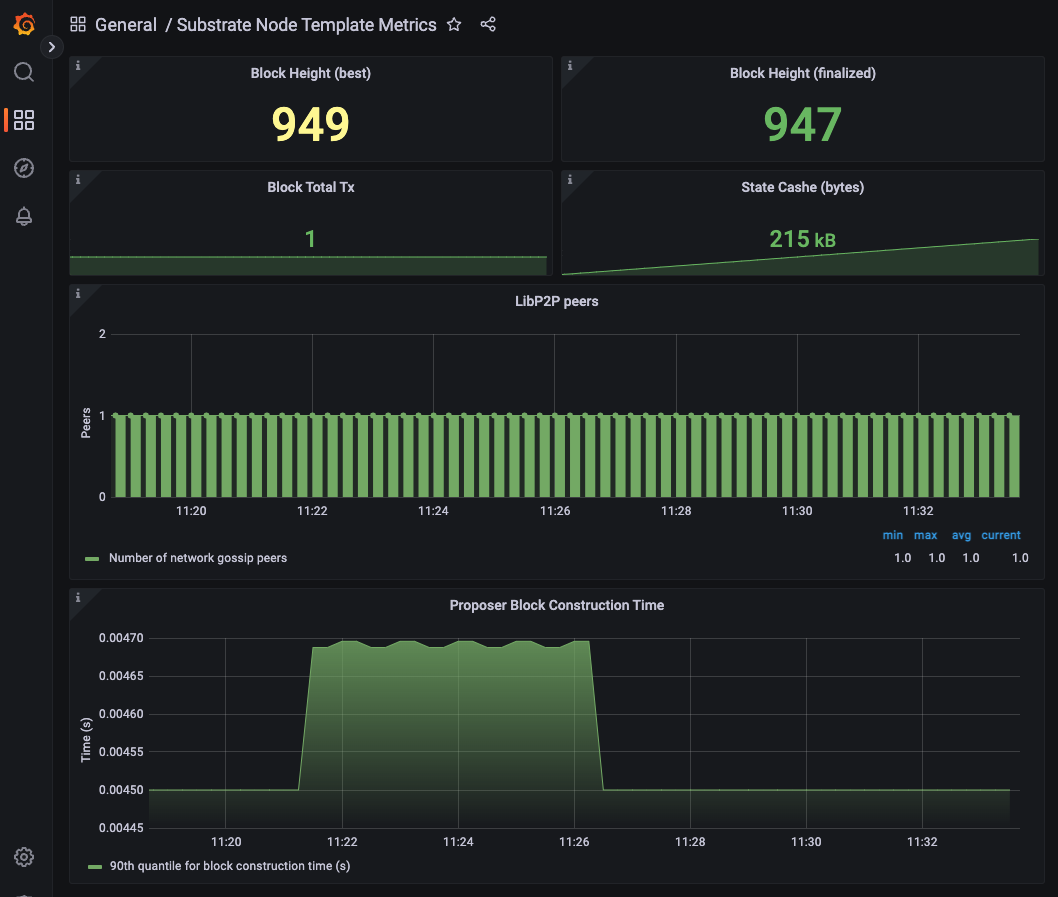

telemetry (遥测)

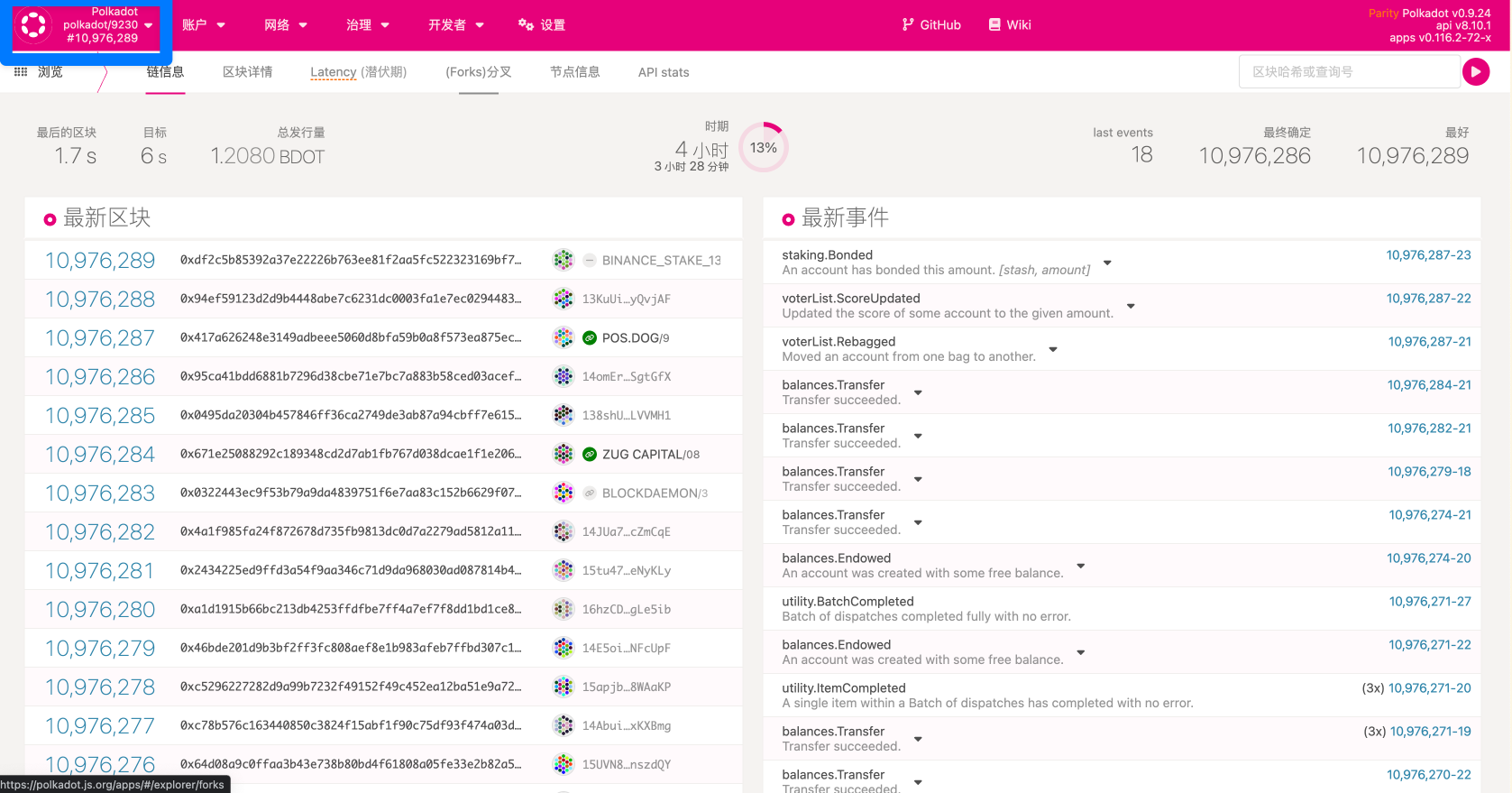

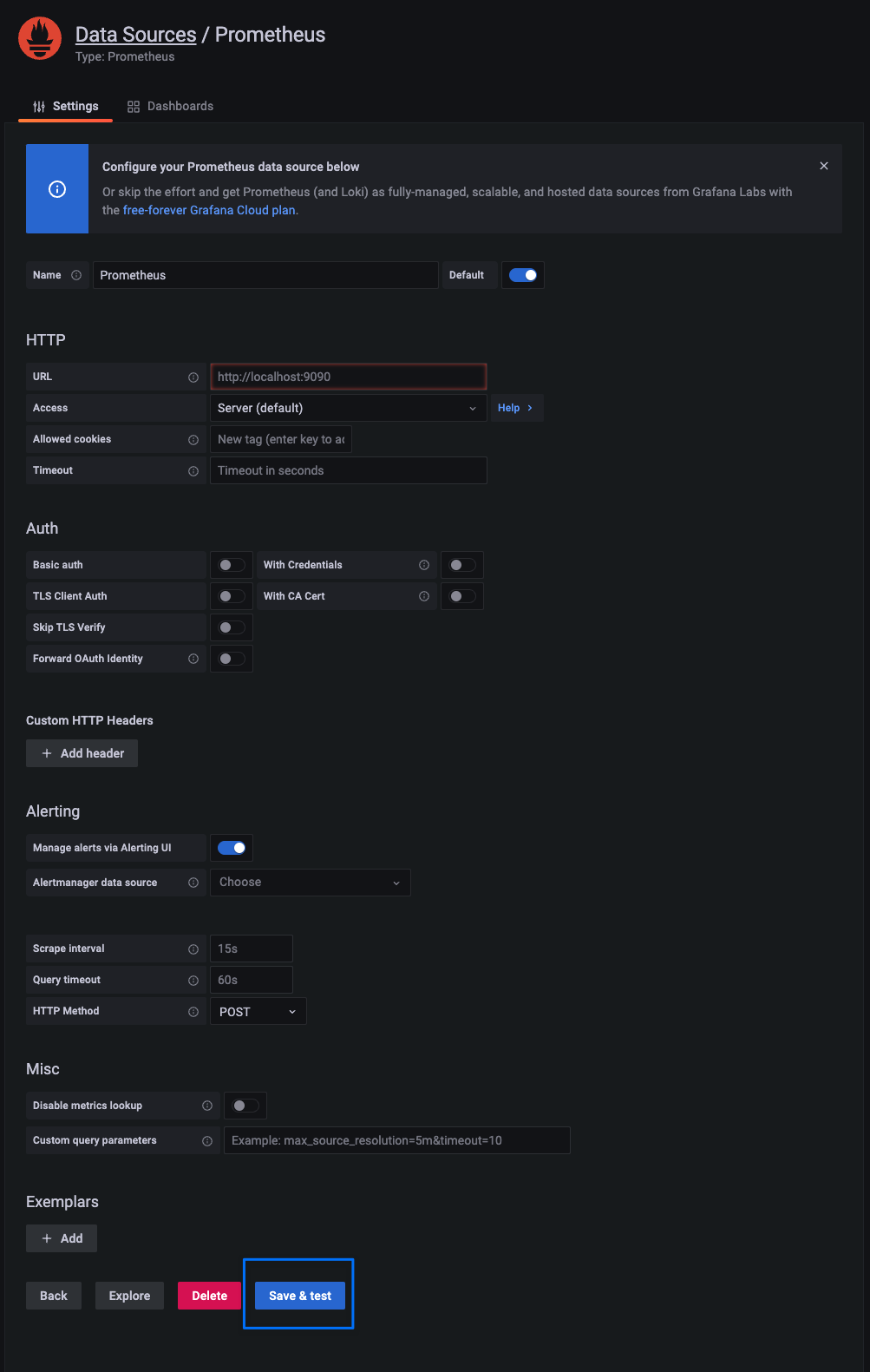

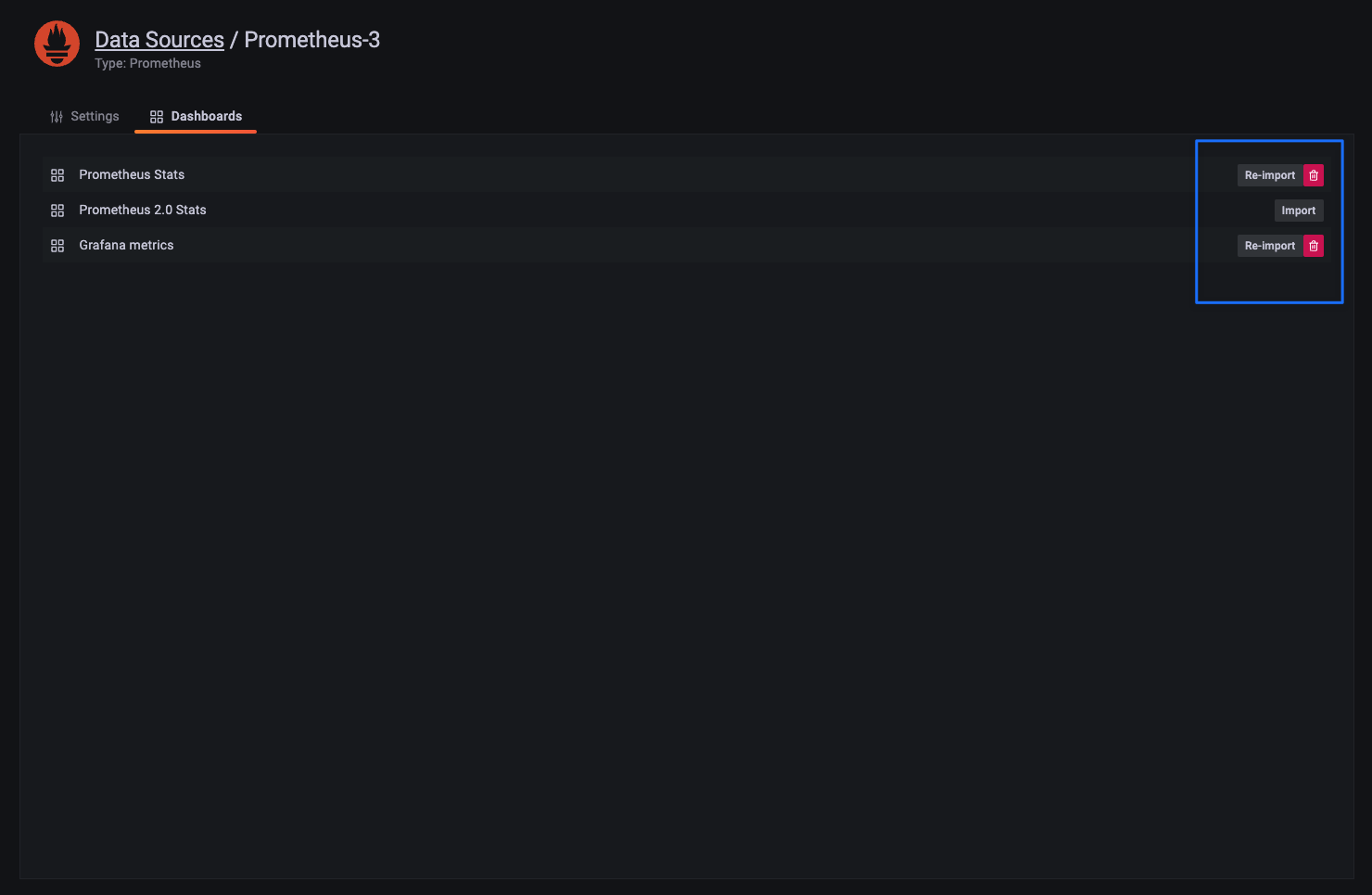

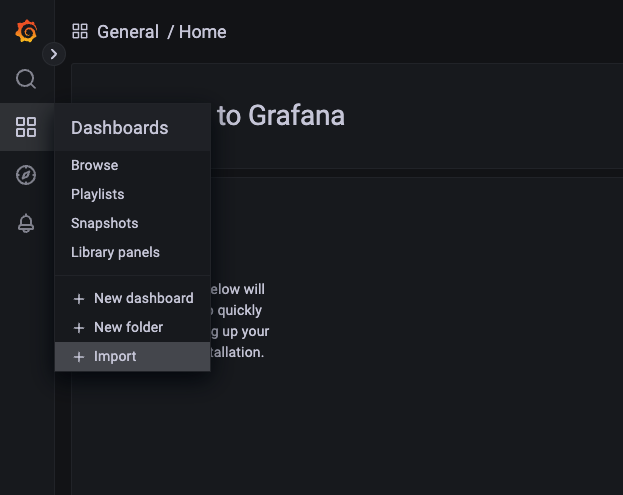

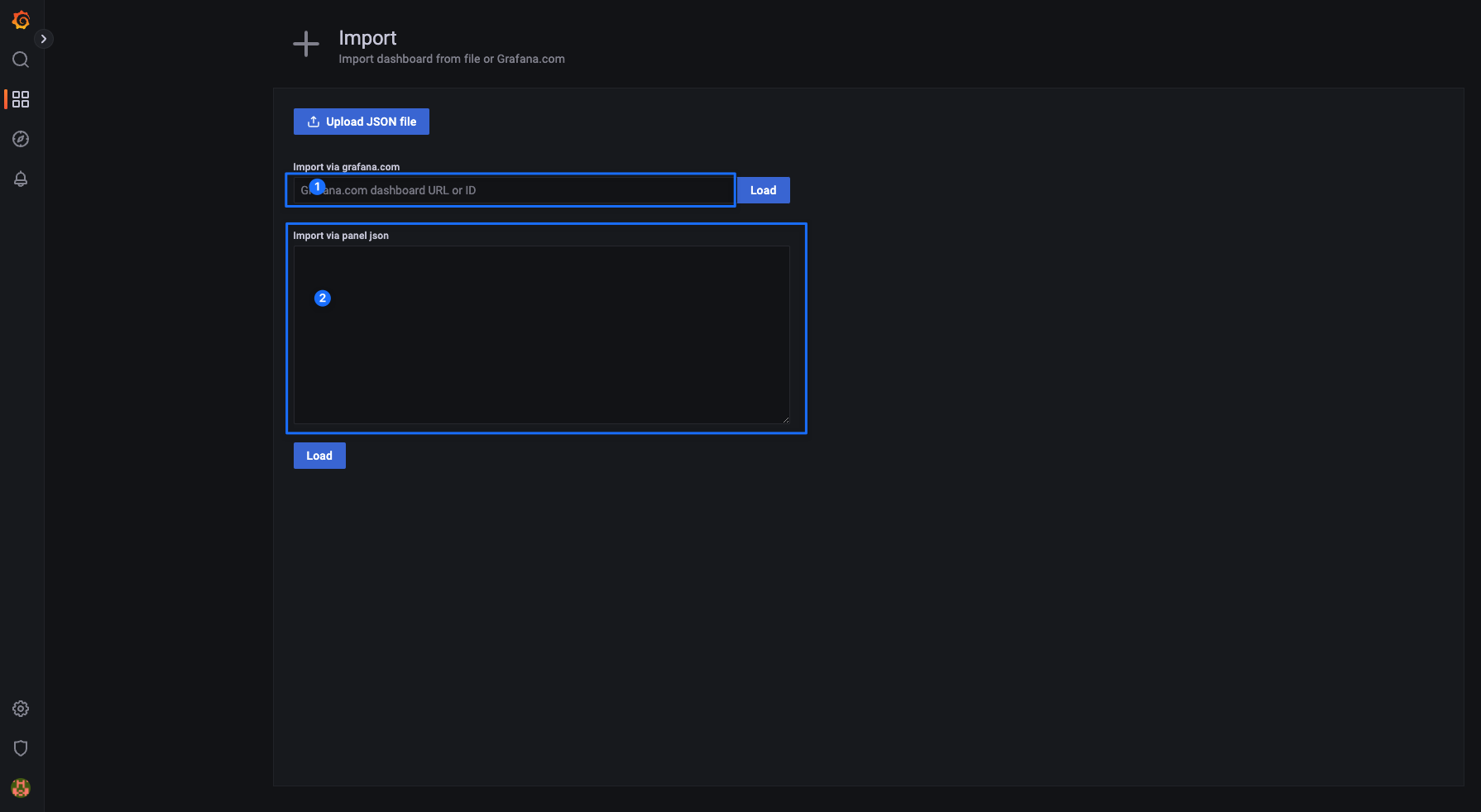

通过嵌入式Prometheus服务器的方式对外展示(我理解应该是类似于区块链浏览器一样的东西,或者是提供信息给区块链浏览器展示)。

Tree Level1

首先来看看项目的整理结构:

tree -L 1 | pbcopy ─╯

.

├── Cargo.lock

├── Cargo.toml

├── HEADER-APACHE2

├── HEADER-GPL3

├── LICENSE-APACHE2

├── LICENSE-GPL3

├── README.md

├── bin

├── client

├── docker

├── docs

├── frame

├── primitives

├── rustfmt.toml

├── scripts

├── shell.nix

├── test-utils

└── utils

9 directories, 9 files

用Cargo组织代码

Substrate非常明显使用Cargo来组织代码:

- 项目根目录的Cargo.toml会用workspace+members导入各子模块

[ workspace ]

resolver = "2"

members = [...]

- 各子模块之间也用Cargo.toml来相互导入使用

[ dependencies ]

sc-consensus = { version = "0.10.0-dev", path = "../../client/consensus/common" }

主要部分介绍:Node、Frame、Core

Substrate Node:

我们将从 Substrate Node 开始。这是我们可以开始的最高级别;

它提供了最多的预建功能和最少的技术自由度。它是完全可运行的,包括所有基本组件的默认实现,例如:

- 账户管理

- 特权访问

- 共识

- …

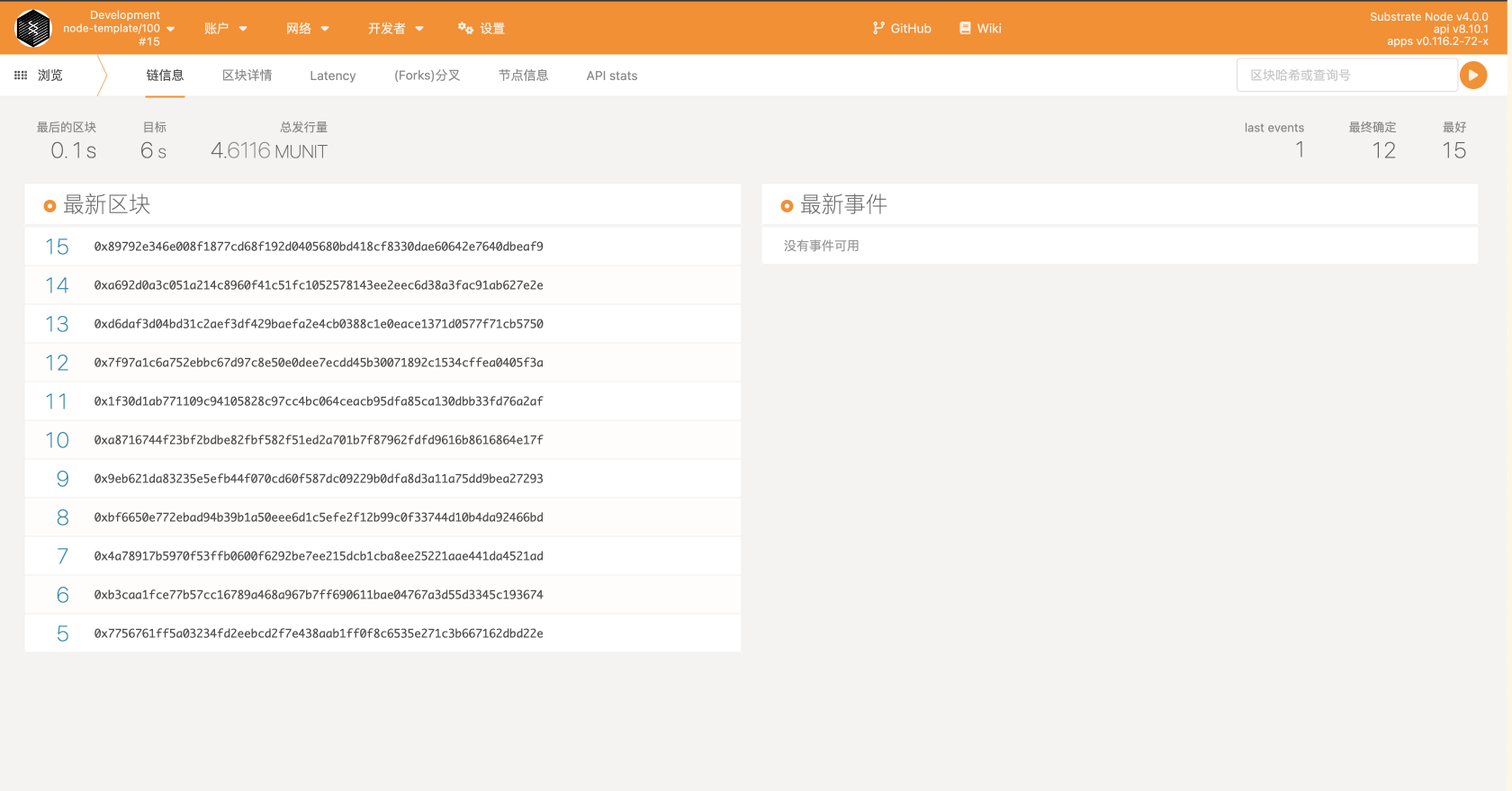

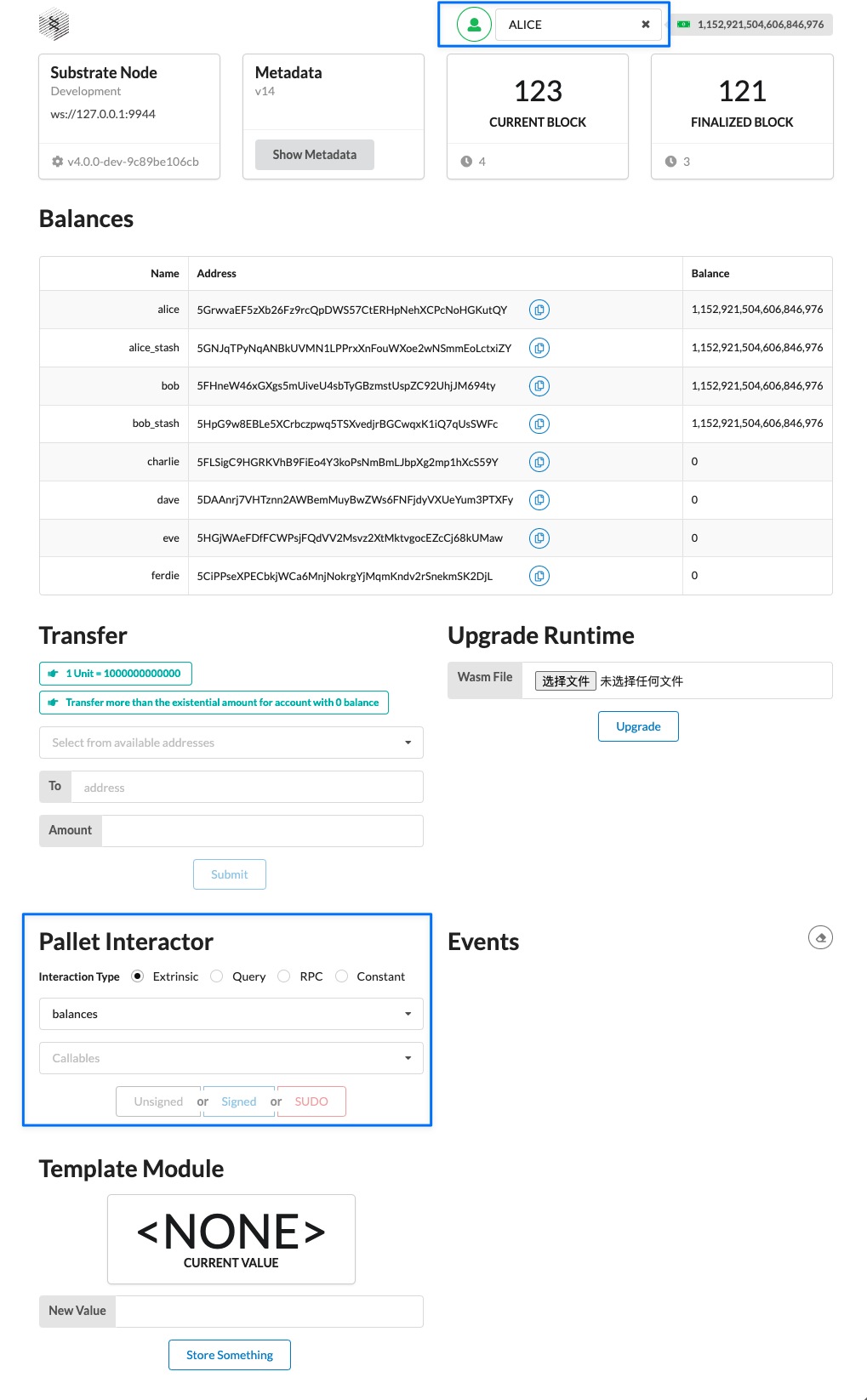

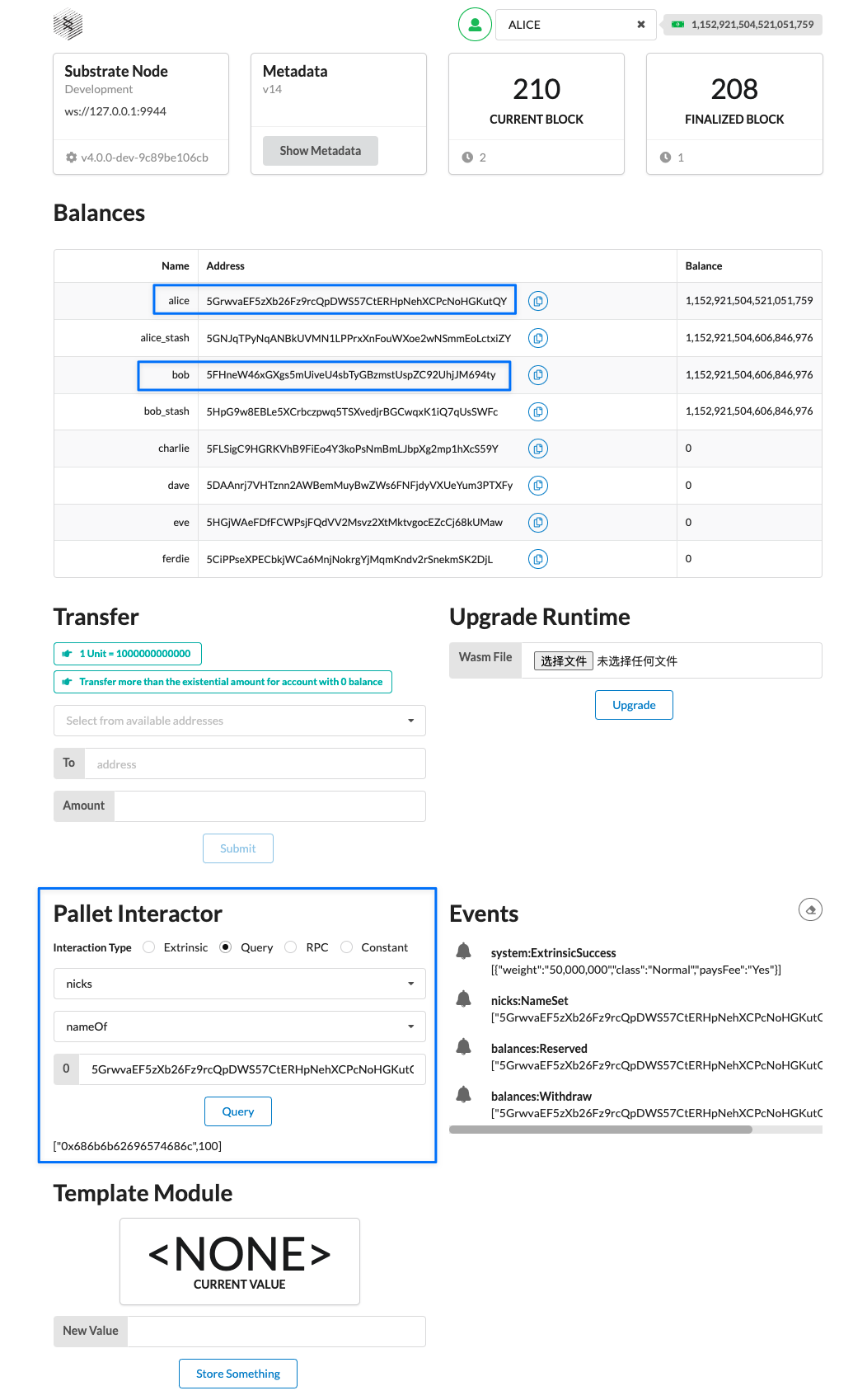

我们可以自定义链的创世块(即初始状态)以开始。 在这里,我们可以运行节点并熟悉 Substrate 提供的开箱即用的功能,玩转状态并与正在运行的区块链交互以熟悉。

另一种实现相同目的的方法是使用 Substrate Playground,您可以在其中查看后端和前端模板以熟悉它们。 然而,一旦我们准备好真正构建自己的区块链,我们最好降低一层并使用 FRAME。

tree bin -L 2 | pbcopy ─╯

bin

├── node

│ ├── bench

│ ├── cli

│ ├── executor

│ ├── inspect

│ ├── primitives

│ ├── rpc

│ ├── runtime

│ └── testing

├── node-template: 使用Substrate写项目的基础模版

│ ├── LICENSE

│ ├── README.md

│ ├── docker-compose.yml

│ ├── docs

│ ├── node

│ ├── pallets

│ ├── runtime

│ ├── scripts

│ └── shell.nix

└── utils

├── chain-spec-builder

└── subkey

18 directories, 4 files

重点说说node、pallets和runtime

│ ├── node: 链的一些基础功能的实现(或者说比较底层的实现,如网络、rpc,搭建链的最基础的code) │ ├── pallets: 放置的就是各个pallet,也就是业务相关的模块 │ ├── runtime: 可以简单理解为把所有pallet组合到一起,也就是业务相关的逻辑

三者的关系大致如下:

┏━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ___ _ _ ___ ___ _____ ___ _ _____ ___ _ _ ___ ___ ___ ┃

┃ / __| | | | _ ) __|_ _| _ \ /_\_ _| __| | \| |/ _ \| \| __| ┃

┃ \__ \ |_| | _ \__ \ | | | / / _ \| | | _| | .` | (_) | |) | _| ┃

┃ |___/\___/|___/___/ |_| |_|_\/_/ \_\_| |___| |_|\_|\___/|___/|___| ┃

┃ ┃

┃ ┃

┃ ┃

┃ ┏━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓ ┃

┃ ┃ ___ _ _ _ _ _____ ___ __ __ ___ ┃ ┃

┃ ┃ | _ \ | | | \| |_ _|_ _| \/ | __| ┃ ┃

┃ ┃ | / |_| | .` | | | | || |\/| | _| ┃ ┃

┃ ┃ |_|_\\___/|_|\_| |_| |___|_| |_|___| ┃ ┃

┃ ┃ ┃ ┃

┃ ┃ ┃ ┃

┃ ┃ ┃ ┃

┃ ┃ ┃ ┃

┃ ┃ ┌───────────────┐ ┌───────────────┐ ┌───────────────┐ ┌───────────────┐ ┃ ┃

┃ ┃ │ │ │ │ │ │ │ │ ┃ ┃

┃ ┃ │ pallet 1 │ │ pallet 2 │ │ ... │ │ pallet n │ ┃ ┃

┃ ┃ │ │ │ │ │ │ │ │ ┃ ┃

┃ ┃ └───────────────┘ └───────────────┘ └───────────────┘ └───────────────┘ ┃ ┃

┃ ┃ ┃ ┃

┃ ┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

当然,对于pallets来说,在runtime中使用的pallet,有些是我们自己开发的pallet,有些是substrate中已经开发好的pallet,甚至还有些是pallet是第三方开发的pallet。

Substrate FRAME

FRAME (Framework for Runtime Aggregation of Modularized Entities) 是一个框架,用于从现有库构建 Substrate 运行时(Runtime) ,并具有高度的自由度来确定我们的区块链逻辑。

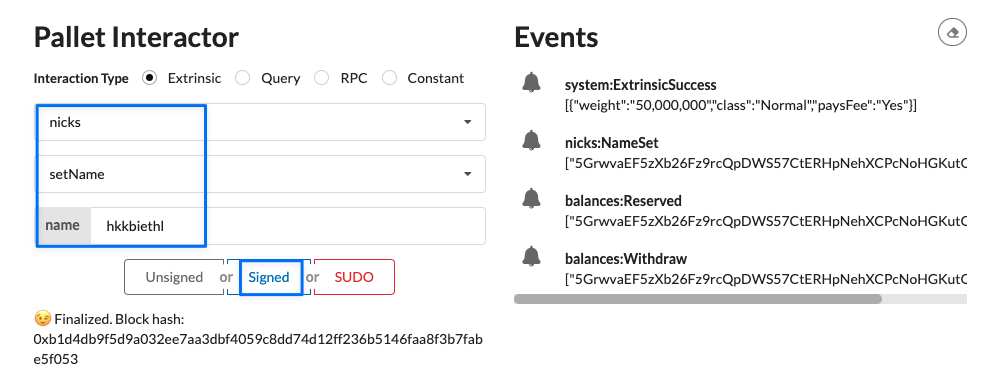

我们基本上是从 Substrate 的预构建节点模板开始,可以添加所谓的托盘(pallet, Substrate 库模块的名称)来定制和扩展我们的链。

在这个抽象级别,我们还能够完全自定义我们区块链的逻辑、状态和数据类型。这当然是大多数旨在接近 Substrate 的基本定制项目在易于开发和技术自由之间利用两全其美的地方。

我们仍然需要在它们到来时采用一些默认值——或者更确切地说,因为它们可以被配置——但是如果我们从根本上想要做不同的事情,我们可以从 Core 开始再降低一步。

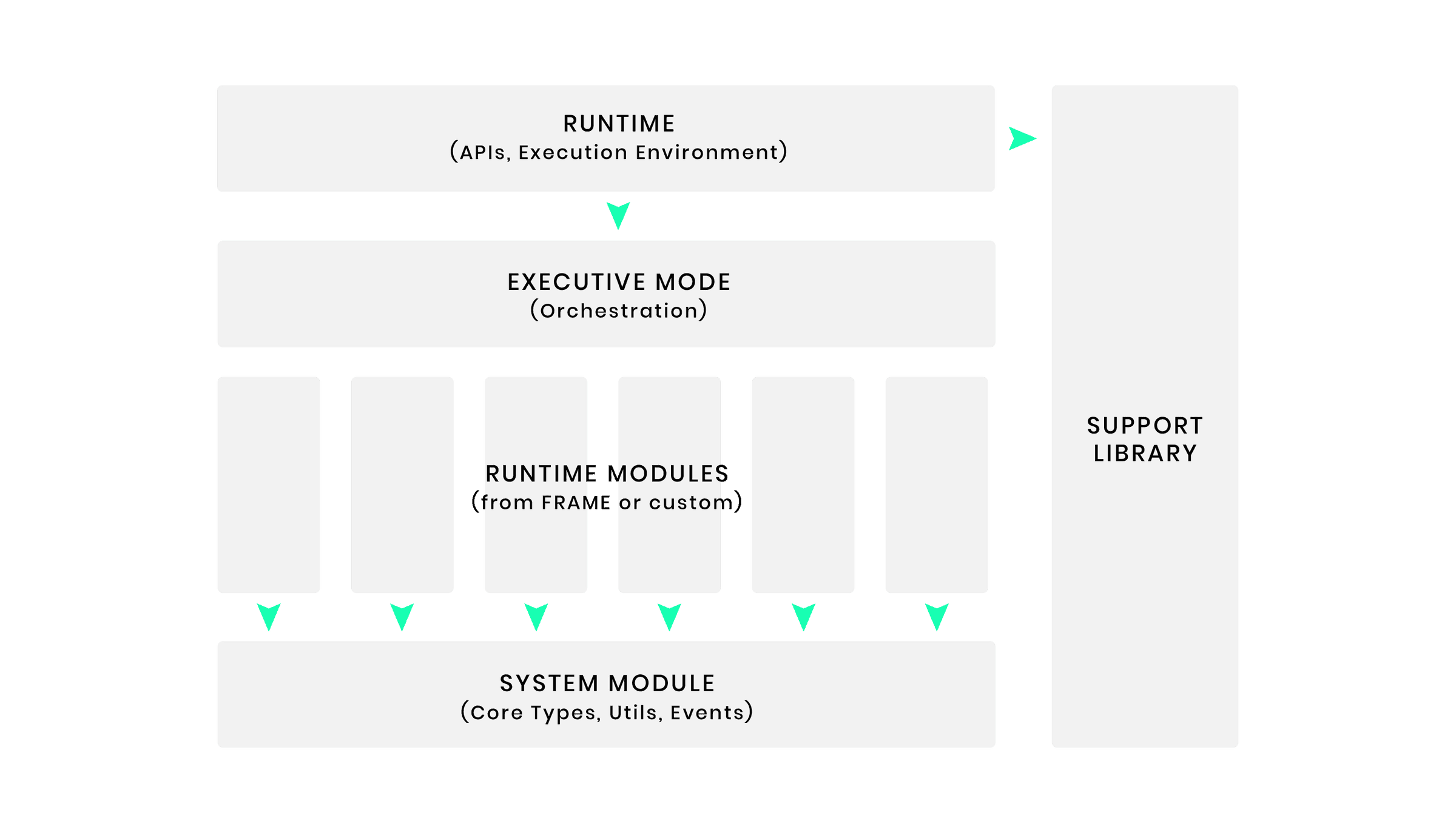

The Framework for Runtime Aggregation of Modularized Entities (FRAME) is a set of modules and support libraries that simplify runtime development. In Substrate , these modules are called Pallets, each hosting domain-specific logic to include in a chain’s runtime.

FRAME also provides some helper modules to interact with important Substrate Primitives that provide the interface to the core client.

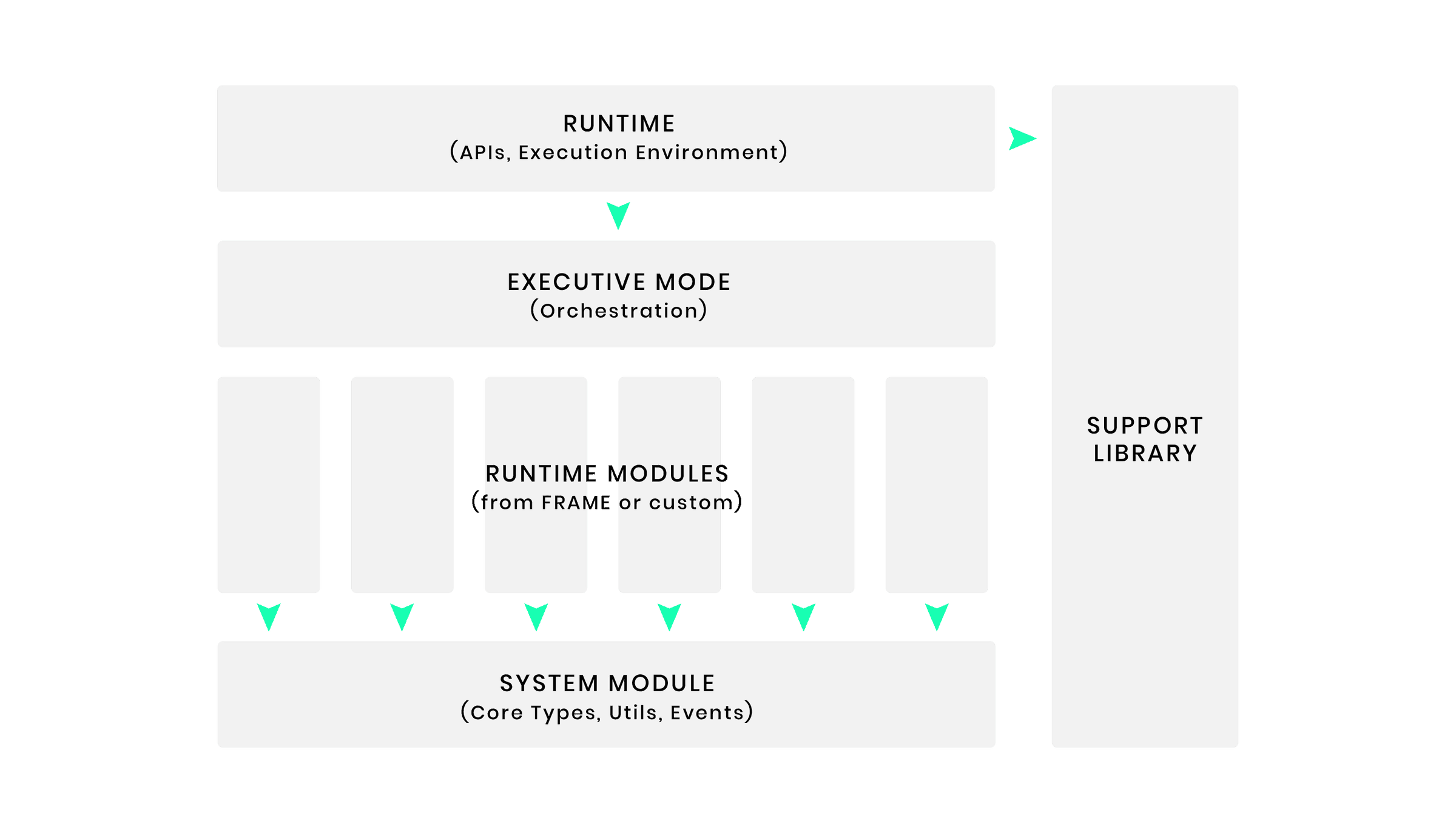

The following diagram shows the architectural overview of FRAME and its support libraries:

tree frame -L 1 | pbcopy

frame

├── alliance: The Alliance Pallet provides a collective that curates a list of accounts and URLs, deemed by the voting members to be unscrupulous actors.

├── assets: A simple, secure module for dealing with fungible assets. The Assets module provides functionality for asset management of fungible asset classes with a fixed supply

├── atomic-swap: A module for atomically sending funds.

├── aura: The Aura module extends Aura consensus by managing offline reporting.

├── authority-discovery: This module is used by the client/authority-discovery to retrieve the current set of authorities.

├── authorship

├── babe

├── bags-list

├── balances: The Balances module provides functionality for handling accounts and balances.

├── beefy

├── beefy-mmr

├── benchmarking

├── bounties

├── child-bounties

├── collective

├── contracts

├── conviction-voting

├── democracy

├── election-provider-multi-phase

├── election-provider-support

├── elections-phragmen

├── examples

├── executive

├── gilt

├── grandpa

├── identity

├── im-online

├── indices

├── lottery

├── membership

├── merkle-mountain-range

├── multisig

├── nicks

├── node-authorization

├── nomination-pools

├── offences

├── preimage

├── proxy

├── randomness-collective-flip

├── ranked-collective

├── recovery

├── referenda

├── remark

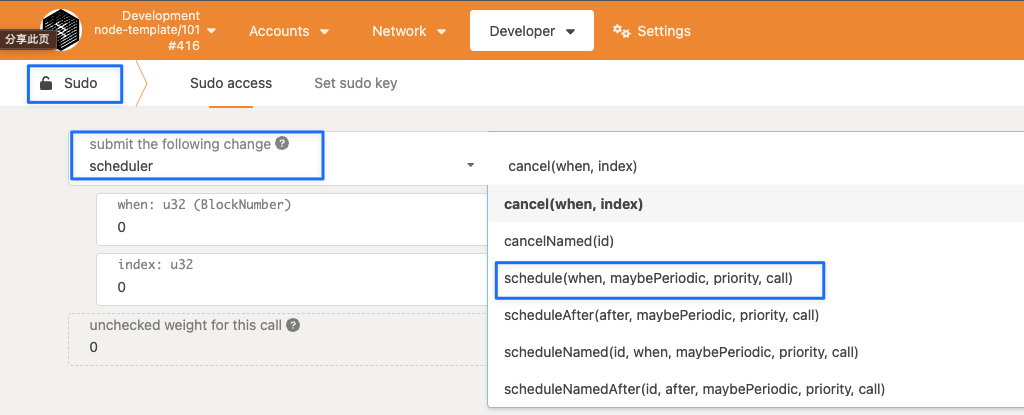

├── scheduler

├── scored-pool

├── session

├── society

├── staking

├── state-trie-migration

├── sudo

├── support

├── system

├── timestamp

├── tips

├── transaction-payment

├── transaction-storage

├── treasury

├── try-runtime

├── uniques

├── utility

├── vesting

└── whitelist

62 directories, 0 files

Substrate Core(client)

Substrate Core 本质上意味着我们可以以任何我们想要的方式实现我们的运行时,只要它以 WebAssembly 为目标并遵守 Substrate 块创建的基本法则。

然后,我们可以使用这个运行时并在 Substrate 节点中运行它。

说到 Substrate 的生态系统,有一个充满活力(充满活力)的开发者社区,他们在自己的项目中使用 Substrate,其中许多人通过共享自己的托盘(pallet)来回馈生态系统。

您可以通过使用诸如 Substrate Market 之类的站点或仅在托管 crates.io: Rust Package Registry 的任何地方找到托盘(pallet),因为 Substrate 托盘本质上是自包含的 Rust 库,您可以将其集成到您的 Substrate 项目中, 并根据需要进行配置。

与任何其他库一样,建议首先审核代码,并了解依赖外部代码与编写自己的代码之间的权衡。

在玩了一点预建节点之后,我们应该专注于 FRAME,学习如何通过在 Substrate 模板节点之上构建自定义区块链。这也是许多精彩教程的起点。

tree client -L 1 | pbcopy ─╯

client

├── allocator

├── api

├── authority-discovery

├── basic-authorship

├── beefy

├── block-builder

├── chain-spec

├── cli

├── consensus

├── db

├── executor

├── finality-grandpa

├── informant

├── keystore

├── network

├── network-gossip

├── offchain

├── peerset

├── proposer-metrics

├── rpc

├── rpc-api

├── rpc-servers

├── service

├── state-db

├── sync-state-rpc

├── sysinfo

├── telemetry

├── tracing

├── transaction-pool

└── utils

30 directories, 0 files

其他

primitives

tree primitives -L 1 | pbcopy

primitives

├── api

├── application-crypto

├── arithmetic

├── authority-discovery

├── authorship

├── beefy

├── block-builder

├── blockchain

├── consensus

├── core

├── database

├── debug-derive

├── externalities

├── finality-grandpa

├── inherents

├── io

├── keyring

├── keystore

├── maybe-compressed-blob

├── merkle-mountain-range

├── npos-elections

├── offchain

├── panic-handler

├── rpc

├── runtime

├── runtime-interface

├── sandbox

├── serializer

├── session

├── staking

├── state-machine

├── std

├── storage

├── tasks

├── test-primitives

├── timestamp

├── tracing

├── transaction-pool

├── transaction-storage-proof

├── trie

├── version

└── wasm-interface

42 directories, 0 files

scripts/ci

tree scripts/ci | pbcopy

scripts/ci

├── common

│ └── lib.sh

├── deny.toml

├── docker

│ ├── subkey.Dockerfile

│ └── substrate.Dockerfile

├── github

│ ├── check_labels.sh

│ └── generate_changelog.sh

├── gitlab

│ ├── check_runtime.sh

│ ├── check_signed.sh

│ ├── ensure-deps.sh

│ ├── pipeline

│ │ ├── build.yml

│ │ ├── check.yml

│ │ ├── publish.yml

│ │ └── test.yml

│ ├── publish_draft_release.sh

│ └── skip_if_draft.sh

├── monitoring

│ ├── alerting-rules

│ │ ├── alerting-rule-tests.yaml

│ │ └── alerting-rules.yaml

│ └── grafana-dashboards

│ ├── README_dashboard.md

│ ├── substrate-networking.json

│ └── substrate-service-tasks.json

├── node-template-release

│ ├── Cargo.toml

│ └── src

│ └── main.rs

└── node-template-release.sh

10 directories, 23 files

utils

tree utils -L 1 | pbcopy

utils

├── build-script-utils

├── fork-tree

├── frame

├── prometheus

└── wasm-builder

5 directories, 0 files

功能逻辑

特色代码

参考资源

online-book

- paritytech/substrate: Substrate: The platform for blockchain innovators

- Architecture | Substrate_

- substrate轻松学

fragment

- 链块与分散的数据 - 知乎

- 区块链与substrate

- substrate 源码解析与运用 - 介绍 - 知乎

- Substrate区块链开发 - 知乎

- Substrate Ecosystem | Substrate_

- Substrate blockchain development: Core concepts - LogRocket Blog:对Substrate的简要介绍

- Playground | Substrate_

- Substrate Market

- crates.io: Rust Package Registry

- Quick start | Substrate Docs

- Tutorials | Substrate Docs

- Projects | Substrate_: 一些基于Substrate建立的项目,值得参考

- Build the Substrate Kitties Chain | Substrate_: 教你建立一个nft平台

- FRAME | Substrate_

- The Substrate Guide I Wish I Had. Fractal’s blockchain lead Shelby… | by Fractal | Fractal | Medium

- How-to quick reference guides | Substrate Docs

Runtime

- 剖析Substrate Runtime - 知乎

基于Substrate开发自己的运行时模块,会遇到一个比较大的挑战,就是理解Substrate运行时(Runtime)。 本文首先介绍了Runtime的架构,类型,常用宏,并结合一个实际的演示项目,做了具体代码分析,以帮助大家更好地理解在Substrate中它们是如何一起工作的。

local

漫话Rust

话题

为什么觉得 Rust 难上手,尤其是生命周期? - 知乎

因为其他语言上手真的就只是上手而已,你还得买《Effective Xxxx》甚至《More Effective Xxxx》,以及《Xxx并发编程》《深入理解Xxx虚拟机》等等各种书籍来学习各种避坑、省力、debug技巧。而Rust的上手是把这些技巧直接掺在上手过程里了,编译器以及配套工具(比如错误提示里的help,fmt、clippy)逼着你把代码写对,上手Rust等于同时被迫学会了这一堆技巧。

- 学习 rust 上手难一般是因为缺乏丰富的 Cpp 经验。因此,大家会对【胖指针】【瘦指针】【虚表 vtable 】等基础概念缺少深刻的理解。而这些概念正是区分 rust 中【编译期间-抽象 — 单态化】与【运行期间-抽象 —

trait Object】的认知“门槛”。 - 另一方面,学习lifetime 上手难是因为大家已经习惯了“颐指气使”地向计算机“发号施令”和下达指示了。

- 但是, lifetime 完全是另一码事。就【生命周期】而言, rustc 的角色是【仲裁者】,而不是【执行者】。

【生命周期·标注】被设计用来:由 @程序员 向【仲裁者 rustc 】表述自己的代码设计意图(这些意图通过直接扫描代码不容易被揣测出来)。然后,再由【仲裁者】判断你的代码意图是否可行,因为代码首先得足够安全。

所以,你不能命令 rustc :我要求某某变量一定得活多长时间(一切皆可操控,那是 Cpp);而是,询问 rustc :我如此设计代码,想让某某变量活这么长时间,你看行得通吗?若 rustc 判定行不通,那么一个编译错误就等着你了。

比如说,函数的【生命周期_泛型参数】是被用来将

- 引用类型的函数入参的生命周期与

- 引用类型的函数返回值的生命周期关联起来。

以便,在对代码做【静态分析】时,编译器能够根据(已知)入参推断出函数返回值的生命周期。

这是帮助编译器理解咱们代码的“脚注”,而不是给编译器下达的“指示”。得和

rustc“商量”着来。

底层抽象

介绍

从计算机组成原理了解到操作系统,当一个程序开始运行的时候,不论是可执行程序还是命令行,都会从创建进程,申请进程资源开始,再到堆栈(stack/heap) 的使用,申请与释放资源。这一系列操作对于编程来说重要性不言而喻,只不过根据编程语言的高级程度不同,开发者需要掌握的知识也有不同。

而在rust语言编程中,内存的管理方式及其重要。所以这一层主要先介绍虚拟内存管理以及相关出现的内容安全问题,接着介绍rust是如何通过所有权、作用域和生命周期,引申出借用、移动语义、复制语义等一系列内容来解决内存安全问题。

Rust语言架构

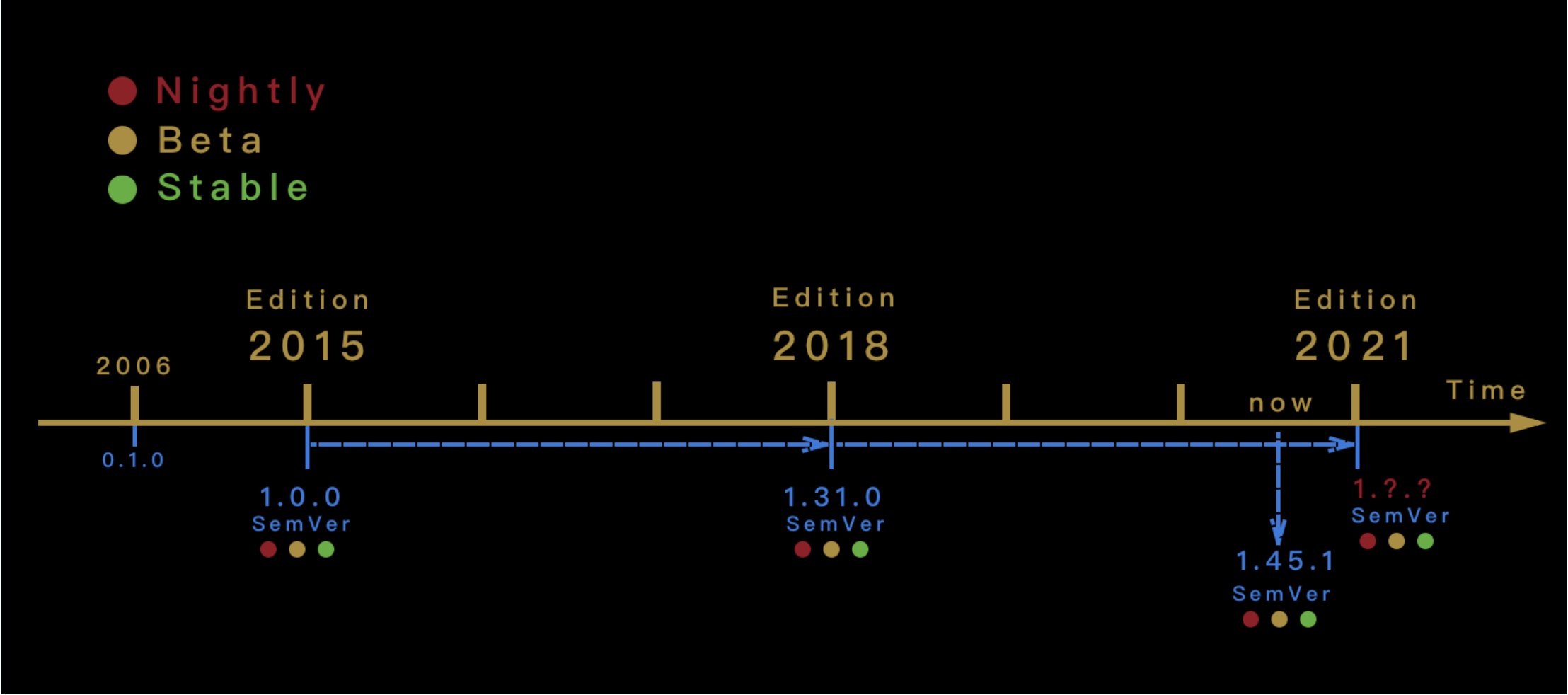

Rust语言版本说明

Rust编译步骤

Rust编译过程与宏展开

这里主要参考下列内容

- RustcRustc/rustc-dev-guide-zh: Rustc Dev Guide 中文翻译

- About this guide - Guide to Rustc Development

- Rust编译器专题 | 图解 Rust 编译器与语言设计 Part 1 - Rust精选

参考资源

online-book

fragment

local

内存管理与内存安全

参考

online-book

fragment

local

所有权三件套:所有权、借用与生命周期

- 所有权三件套:所有权、借用与生命周期

综述

┌───────────────────────────────────┐

│ │

│ │

│ .───────. ┌──────┐ │

│ ,' `. │Borrow│ │

│ ,' `. └──────┘ │

│ ; ┌─────────┐ : │

│ │ │OwnerShip│ │ │

│ │ └─────────┘ │ │

│ : ┌─────┐ ; ┌────────┐ │

│ ╲ │Scope│ ╱ │Lifetime│ │

│ `. └─────┘ ,' └────────┘ │

│ `. ,' │

│ `─────' │

│ │

│ │

└───────────────────────────────────┘

所有权、作用域、借用与生命周期是 Rust 的内存安全及其零成本抽象原则的核心。 它们让 Rust 能够在编译期检测程序中内存安全违规,在离开作用域时自动释放相关资源等情况。 所有权有点类似核心原则,而借用和生命周期是对语言类型系统的扩展。在代码的不同上下文中加强或有时放松所有权原则,可确保编译期内存管理正常运作。

所有权语义模型

所有权与内存管理

所有权

资源所有者

程序中资源的真正所有者的概念因语言而异。这里的含义是通过资源, 主要包含下列内容:

- 共同引用在堆或堆栈上保存值的任何变量

- 或者是包含打开文件描述符、数据库连接套接字、网络套接字及类似内容的变量。

从它们存在到完成程序调用及其之后的时间,都会占用一些内存。

资源所有者负责释放

资源所有者的一个重要职责就是明智地释放它们使用的内存,因为如果无法在适当的位置和时间执行取消内存分配,就可能导致内存泄漏。

动态语言靠GC在运行期处理

在使用 Python 等动态语言编程时,可以将多个所有者或别名添加到 list 对象中,从而使用执行该对象的众多变量之一添加或删除 list 中的项目。变量不需要关心如何释放对象使用过的内存,因为 GC 会处理这些事情,并且一旦指向对象的所有引用都消失,GC 就会释放相关的内存。

静态语言在编译期规定

对于 C/C++/Golang之类的编译语言,在智能指针出现之前,程序库对代码使用完毕的相关资源 API 的调用方或者被调用方是否负责释放内存有明确的规定。存在这些规则是因为编译器不会在这些语言中强制限定所有权。在 C++中不使用智能指针仍然有可能出现问题。在C++中,存在多个变量指向堆上的某个值是完全没问题的(尽管我们不建议这么做) ,这就是所谓的别名。由于具有指向资源的多个指针或别名的灵活性,程序员会遇到各种各样的问题,其中之一就是 C++中的迭代器失效问题。

具体而言,当给定作用域中资源的其他不可变别名相对存在至少一个可变别名时,就会出现问题

Rust的所有权规则

Rust 试图为程序中值的所有权设定适当的语义。Rust 的所有权规则遵循以下原则。

- 使用 let 语句创建值或资源,并将其分配给变量时,该变量将成为资源的所有者。

- 当值从一个变量重新分配给另一个变量时, 值的所有权将转移至另一个变量, 原来的变量将失效以便另作他用。

- 值和变量在其作用域的末尾会被清理、释放。

揣摩所有权含义

需要注意的是,Rust 中的值只有一个所有者,即创建它们的变量。其理念很简单,但是它的含义值得揣摩:

// ownership_basics.rs #[derive(Debug)] struct Foo(u32); fn main() { // 根据所有权规则, foo 是 Foo 实例的所有者 let foo = Foo(2048); /* bar 成为Foo 实例的新所有者, 而旧的 foo 是一个废弃变量. 经过此变动之后不能在其他任何地方使用 */ let bar = foo; // value moved here /* 每当我们将变量分配给某个其他变量或从变量读取数据时,Rust 会默认移动变量指向的值。 所有权规则可以防止你通过多个访问点来修改值,这可能导致访问已被释放的变量. 即使在单线程上下文中,使用允许多个值的可变别名的语言也是如此 */ println!("Foo is {:?}", foo); // value borrowed here after move println!("Bar is {:?}", bar); }

每当我们将变量分配给某个其他变量或从变量读取数据时,Rust 会默认移动变量指向的值。所有权规则可以防止你通过多个访问点来修改值,这可能导致访问已被释放的变量,即使在单线程上下文中,使用允许多个值的可变别名的语言也是如此

作用域:所有权考虑因素

为了分析某个值何时超出作用域,所有权规则还会考虑变量的作用域

- 在 Rust 的背景下, 所有权与作用域协同工作。

- 因此,作用域只不过是变量和值存在的环境。你声明的每个变量都与作用域有关。

- 代码中的作用域是由一对花括号表示的。无论何时使用块表达式都会创建一个作用域,即任何以花括号开头和结尾的表达式。

- 此外,作用域支持互相嵌套,并且可以在子作用域中访问父作用域的元素,但反过来不行

多作用域的情况分析

// scopes.rs /* 由于函数可以创建新的作用域, 因此 main 函数引入了根级别作用域 0, 在代码中定义为 level_0_str */ fn main() { let level_0_str = String::from("foo"); /* 在 0 级作用域中, 创建了一个新的作用域,即作用域 1, 并且带有一个花括号,其中包含变量level_1_number。 */ { let level_1_number = 9; /* 在 1 级作用域中, 创建了一个块表达式, 它成为 2 级作用域。 在其中, 声明了另一个变量 level_2_vector, 以便可以将 level_1_number 添加到其中, 而level_1_number 来自其父级作用域 1 */ { let mut level_2_vector = vec![1, 2, 3]; level_2_vector.push(level_1_number); // can access } // level_2_vector goes out of scope here level_2_vector.push(4); // no longer exists } // level_1_number goes out of scope here } // level_0_str goes out of scope here

作用域是推断所有权时的一个重要属性

作用域还会被用来推断后续介绍的借用和生命周期。

- 当作用域结束时,拥有值的任何变量都会运行相关代码以取消分配该值,并且其自身在作用域之外是无效的。

- 特别是对在堆上分配的值,drop 方法会被放在作用域结束标记}之前调用。

- 这类似于在 C 语言中调用 free 函数,但这里是隐式的, 并且可以避免程序员忘记释放值。

- drop 方法来自 Drop 特征,它是为 Rust 中大部分堆分配类型实现的,可以轻松地自动释放资源。

引入移动和复制语义

结合作用域判断一下下列代码是否正确

// ownership_primitives.rs fn main() { let foo = 4623; /* 4623 的所有权不会从 foo 转移到 bar,但 bar 会获得4623 的单独副本。 看起来基元类型在 Rust 中会被特殊对待,它们会被移动而不是复制。 这意味着根据我们在 Rust 中使用的类型,存在不同的所有权语义,这将引入移动和复制语义的概念 */ let bar = foo; println!("{:?} {:?}", foo, bar); }

语义是什么意思

以移动语义为例,在 Rust 中,变量绑定默认具有移动语义。但这究竟意味着什么?要理解这一点,我们需要考虑如何在程序中使用变量。我们创建值或资源并将它们分配给变量,以便在程序中可以方便地引用它们。这些变量是指向值所在内存地址的名称。现在,诸如读取、赋值、添加及将它们传递给函数等对变量的操作,在访问变量指向值的方式上可能具有不同的语义或含义。在静态类型语言中,这些语义大致分为移动语义和复制语义。

移动语义:变量访问或重新分配时默认

通过变量访问或重新分配给变量时移动到接收项的值表示移动语义。

由于Rust 的仿射类型系统,它默认会采用移动语义。仿射类型系统的一个突出特点是值或资源只能使用一次,而 Rust 通过所有权规则展示此属性。

复制语义

默认情况下,通过变量分配或访问,以及从函数返回时复制的值(例如按位复制)具有复制语义。这意味着该值可以使用任意次数,每个值都是全新的。

使用Copy特征更改语义

Rust 中的移动语义有时会受到限制。幸运的是,通过实现 Copy 特征可以更改类型的行为以遵循复制语义。基元和其他仅适用于堆栈的数据类型在默认情况下实现了上述特征,这也是前面的基元代码能够正常工作的原因

// making_copy_types.rs #[derive(Copy, Debug)] // the trait `Clone` is not implemented for `Dummy` struct Dummy; fn main() { let a = Dummy; let b = a; println!("{:?}", a); println!("{:?}", b); }

Copy 特征依赖于Clone 特征

Clone 是 Copy 的父级特征, 任何实现 Copy 特征的类型必须实现 Clone。

// making_copy_types.rs // 可以在派生注释中的 Copy 旁边添加 Clone 特征来让该示例通过编译 #[derive(Copy, Clone, Debug)] struct Dummy; fn main() { let a = Dummy; let b = a; println!("{:?}", a); println!("{:?}", b); }

区别一下Copy与Clone trait

Copy 和 Clone 特征传达了在代码中使用类型时如何进行复制的原理。

|特征|复制方式|复制内容|使用场景| |::----|:--:--------|:--:--------|:--:--------| |Copy|隐式,自动化特征|堆栈|可以在堆栈上单独表示的小型值| |Clone|显式调用clone|堆+栈|在堆上还包含一个值作为其表示的一部分|

Copy

- Copy 特征通常用于可以在堆栈上完全表示的类型, 也就是说它们自身没有任何部分位于堆上。

- 如果出现了这种情况,那么 Copy 将是开销很大的操作,因为它必须从堆中复制值。这直接影响到赋值运算符的工作方式。

- 如果类型实现了 Copy,则从一个变量到另一个变量的赋值操作将隐式复制数据。

Clone

Clone 特征用于显式复制, 并附带 clone 方法, 类型可以实现该方法以获取自身的副本

Clone 有一个名为 clone 的方法,用于获取接收者的不可变引用,即&self,并返回相同类型的新值。用户自定义类型或任何需要提供能够复制自身的包装器类型,应通过实现clone 方法来实现 Clone 特征

一个通过 Clone 特征复制类型的示例

// explicit_copy.rs // 在 derive 属性中添加了一个 Clone 特征。 #[derive(Clone, Debug)] struct Dummy { items: u32, } fn main() { let a = Dummy { items: 54 }; // 有了Clone, 我们就可以在 a 上调用 clone 方法来获得它的新副本 let b = a.clone(); println!("a: {:?}, b: {:?}", a, b); }

Copy与Clone的使用原则

何时在类型上实现 Copy

可以在堆栈上单独表示的小型值如下所示。

- 如果类型仅依赖于在其上实现了 Copy 特征的其他类型, 则 Copy 特征是为其隐式实现的。

- Copy 特征隐式影响赋值运算符的工作方式。 使用 Copy 特征构建自定义外部可见类型需要考虑它是否会对赋值运算符产生影响。 如果在开发的早期阶段, 你的类型是Copy,后续将它移除之后则会影响使用该类型进行赋值的所有环节。你可以通过这种方式轻松地破坏 API。

何时在类型上实现 Clone。

- Clone 特征只是声明一个 clone 方法,需要被显式调用。

- 如果你的类型在堆上还包含一个值作为其表示的一部分, 那么可选择实现 Clone 特征,这也需要向复制堆数据的用户明确表示。

- 如果要实现智能指针类型(例如引用计数类型) ,那么应该在类型上实现 Clone 特征,以便仅复制堆栈上的指针。

所有权使用场景

重要的是我们能够识别它和编译器给出的错误提示信息

let绑定示例

将参数传递给函数

如果将参数传递给函数,那么相同的所有权规则也同样有效

// ownership_functions.rs fn take_the_n(n: u8) {} fn take_the_s(s: String) {} fn main() { let n = 5; let s = String::from("string"); // take_the_n 函数能够正常工作,是因为 u8(基元类型)实现了 Copy 特征 take_the_n(n); /* String 并没有实现 Copy 特征,因此值的所有权在 take_the_s 函数中会发生移动。 当函数返回时,相关值的作用域也随之结束,并且会在 s 上调用 drop 方法, 这会释放 s 所使用的堆内存。 因此,在函数调用结束后 s 将失效 使用clone即可通过编译:take_the_s(s.clone()) */ take_the_s(s); println!("n is {}", n); println!("s is {}", s); }

如果我们只需要变量 s 的读取访问权限,那么可以让该代码正常工作的另一种方法是将字符串 s 传递回 main 函数

// ownership_functions_back.rs fn take_the_n(n: u8) {} // 添加了一个返回类型 fn take_the_s(s: String) -> String { println!("inside function: {}", s); // 并将传递的字符串返回给调用者 s } fn main() { let n = 5; let s = String::from("string"); take_the_n(n); let s = take_the_s(s); println!("n is {}", n); println!("s is {}", s); }

match表达式

在 match 表达式中,移动类型默认也会被移动

// ownership_match.rs #[derive(Debug)] enum Food { Cake, Pizza, Salad, } #[derive(Debug)] struct Bag { food: Food, } fn main() { let bag = Bag { food: Food::Cake }; match bag.food { Food::Cake => println!("I got cake"), a => println!("I got {:?}", a) // value partially moved here } println!("{:?}", bag); // value borrowed here after partial move }

impl代码块

impl 代码块中,任何以 self 作为第一个参数的方法都将获取调用该方法的值的所有权。这意味着对值调用方法后,你无法再次使用该值

// ownership_methods.rs struct Item(u32); impl Item { fn new() -> Self { Item(1024) } /* 以 self 作为第 1 个参数的实例方法。 在调用之后, 它将在方法内移动, 并在函数作用域结束时被释放。 后续我们将不能再使用它 */ fn take_item(self) { // does nothing } } fn main() { let it = Item::new(); // move occurs because `it` has type `Item`, which does not implement the `Copy` trait it.take_item(); // `it` moved due to this method call println!("{}", it.0); // value borrowed here after move }

闭包

闭包接收不同的值取决于在其内部使用变量的方式

// ownership_closures.rs #[derive(Debug)] struct Foo; fn main() { let a = Foo; /* Foo 的所有权在闭包中已经默认移动到了 b, 用户将无法再次访问 a。 */ // let closure = move || { let closure = || { let b = a; }; println!("{:?}", a); }

借用: 通过引用规避所有权规则限制

为何需要借用/引用

Rust的所有权规则非常严格, 因为它只允许我们使用类型一次。 如果函数只需要对值的读取访问权限,那么我们需要再次从函数返回值,或者在它传递给函数之前复制它。如果类型没有实现 Clone 特征,那么后者可能无法实现其目的。 复制类型看起来似乎很容易绕过所有权规则,但是由于 Clone 总是复制类型,可能会调用内存分配器 API,这是一种涉及系统调用,并且开销高昂的操作,因此它无法满足零成本抽象承诺的所有要点。 随着移动语义和所有权规则的实施,在 Rust 中编写程序很快就会变得困难重重。幸运的是,我们引入了借用和引用类型的概念,它们放宽了规则所施加的限制,但仍然能够在编译期确保兼容所有权规则。

借用的概念是规避所有权规则的限制。进行借用时,你不会获取值的所有权,而是根据需要提供数据。这是通过借用值,即获取值的引用来实现的。为了借用值,我们需要将运算符&放在变量之前,&表示指向变量的地址。

借用 or 引用?

两种借用方式

不可变借用:&

当我们在类型之前使用运算符&时,就会创建一个不可变借用。

// ownership_basics.rs #[derive(Debug)] struct Foo; fn main() { let foo = Foo; /* 注意变量 foo 之前的&。我们借用 foo 并将借用结果分配给 bar。 bar 的类型为&Foo, 这是一种引用类型。 作为一个不可变借用,我们不能通过 bar 改变 Foo 中的值 */ let bar = &foo; println!("Foo is {:?}", foo); println!("Bar is {:?}", bar); }

可变借用:&mut

可以使用&mut 运算符对某个值进行可变借用。 通过可变借用, 你可以改变该值。

// mutable_borrow.rs fn main() { // 可变借用需要可变变量,所以这里会报错,可以加上mut let a = String::from("Owned string"); /* 用&mut a 创建了一个该值的可变借用。 这并没有将 a 移动到 b 只是可变地对它借用。 */ let a_ref = &mut a; a_ref.push('!'); }

可变借用可以改变值,但是不能销毁该值,因为它不是所有者。 如果a 在借用它的代码行之前被销毁,则借用失效

{{#check 检查是否更新 | 借用失效情况并不存在}}

// exclusive_borrow.rs fn main() { let mut a = String::from("Owned string"); let a_ref = &mut a; a_ref.push('!'); println!("{}", a); }

四种借用情况

指针引用

access to non-owned memory

references guard referents

raw pointers

借用规则

通过引用来维护单一的所有权语义。这些规则如下所示

- 一个引用的生命周期可能不会超过其被引用的时间。 这是显而易见的, 因为如果它的生命周期超过其被借用的时间,那么它将指向一个垃圾值(被销毁的值) 。

- 如果存在一个值的可变借用,那么不允许其他引用(可变借用或不可变借用)在该作用域下指向相同的值。可变借用是一种独占性借用。

- 如果不存在指向某些东西的可变借用, 那么在该作用域下允许出现对同一值的任意数量的不可变借用

如果违反借用规则

函数中的借用

// borrowing_functions.rs // 接收可变借用作为参数 fn take_the_n(n: &mut u8) { *n += 2; } fn take_the_s(s: &mut String) { s.push_str("ing"); } fn main() { // 变量绑定必须是可变 let mut n = 5; let mut s = String::from("Borrow"); // 因为函数内做了修改,所以调用时也需要使用可变借用 take_the_n(&mut n); take_the_s(&mut s); println!("n changed to {}", n); println!("s changed to {}", s); }

匹配中的借用

// ownership_match.rs #[derive(Debug)] enum Food { Cake, Pizza, Salad } #[derive(Debug)] struct Bag { food: Food } fn main() { let bag = Bag { food: Food::Cake }; match bag.food { Food::Cake => println!("I got cake"), // 以 ref 作为前缀。 // 关键字 ref 可以通过引用来匹配元素,而不是根据值来捕获它们。 ref a => println!("I got {:?}", a) } println!("{:?}", bag); }

从函数返回引用:

// return_func_ref.rs fn get_a_borrowed_value() -> &u8 { // expected named lifetime parameter let x = 1; &x } fn main() { let value = get_a_borrowed_value(); }

基于借用规则的方法类型

借用规则还规定了如何定义类型的固有方法和特征的实例方法。以下是它们接收实例的方式,并且是根据限制由少到多排列的。

- &self 方法:这些方法只对其成员具有不可变的访问权限。

- &mut self 方法:这些方法能够可变地借用 self 实例。

- self 方法:这些方法拥有调用它的实例的所有权,并且类型在后续调用时将失效。

对于自定义类型,相同的借用规则也适用于其作用域成员。

生命周期:针对引用附加的信息

从变量生命周期开始

生命周期限定

生命周期注解

生命周期省略(Lifetime Elision)

销毁(Destructors)

智能指针

所有权共享

参考资源

online-book

- What is Ownership? - The Rust Programming Language

- 生命周期省略规则(Lifetime elision) - The Rust Reference

- Destructors - The Rust Reference

- Lifetime elision - The Rust Reference

- Understanding Ownership - The Rust Programming Language

fragment

local

类型系统起源

我们为什么需要在语言中使用类型?

这是一个很好的问题,可以作为理解编程语言类型系统的契机。

1. 从二进制数据格式到汇编

作为程序员,我们知道为计算机编写的程序在最底层是以 0 和 1 组成的二进制数据格式表示的。实际上,最早的计算机必须使用机器代码手动编程。最终,程序员意识到这样做非常容易出错,并且乏味、耗时。对大部分人来说,在二进制层面操作和推断这些实体是不切实际的。 到了 20 世纪 50 年代, 编程社区提出了机器代码助记符的概念, 这些助记符变成了今天我们熟知的汇编语言。

2. 从汇编到编程语言,类型系统应运而生

然后,编程语言应运而生,它们被编译成汇编代码,并允许编程人员编写人类可理解的代码,以方便计算机将其编译成机器代码。然而,大家平时所说的语言表达某些语义比较模糊,因此需要制定一套规则和条件,来表述用类似人类语言编写的计算机程序中可能或不可能存在的内容,即程序语义。这使得我们提出了类型和类型系统的理念。

3. 再来认真看看类型系统

类型是一组具名的可能值。例如,u8 是一种可能包含 0~255 的正数值类型。类型提供了一种方法来弥合我们创建的这些实体的底层表示与心理模型之间的差距。除此之外, 类型还为我们提供了表示实体的意图、行为和约束的方法:

它们定义了用户通过类型能够(不能够) 做什么。 例如, 它没有定义将字符串类型的值和数值类型的值相加的结果是什么。

4. 类型系统其实是一组规则

从类型来看,语言设计者构建了类型系统,这些系统是一组规则,用于管理不同类型在编程语言中的交互。它们可以用作推断程序的工具,并有助于确保程序能够正常运行并符合规范。类型系统根据其表达力进行限定,这仅表示你可以使用类型表达逻辑的程度,以及程序中的不变量。

例如 Haskell 是一种高级语言,它具有非常丰富的表现力的类型系统,而C 语言是一种低级语言,它只为我们提供了很少的基于类型的抽象。Rust 试图在这两个极端之间找到一种平衡。

5. 类型系统是对内存管理/安全的抽象

动态类型大小

类型布局

内部可变性

子类型与协变

强制转换(type coercions)

参考资料

online-book

- Dynamically Sized Types - The Rust Reference

- Type layout - The Rust Reference

- Interior mutability - The Rust Reference

- Subtyping and Variance - The Rust Reference

- Type coercions - The Rust Reference

fragment

local

基础内置类型

基元类型

序列类型

自定义类型

函数类型

指针类型

特征类型

参考资源

online-book

fragment

local

集合类型

参考资源

online-book

fragment

local

自定义类型

参考资源

online-book

fragment

local

泛型、特征及特征对象

- 泛型、特征及特征对象

泛型

从代码复用出发

函数作用不足

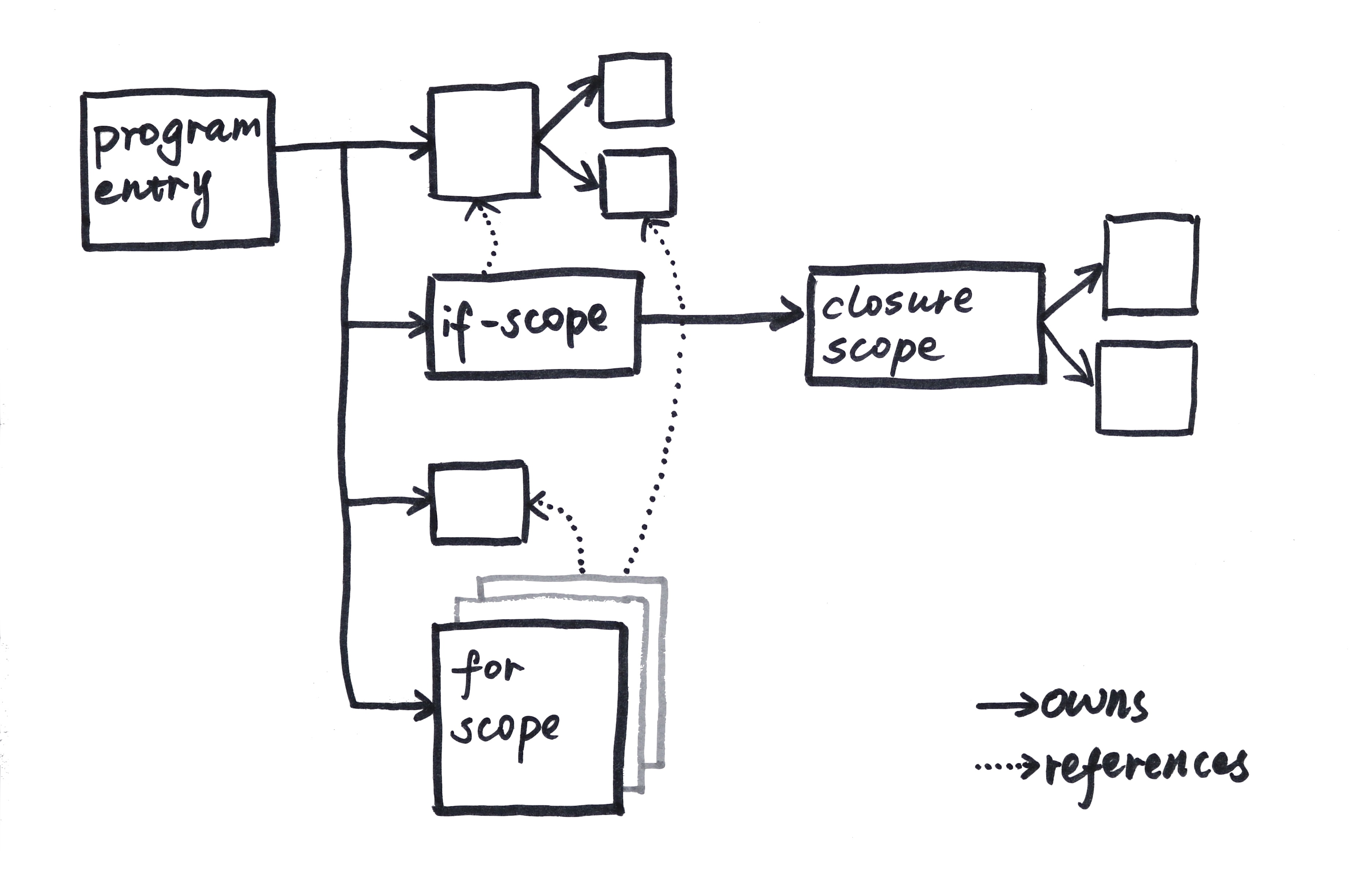

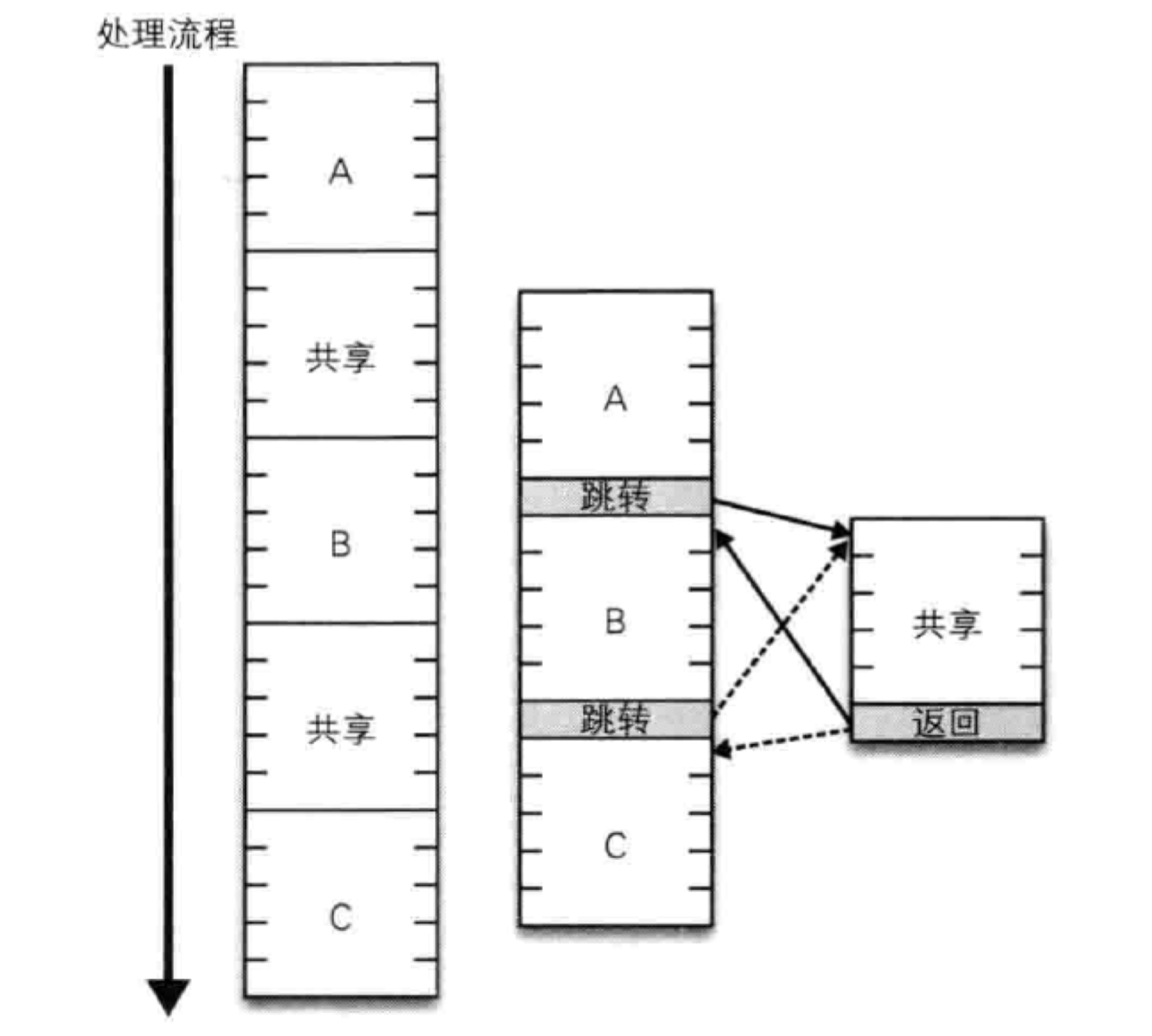

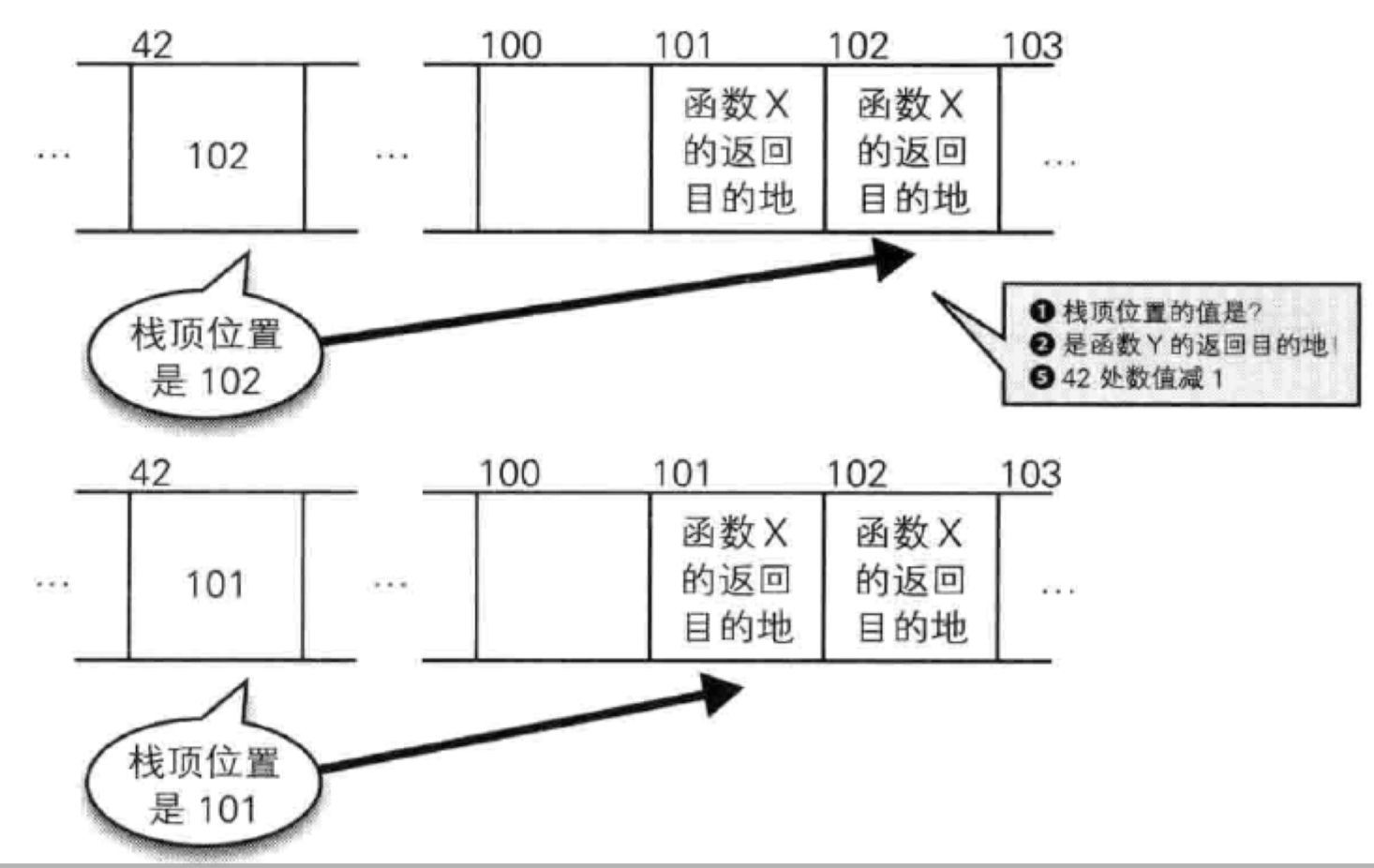

一直以来,函数的实现方式就是基于c语言的goto指令:

通过进一步强化,就得到函数的实现方式:

但是也就这样了,函数只能实现流程上的复用,不能实现类型上的复用。这一点其实在python、js这些动态类型语言上面就不存在这个问题。对于Rust这种静态类型语言,对函数入参类型要求十分严格,于是泛型就应运而生。

静态类型语言还需要泛型来复用代码

泛型编程是一种仅适用于静态类型编程语言的技术。它首次出现在 ML 语言中,是一种静态类型的函数式语言。

像 Python 这样的动态语言采用的是简单类型 (duck typing) , 其中的 API 是根据它们可以做什么,而不是它们是什么来处理参数的,因此不依赖于泛型。

泛型是语言设计特性的一部分, 可以实现代码复用, 并遵循不重复自己的原则 (Don’t Repeat Yourself,DRY) 。采用这种技术,你可以使用类型占位符来编写算法、函数、方法及类型, 并在这些类型上指定一个类型变量( 使用单个字母,通常是 T、K 或 V) ,告知编译器在任何代码中实例化它们时要填充的实际类型。这些类型被称为泛型或元素。单个字母(例如类型 T)被称为泛型参数。当你使用或实例化任何泛型元素时,它们会被替换成诸如 u32 这样的具体类型。

泛型本质上是一种单态化

每次将泛型元素与具体类型一起使用时,都会在编译时用类型变量 T 生成该代码的特定副本,并将其替换为具体类型。这种在编译时生成包含具体类型的专用函数的过程被称为单态化,这是执行与多态函数相反的过程。

泛型使用方式

在使用泛型时,应该多去考虑它与不同元素结合使用的场景背后的思维方式。泛型可以与结构体、枚举、函数、特征、方法及代码实现块。它们的一个共同特征是泛型的参数是由一对尖头括号分隔,并包含于其中。

泛型函数

为了创建泛型函数,我们需要将泛型参数放在函数名之后和圆括号之前,如下所示:

// generic_function.rs fn give_me<T>(value: T) { let _ = value; } fn main() { let a = "generics"; let b = 1024; give_me(a); give_me(b); }

泛型结构体

// generic_struct.rs struct Container<T> { item: T, } impl<T> Container<T> { fn new(item: T) -> Self { Container { item } } } impl Container<u32> { fn sum(item: u32) -> Self { Container { item } } } fn main() { // todo }

泛型枚举体

// generic_enum.rs enum Transmission<T> { Signal(T), NoSignal, } fn main() { // stuff }

泛型特征

泛型方法

impl: 泛型实现块

泛型实现

当为任何泛型编写 impl 代码块时,都需要在使用它之前声明泛型参数。T 就像一个变量—— 一个类型变量,我们需要先声明它 impl代码块实际上意味着我们正在为所有类型 T 实现这些方法,它们会出现在 Container

中。这个 impl 代码块是一个泛型实现。 因此,生成的每个具体 Container 都将有这些方法。

// generic_struct_impl.rs struct Container<T> { item: T, } impl<T> Container<T> { fn new(item: T) -> Self { Container { item } } } fn main() { // stuff }

专门化泛型

在这里, 由于 u32 是作为具体类型存在的, 因此我们不需要 impl 之后的

, 这是 impl 代码块的另外一个特性,它允许你通过独立实现方法来专门化泛型。 现在,我们也可以通过将 T 替换为任何具体类型来为 Container 编写更具体的 impl 代码块。以下就是它的实例:

impl Container<u32> { fn sum(item: u32) -> Self { Container { item } } }

指定类型进行实例化

每当我们进行实例化时, 编译器需要在其类型签名中知道 T 的具体类型以便替换,这为其提供了将泛型代码单态化的类型信息。 而具体类型的确定主要有三种方式:

- 大多数情况下,具体类型是基于类型的实例化推断.

- 对泛型函数调用某些方法来接收具体类型。

- 在极个别情况下, 我们需要通过使用

turbofish (::<>)运算符输入具体类型来替代泛型以便辅助编译器识别。

基于类型实例化推断

这是最常见的方式,主要基于类型特征(trait)。

泛型函数调用某些方法

// using_generic_func.rs use std::str; fn main() { let num_from_str = str::parse::<u8>("34").unwrap(); println!("Parsed number {}", num_from_str); }

turbofish: ::<>

- 如果没有任何类型特征,代码将无法编译:👇

fn main() { let a = Vec::new(); }

- 这时可以用下列三种方式指定

// using_generic_vec.rs fn main() { // providing a type let v1: Vec<u8> = Vec::new(); // or calling method let mut v2 = Vec::new(); v2.push(2); // v2 is now Vec<i32> // or using turbofish let v3 = Vec::<u8>::new(); // not so readable }

特征

从多态和代码复用的角度来看: 接口、鸭子类型还是特征?

从多态和代码复用的角度来看, 在代码中将类型的共享行为和公共属性与其自身隔离通常是一个好主意,并且能拥有专属于自己的方法。在这样做时,我们允许不同类型通过通用属性互相关联,使我们能够为 API 编程,使其参数更通用或更具包容性。

这意味着我们可以接收具有这些通用属性的类型,而不仅限于某种特定类型。

接口

类似 Java 和 C#的面向对象编程语言中,接口表达了相同的理念,我们可以在其中定义多种类型能够实现的共享行为。例如,我们可以使用单个 sort 函数接收实现 Comparable 或者 Comparator 接口的元素列表,而不是使用多个 sort 函数接收整数值列表,以及用其他函数接收字符串值列表。这使得我们可以将任何可比较(Comparable)的内容传递给 sort 函数。

鸭子类型

而Python同样有明确的特性,被称为“鸭子类型“.

“当看到一只鸟走起来像鸭子、游泳起来像鸭子、叫起来也像鸭子,那么这只鸟就可以被称为鸭子。”

在鸭子类型中,关注点在于对象的行为,能做什么;而不是关注对象所属的类型。例如,在不使用鸭子类型的语言中,我们可以编写一个函数,它接受一个类型为“鸭子”的对象,并调用它的“走”和“叫”方法。在使用鸭子类型的语言中,这样的一个函数可以接受一个任意类型的对象,并调用它的“走”和“叫”方法。如果这些需要被调用的方法不存在,那么将引发一个运行时错误。任何拥有这样的正确的“走”和“叫”方法的对象都可被函数接受的这种行为引出了以上表述,这种决定类型的方式因此得名。

鸭子类型通常得益于“不”测试方法和函数中参数的类型,而是依赖文档、清晰的代码和测试来确保正确使用。

在常规类型中,我们能否在一个特定场景中使用某个对象取决于这个对象的类型,而在鸭子类型中,则取决于这个对象是否具有某种属性或者方法——即只要具备特定的属性或方法,能通过鸭子测试,就可以使用。

特征

Rust也有一个类似且功能强大的结构,被称为特征。Rust中的特征以多种形式存在, 我们将介绍一些最常见的形式并了解一些与它们简单交互的方式。此外,当特征与泛型搭配使用时,可以限制传递到 API 的参数范围。我们将会对特征进行比较深入的了解。

特征到底是什么?

特征的多种表现形式

标记(特征)

简单(特征)

泛型(特征)

关联类型(特征)

继承(特征)

一些常用内置特征

自动特征(Auto Traits)

Send & Sync

Unpin、 UnwindSafe & RefUnwindSafe

Debug

这个特征有助于在控制台上输出类型以便进行调试。在组合类型的情况下,类型将以类似 JSON 的格式输出,其中带有花括号和其他括号,如果类型是字符串,将会用引号标识。这适用于 Rust 中的大多数内置类型。

PartialEq 和 Eq

这些特征允许两个元素相互比较以验证是否相等

Copy和Clone

这些特征定义了类型的复制方式。 简而言之,当在任何自定义类型上自动派生时,这些特征允许用户从实例创建新的副本:

- 可以在实现 Copy 时隐式创建

- 也可以在实现 Clone 时通过调用 clone() 显式创建。

请注意,Copy 依赖于在类型上实现的 Clone 特征

Display

Add

Into 和 From

Drop

Deref & DerefMut

SizedSpecial types and traits - The Rust Reference

一个完整例子

// complex/src/lib.rs use std::ops::Add; /* 将#[derive(Default)] 属性实现为一个过程宏,可以自动实现它修饰的类型的特征。 此自动派生要求任何自定义类型的字段(例如结构体或枚举)本身必须实现 Default 特征。 使用它们继承特征仅适用于结构体、枚举及联合。 */ #[derive(Default, Debug, PartialEq, Copy, Clone)] struct Complex<T> { // Real part re: T, // Complex part im: T, } impl<T> Complex<T> { // new 函数实际上并不是一个特殊的构造函数(如果你只了解带有构造函数的语言), // 而是社区采用的一个常用名称(作为创建新类型实例的方法名) 。 fn new(re: T, im: T) -> Self { Complex { re, im } } } // 来自 std::ops 模块的 Add 特征允许我们使用“+”运算符将两个复数相加 /* 1. impl<T: Add<T, Output=T>表示我们正在为泛型 T 实现 Add,其中 T 实现 Add<T, Output=T>。 2. <T, Output=T>部分表示 Add 特征的实现必须具有相同的输入和输出类型 3. Add for Complex<T>部分表示为 Complex<T>类型实现 Add 特征 4. T:Add 表示必须实现 Add 特征。如果没有实现,那么我们不能使用“+”运算符 */ impl<T: Add<T, Output=T>> Add for Complex<T> { type Output = Complex<T>; // Add 特征提供的核心功能,是我们在两种实现类型之间使用“+”运算符时调用的方法。 // 它是一个实例方法,通过值获取 self 并接收 rhs 作为参数,即特征定义中的 RHS。 fn add(self, rhs: Complex<T>) -> Self::Output { Complex { re: self.re + rhs.re, im: self.im + rhs.im } } } // 来自 std::convert 模块的 Into 和 From 特征使用户能够根据其他类型创建复数类型 /* 1. 如果我们可以从内置基元类型 (例如双元素元组) 构造 Complex 类型 其中第 1 个元素是实部,第 2 个元素是虚部,将会很方便。 我们可以通过实现 From 特征来达到此目的。 2. 此特征定义了一个 from 方法, 为我们提供了在类型之间进行转换的一般方法 3. 第一个<T>是泛型 T 的声明, 第二个和第三个<T>是泛型类型 T 的用途。 我们会根据(T,T) 类型创建它 */ impl<T> From<(T, T)> for Complex<T> { /* 当我们实现它时, 只需要用我们希望实现它的类型替换 T 并实现 from 方法, 然后我们就可以在相关类型上调用该方法。 这是一个将 Complex 值转换为双元素元组类型的实现, Rust本身就能识别它 */ fn from(value: (T, T)) -> Complex<T> { Complex { re: value.0, im: value.1 } } } use std::fmt::{Formatter, Display, Result}; // Display 特征能够输出人类可读版本的复数类型 impl<T: Display> Display for Complex<T> { fn fmt(&self, f: &mut Formatter) -> Result { // 为了让用户能够以数学符号的形式查看复数类型 write!(f, "{} + {}i", self.re, self.im) } } // 一个简单的初始化测试用例。 #[cfg(test)] mod tests { use crate::Complex; #[test] fn complex_basics() { let first = Complex::new(3, 5); let second: Complex<i32> = Complex::default(); assert_eq!(first.re, 3); assert_eq!(first.im, 5); assert!(second.re == second.im); } #[test] fn complex_addition() { let a = Complex::new(1, -2); let b = Complex::default(); let res = a + b; assert_eq!(res, a); } #[test] fn complex_from() { let a = (2345, 456); let complex = Complex::from(a); assert_eq!(complex.re, 2345); assert_eq!(complex.im, 456); } #[test] fn complex_display() { let my_imaginary = Complex::new(2345, 456); println!("{}", my_imaginary); } } // 最后使用cargo test -- --nocapture执行

特征区间:泛型+特征

引出特征区间

首先看一下如下代码:

// trait_bounds_intro.rs struct Game; struct Enemy; struct Hero; /* 在 Game 类型上我们有一个泛型函数 load,它可以接收任何游戏实体, 并通过任意 T 调用 init()将其加载到我们的游戏世界中。 但是,这个示例无法通过编译 */ impl Game { fn load<T>(&self, entity: T) { entity.init(); // method not found in `T` } } fn main() { let game = Game; game.load(Enemy); game.load(Hero); }

- 因此, 任何类型为 T 的泛型函数都不能知道或默认假定 init()方法存在于 T 之上。

- 如果确实如此,那么它根本不是泛型,并且它们只能接收具有 init()方法的类型。

- 因此,有一种方法可以让编译器知道这一点,并约束 load 通过特征能够接收的类型集,这就需要用到特征区间。

我们可以定义一个名为 Loadable 的特征,并在我们的 Enemy 和 Hero 类型上实现它。

// trait_bounds_intro.rs struct Game; struct Enemy; struct Hero; trait Loadable { fn init(&self); } /* 我们分别为 Enemy 和 Hero 实现了 Loadable,还修改了 load 方法 */ impl Loadable for Enemy { fn init(&self) { println!("Enemy loaded"); } } impl Loadable for Hero { fn init(&self) { println!("Hero loaded"); } } impl Game { /* 我们必须在泛型声明旁边放置几个符号来指定特征,我们称之为特征区间 */ fn load<T: Loadable>(&self, entity: T) { entity.init(); } } fn main() { let game = Game; game.load(Enemy); game.load(Hero); }

- 注意, “:Loadable”部分表明了我们指定特征范围的方式。特征区间允许我们限制泛型 API 可以接收的参数范围。

代码单体化

- 指定泛型元素上的绑定的特征类似于我们为变量指定类型的方式

- 但是此处的变量是泛型 T,类型是某些特征。例如 T:SomeTrait。

- 定义泛型函数时几乎总是会用到特征区间。

- 如果定义的泛型函数中的 T 不包含任何特征区间,我们就不能通过任何方法调用,因 Rust 不知道给定方法实现的方式。

- 它需要知道 T 是否具有某个 foo 方法,以便将代码单体化

// trait_bounds_basics.rs // 我们有一个方法 add_thing,它可以添加任何类型 T。 fn add_thing<T>(fst: T, snd: T) { // 编译器向用户建议在 T 上添加特征区间 Add // help: consider restricting type parameter `T` let _ = fst + snd; } fn main() { add_thing(2, 2); }

修正后

// trait_bound_basics_fixed.rs use std::ops::Add; // 代码修改之后,我们将“:Add”添加到了 T 的后面,之后代码通过了编译 fn add_thing<T: Add>(fst: T, snd: T) { let _ = fst + snd; } fn main() { add_thing(2, 2); }

指定特征区间的四个方法

区间内泛型: fn fn_name<T: target_trait>(val: T)

#![allow(unused)] fn main() { // 指定特征区间的一种方法, 它会接收任何实现了 Display 特征的类型 fn show_me<T: Display>(val: T) { //可以使用{}格式化字符串,因为有Display特征区间 printin!("{}", val); } }

- 这是在泛型函数的类型签名的长度较短时声明特征区间的常见语法。

- 在指定类型的特征区间时,此语法也有效

where语句: 当第一种方法签名过长时使用

#![allow(unused)] fn main() { pub fn parse<F>(&self) -> Result<F, <F as FromStr>::Err> where F: FromStr { ... } }

注意“where F: FromStr”部分告诉我们 F 类型必须实现 FromStr 特征。where 语句将特征区间和函数签名解耦,并使其可读

使用“+“组合多个特征

- 先看一下标准库中 HashMap 类型的 impl 代码块:

#![allow(unused)] fn main() { // HashMap 键类型的 K 必须实现 Hash 特征和 Eq 特征 impl<K: Hash + Eq, V> HashMap<K, V, RandomState> {} }

- 一个更加具体的例子

// traits_composition.rs trait Eat { fn eat(&self) { println!("eat"); } } trait Code { fn code(&self) { println!("code"); } } trait Sleep { fn sleep(&self) { println!("sleep"); } } // 创建了一个新的特征 Programmer,它由 3 个特征组合而成:Eat、Code、 Sleep。 // 通过这种方式, 我们对类型设置了约束: // 因此如果类型 T 实现了 Programmer, 那么它必须实现上述所有特征 trait Programmer: Eat + Code + Sleep { fn animate(&self) { self.eat(); self.code(); self.sleep(); println!("repeat!"); } } struct Bob; impl Programmer for Bob {} impl Eat for Bob {} impl Code for Bob {} impl Sleep for Bob {} fn main() { Bob.animate(); }

使用impl特征语法: 闭包常用

// impl_trait_syntax.rs use std::fmt::Display; /* 直接使用了 impl Display,而不是指定 T:Display。这是 impl 特征语法。 这为我们返回复杂或不方便表示的类型(例如函数的闭包)提供了便利 */ fn show_me(val: impl Display) { println!("{}", val); } fn main() { show_me("Trait bounds are awesome"); }

如果没有这种语法,则必须使用 Box 智能指针类型将其放在指针后面返回,这涉及堆分配。 闭包的底层结构由实现了一系列特征的结构体组成。Fn(T) -> U 特征就是其中之一

闭包使用示例:

// impl_trait_closure.rs // 它接收两个数字,并返回将这两个数字相加的闭包 fn lazy_adder(a: u32, b: u32) -> impl Fn() -> u32 { move || a + b } fn main() { // 调用 lazy_adder,传入两个数字。 // 这会在 lazy_adder 中创建一个闭包,但不会对其进行求值 let add_later = lazy_adder(1024, 2048); println!("{:?}", add_later()); }

还可以在入参和返回使用:

// impl_trait_both.rs use std::fmt::Display; /* 1. 会接收任何 Display 特征的参数 2. 返回的类型是 impl Display */ fn surround_with_braces(val: impl Display) -> impl Display { format!("{{{}}}", val) } fn main() { println!("{}", surround_with_braces("Hello")); }

- 通常建议将特征区间的 impl 特征语法用做函数的返回类型。

- 在参数位置使用它意味着我们不能使用 turbofish 运算符。

- 如果某些相关代码使用 turbofish 运算符来调用软件包中的某个方法,那么可能导致 API 不兼容。

- 只有当我们没有可用的具体类型时才应该使用它, 就像闭包那样。

特征区间的使用场景

在类型上使用:不建议

// trait_bounds_types.rs use std::fmt::Display; // 写法一:区间内泛型 struct Foo<T: Display> { bar: T, } // 写法二:where语句解耦 struct Bar<F> where F: Display, { inner: F, } fn main() {}

不过,我们并不鼓励在类型上使用特征区间,因为它对类型自身施加了限制。 通常, 我们希望类型尽可能是泛型,从而允许我们使用任何类型创建实例,并使用函数或方法中的特征区间对其行为进行限制。

泛型函数+impl代码块

// trait_bounds_functions.rs use std::fmt::Debug; trait Eatable { fn eat(&self); } // 指定类型必须是 Debug,以便其可以在方法内部输出到控制台 #[derive(Debug)] struct Food<T>(T); #[derive(Debug)] struct Apple; // 为了让 apple 是“可食用”的,我们实现了 Food 的 Eatable 特征 impl<T> Eatable for Food<T> where T: Debug, { fn eat(&self) { println!("Eating {:?}", self); } } // 注意 eat 的特点,类型 T 必须实现 Eatable 特征。 fn eat<T>(val: T) where T: Eatable, { val.eat(); } fn main() { let apple = Food(Apple); eat(apple); }

特征对象: 多态特征类型

分发(dispatch)

分发是一个从面向对象编程范式中借鉴的概念,主要用于描述被称为多态的上下文中的一种特性。 在面向对象程序设计(Object-Oriented Programming,OOP)中,当 API 是泛型或者接收实现为接口的参数时,必须弄清楚参数在传递给 API 的类型实例上调用什么方法实现。多态的上下文中的方法解析过程被称为分发,调用该方法被称为分发化(dispatching) 。

分发方式:静态 or 动态

在支持多态的主流语言中,分发可以通过以下任意一种方式进行。

- 静态分发:编译期决定

当在编译期决定要调用的方法时,它被称为静态分发或早期绑定。方法的签名用于决定调用的方法,所有这些都在编译期决定。在 Rust 中,泛型展示了这种形式的分发, 因为即使泛型函数可以接收许多参数, 也会在编译期使用具体类型生成函数的专用副本。

2.动态分发: 运行期决定,资源开销更大

在面向对象的语言中,有时直到运行时才能确定调用的方法。这是因为具体类型被隐藏,并且只有接口方法可用于调用该类型。 在 Java 中,当函数只有参数时就是这种情况,即接口。 这种情况只能通过动态分发来处理。在动态分发过程中,可通过对 vtable 接口的实现列表进行查找,并调用该方法来动态确定相关方法。vtable 是一个函数指针列表,指向每个类型的实现方法。由于方法调用过程中存在额外的间接指针引用,所以这需要更多的资源开销

区别特征区间与特征对象

|特征使用方式|分发方式|实现方式|绑定时期|| |:----:------------|:--:--------|:--:--------|:--:--------|--| |特征区间|静态分发|限定泛型|编译期(早期绑定)|| |特征对象|动态分发|胖指针|运行期多态(后期绑定)||

特征对象具体说说

指定为实现某个特征

特征对象是一种创建多态 API 的方法,可以将参数指定为实现某个特征的东西,而不是泛型或具体类型。这种方法被声明为实现某个特征 API,即特征对象。

用胖指针实现

特征对象类似 C++中的虚方法。特征对象实现为胖指针,并且是不定长类型,这意味着它们只能在引用符号(&)后面使用。特征对象胖指针具有指向与对象关联的实际数据的第一指针,而第二指针指向虚拟表(vtable) ,它是在固定偏移处为每个对象的方法保留一个函数指针的结构体。

是Rust执行动态分发的方式

特征对象是 Rust 执行动态分发的方式,我们没有实际的具体类型信息。通过跳转到vtable 并调用适当的方法完成方法解析。

特征对象的另一个用例是,它们允许用户对可以具有多种类型的集合进行操作,但是在运行时需要额外的间接指针引用开销

// trait_objects.rs use std::fmt::Debug; #[derive(Debug)] struct Square(f32); #[derive(Debug)] struct Rectangle(f32, f32); trait Area: Debug { fn get_area(&self) -> f32; } impl Area for Square { fn get_area(&self) -> f32 { self.0 * self.0 } } impl Area for Rectangle { fn get_area(&self) -> f32 { self.0 * self.1 } } fn main() { /* shapes 的元素类型是&dyn Area,这是一种表示为特征的类型。 特征对象是由 dyn Area 表示的, 意味着它是指向 Area 特征某些实现的指针。 特征对象形式的类型允许用户在集合类型(例如 Vec)中存储不同类型 Square 和 Rectangle 会隐式转换成特征对象,因为我们给它们推送了一个引用。 我们还可以通过手动转换某个特征对象来构造一个类型,但这是一种比较少见的情况. 只有在编译器自身无法将类型作为特征对象转换时使用。 */ let shapes: Vec<&dyn Area> = vec![&Square(3f32), &Rectangle(4f32, 2f32)]; for s in shapes { println!("{:?}", s); } }

不定长类型只能作为引用创建

请注意,我们只能创建在编译时知道类型尺寸的特征对象。

dyn Trait 是一个不定长类型,只能作为引用创建。我们还可以通过将特征对象置于其他指针类型之后来创建特征对象,例如 Box、Rc、Arc 等

// dyn_trait.rs use std::fmt::Display; fn show_me(item: &dyn Display) { println!("{}", item); } fn main() { show_me(&"Hello trait object"); }

总结特征、特征区间和特征对象

特征和泛型通过单态化(早期绑定)或运行时多态(后期绑定)提供了两种代码复用的方式。 何时使用它们取决于具体情况和相关应用程序的需求:

- 通常,错误类型会被分配到动态分发的序列,因为它们应该是很少被执行的代码路径。

- 单态化对小型的应用场景来说非常方便,但是缺点是导致了代码的膨胀和重复,这会影响缓存效率,并增加二进制文件的大小。

但是,在这两个选项中,静态分发应该是首选,除非系统对二进制文件大小存在严格的限制。

参考资源

online-book

- Advanced Traits - The Rust Programming Language

- Trait and lifetime bounds - The Rust Reference

- Special types and traits - The Rust Reference

- Generic Types, Traits, and Lifetimes - The Rust Programming Language

- Advanced Traits - The Rust Programming Language

fragment

local

编程语言语法概述

前言

其实编程语言的语法本质上就分成三部分:确定使用什么类型、类型可以用的操作、通用逻辑操作。不过语法又不是这么简单,它担负着两方面的作用:

-

与编译器交互:因为这些语法在编译器内部都有对应的操作,涉及一系列繁杂的自动化操作。所以当编写语法可以通过编译,至少说明程序可以跑起来。 这一点在rust中尤其明显,毕竟rust是出了名的“面向编译器”开发语言,编译器对语法的要求可以算作“苛刻”。但是这样也有好处,就是潜移默化之中,编程思维也被调整一番。

-

与编程人员交互:这里主要指编程需要可读且易读。这和代码质量息息相关,这里的编程人员不仅包括第一个写出这段代码的人,还包括后续开发以及协作的开发人员。

参考资源

online-book

fragment

local

语言细节与对比

::与.

UFCS/FQS与turbofish

&*与deref

关联类型、GAT与泛型参数

type vs use

impl vs impl TraitName for

trait与trait object

<>与()

静态分发与动态分发

注释与文档(rustdoc)

注释方法

rustdoc使用

参考资源

online-book

fragment

local

词法关键字扫盲

1. 关键字

严格关键字

#![allow(unused)] fn main() { as / break / const / continue / crate / if / else / struct / enum / true / false / fn / for / in / let / loop / impl / mod / match / move mut / pub / ref / return / self / Self / static / super /trait / type / unsafe /use / where / while / async /await/dyn/main }

弱关键字

#![allow(unused)] fn main() { abstract / become / box / do / final / macro / override / priv / typeof / unsized / virtual / yield / try }

保留字

- 2018 Edition:union,’static

- 2015 Edition:dyn

被保留的关键字不代表将来一定会使用

2. 标识符

3. 注释

//!, /!, //!!, /!!, /…/, //, ////, /…*/

4. 空白: \n、\t、tab

任何形式的空白字符在RuSt中只用于分隔标记,没有语义意义。

5. 词条

- 语言项(item)

- 块(block)

- 语句(Stmt)

- 表达式(Expr)

- 模式(Pattern)

- 关键字(Keyword)

- 标识符(Ident)

- 字面量(Literal)

- 生命周期(Lifetime)

- 可见性(Vis)

- 标点符号(Punctuation)

- 分隔符(delimiter)

- 词条树(Token Tree)

- 属性(Attribute)

路径: ::, ::<>

参考资源

online-book

fragment

local

绑定、赋值与匹配模式

参考资源

online-book

- Patterns - The Rust Reference

- Enums and Pattern Matching - The Rust Programming Language

- Patterns and Matching - The Rust Programming Language

fragment

local

逻辑判断与循环

参考资源

online-book

fragment

local

语句与表达式

参考资源

online-book

fragment

local

代码质量:异常、测试与日志

错误处理

RUST_BACKTRACE的用法

- 1 : 打印简略错误信息

- full: 打印详细错误信息

设置环境变量

export RUST_BACKTRACE=1

echo $RUST_BACKTRACE

临时设置使用

RUST_BACKTRACE=1 cargo run

RUST_BACKTRACE=full mdbook serve

参考资源

online-book

fragment

local

设计抽象

参考资源

online-book

fragment

local

编程范式

参考资源

online-book

fragment

local

函数式编程

参考资源

online-book

- Functional Language Features: Iterators and Closures - The Rust Programming Language

- Advanced Functions and Closures - The Rust Programming Language

fragment

local

面向对象编程

参考资源

online-book

fragment

local

泛型编程

参考资源

online-book

fragment

local

设计模式

参考资源

online-book

fragment

local

项目模块管理及扩展

对于一门编程语言,是否能够成为工程化开发工具的主要标准在于两点:

- 包管理、模块管理

- 扩展工具是否方便加入

这里面包含一些通用的设计抽象,因此专门作为单独的一层。

参考资源

online-book

fragment

local

模块系统相关:Workspace、Package、Crate、Module

- 模块系统相关:Workspace、Package、Crate、Module

- 厘清Workspace、Package、crate和module的关系

- Package: 包含Cargo.toml

- workspace与package

- 具体对比package和crate

- [在Cargo.toml的[bin]/[lib]中指明](#在cargotoml的binlib中指明)

- 再来对比workspace、package和crate

- module

- 整理说一下rust的模块系统

- 联想对比

- module tree

- 模块使用方式

- 参考资源

- 厘清Workspace、Package、crate和module的关系

厘清Workspace、Package、crate和module的关系

Package: 包含Cargo.toml

package就是cargo new的产物,里面包含一个cargo.toml,包名就写在里面的package里。比如substrate的一个包代码:

[package]

name = "sc-allocator"

version = "4.1.0-dev"

authors = ["Parity Technologies <admin@parity.io>"]

edition = "2021"

license = "Apache-2.0"

homepage = "https://substrate.io"

repository = "https://github.com/paritytech/substrate/"

description = "Collection of allocator implementations."

documentation = "https://docs.rs/sc-allocator"

readme = "README.md"

[package.metadata.docs.rs]

targets = ["x86_64-unknown-linux-gnu"]

[dependencies]

log = "0.4.17"

thiserror = "1.0.30"

sp-core = { version = "6.0.0", path = "../../primitives/core" }

sp-wasm-interface = { version = "6.0.0", path = "../../primitives/wasm-interface" }

- package表明该package的基本信息

- dependencies表示该package依赖的其他package

workspace与package

- workspace+members: 并发代表当前package包含的所有subpackage,只是指明一个工作区的所有package

A Cargo.toml file can simultaneously define a package and a workspace to which it belongs, but that package is still a member of that workspace, not the other way around.

具体对比package和crate

在Cargo.toml的[bin]/[lib]中指明

再来对比workspace、package和crate

Generally, a package exposes only one crate. Most library crates don’t even have an associated binary crate(s) in their package. It’s due to this that package/crate terminology is often used interchangeably; for lib crates it is in the 90% case. Package is also a generic term that people not familiar with Rust’s ecosystem can understand, where crate is a Rust-specific piece of jargon.

The two concepts are still meaningfully different – while conventionally package and lib crate have the same name ( modulo hyphens vs underscores), this is not required in any way – but for the most part there isn’t an appreciable difference unless you’re paying attention to the weeds and edge cases.

module

在rust中,module(模块)更多还是一种逻辑上的概念,主要使用mod关键字,下面会具体说说

#![allow(unused)] fn main() { mod say { pub fn hello() { println!("Hello, world!"); } } }

整理说一下rust的模块系统

联想对比

- golang的模块系统

- python/js的模块系统

- mdbook的所有文章只能挂到SUMMARY才能生成链接。

module tree

- module Tree只有一个入口(根),src/main.rs或src/lib.rs

- 默认情况下,lib.rs和main.rs的crate都和cargo.toml里面的[package].name同名

- 但是cargo.toml里面可以给crate重命名:[lib]重命名lib.rs, [binary]重命名main.rs

模块使用方式

目录模块

tree -L 2 ─╯

.

├── foo

│ └── bar.rs

├── foo.rs

└── main.rs

1 directory, 3 files

- foo/bar.rs

pub struct Bar; // 导出给foo.rs使用 impl Bar { pub fn hello() { println!("Hello from Bar !"); } }

- foo.rs

mod bar; // 使用同名目录foo下的文件模块foo/bar.rs pub use self::bar::Bar; // 再次指定导入bar::Bar pub fn do_foo() { println!("Hi from foo!"); }

嵌套导入

// nested_imports.rs // 使用{}嵌套导入 use std::sync::{Arc, Mutex, mpsc::{channel, Sender, Receiver}}; fn consume(_tx: Sender<()>, _rx: Receiver<()>) { } fn main() { let _ = Arc::new(Mutex::new(40)); let (tx, rx) = channel(); consume(tx, rx); }

pub/crate导出

Rust 中元素的隐私性是从模块层面开始的。作为程序库的作者,要从模块向用户公开一些内容可以使用关键字 pub。

但是对于有一些元素,我们只想暴露给软件包中的其他模块,而不是用户。

在这种情况下,我们可以对元素使用 pub(crate)修饰符,这允许元素仅在软件包内部暴露

参考资源

online-book

- Visibility and privacy - The Rust Reference

- pub(in path), pub(crate), pub(super), and pub(self) - The Rust Reference

- Managing Growing Projects with Packages, Crates, and Modules - The Rust Programming Language

- Modules - Rust By Example

- Crates - Rust By Example

fragment

-

- 项目(Packages):一个 Cargo 提供的 feature,可以用来构建、测试和分享包

- 包(Crate):一个由多个模块组成的树形结构,可以作为三方库进行分发,也可以生成可执行文件进行运行

- 模块(Module):可以一个文件多个模块,也可以一个文件一个模块,模块可以被认为是真实项目中的代码组织单元

-

Workspaces - The Cargo Book 默认情况下,一个Cargo.toml只能指明一个package,但是在workspace里面就可以指明多个(此时可以理解为这个package包含多个subpackage),比如substrate的根cargo:

[workspace]

resolver = "2"

members = [

"bin/node-template/node",

]

[profile.dev.package]

blake2 = { opt-level = 3 }

A crate is the [lib] or [[bin]] tables in the Cargo.toml. At most one lib crate may be present, but an arbitrary number of bin crates may be present.

You won’t see these tables added explicitly too often, because they’re implicitly present if you have src/lib.rs (lib crate) and/or src/main.rs (bin crate).

# Example of customizing the library in Cargo.toml.

[lib]

crate-type = ["cdylib"]

bench = false

# Example of customizing binaries in Cargo.toml.

[[bin]]

name = "cool-tool"

test = false

bench = false

[[bin]]

name = "frobnicator"

required-features = ["frobnicate"]

- 一个包是一个或多个提供一组功能的 crates。一个package包含一个 Cargo.toml 文件,该文件描述了如何构建这些crate。

- crate 可以是二进制 crate 或库 crate。

- 二进制 crate 是可以编译成可执行文件的程序,可以运行,例如命令行程序或服务器。

它们必须有一个名为 main 的函数,该函数定义了可执行文件运行时会发生什么。到目前为止,我们创建的所有 crate 都是二进制 crate。

- 库 crates 没有 main 函数,它们不会编译为可执行文件。它们定义了旨在与多个项目共享的功能。

例如,我们在第 2 章中使用的 rand crate 提供了生成随机数的功能。

- 下面是一些规则:

- 一个包最多可以包含一个库 crate。它可以包含任意数量的二进制 crate,但它必须至少包含一个 crate(库或二进制)。

- 当我们输入cargo new时,Cargo 创建了一个 Cargo.toml 文件,cargo将会给我们一个package。

- 查看 Cargo.toml 的内容,没有提到 src/main.rs,因为 Cargo 遵循一个约定,即 src/main.rs 是与包同名的二进制 crate 的 crate 根。

- 同样,Cargo 知道如果包目录包含 src/lib.rs,则该包包含一个与包同名的库 crate,并且 src/lib.rs 是它的 crate 根。

Cargo 将 crate 根文件传递给 rustc 以构建库或二进制文件。

- 在这里,我们有一个只包含 src/main.rs 的包,这意味着它只包含一个名为 my-project 的二进制 crate。

- 如果一个包包含 src/main.rs 和 src/lib.rs,它有两个 crate:一个二进制文件和一个库,两者都与包同名。

通过将文件放在 src/bin 目录中,一个包可以有多个二进制 crate:每个文件都是一个单独的二进制crate

-

Rust的模块化系统: 包Packages, 箱Crates, 和模块Modules - 知乎 包 Packages: Cargo提供的让我们创建, 测试和分享Crates的工具. 箱 Crates: 提供类库或可执行文件的模块树 模块 Modules and use: 管理和组织路径, 及其作用域和访问权限 路径 Paths: 如结构体(structs), 函数(function), 或模块(module)等事物的命名方式

Module System

一个问题几乎总会由许多小问题组成。module system是为了定义清楚各个小问题的边界。这样更容易和更方便的管理问题。而大问题的解法,就是把小问题的解法组合起来。

project,package, crate, module这些概念感觉相似。实际上,一个package/project可以包含多个 binary crates和一个或者零个library binary。一个crate可以包含多个module。可以认为package就是一个project,一个crate就是一个暴露给外界的逻辑单元,一个module就是一个小问题的解法。

当project里面有lib.rs说明这个project是一个library crate,这个library的名字是project的名字。main.rs/main2.rs都可以直接使用这个library crate。我们可以认为bin文件夹里面是单独的crate,它们默认导入了这个library crate。

一个crate就是一个暴露给外界的逻辑单元,一个module就是一个小问题的解法

关于找不到模块: 这就是module tree的体现,be explicit。所有模块都需要添加到crate root(src/main.rs或者src/lib.rs)里面。也就是要显示地指明module tree的结构。这也就是我们经常在main.rs/lib.rs里面看到许多mod xxx的原因。比如这里的代码

它们的存在就是为了将project里面的modules 加到这个crate里面。比如在main.rs 里面看到mod channel,就是将module channel加进crate的module tree来。

相关引用: Mentally Modelling Modules - In Pursuit of Laziness

-

Clear explanation of Rust’s module system 作者通过举例,详细介绍了rust编译器与程序猿看到的不同项目结构。

-

The confusion around Rust’s modules reminds me of the different ways that people… | Hacker News The confusion around Rust’s modules reminds me of the different ways that people learn how to use car indicators. Some people learn that you push the stalk up to indicate your intent to turn left, or down to turn right. And then they might eventually learn that in a European car, you push the stalk down to turn left, and up to turn right. And then of course some of these people get confused when switching between different cars. Yes, I’ve seen plenty of people on the road who indicate one direction and then turn another. It’s… kind of frightening .

The other way of learning to use car indicators is much simpler: push the stalk in the direction that you would turn the wheel. Of course this still leaves the possibility that some people will push the wrong stalk, and briefly activate their windshield wipers . But it’s a much easier mistake to notice, and the consequences are minor.

Back to Rust’s modules. I keep seeing articles trying to offer a simple or clear explanation of how they work, that end up unnecessarily complicated in a way that feels a lot like the “up/down” model of car indicators. The explanation that makes the basics of Rust modules clear to me is this:

-

Child modules must always be declared in the parent module, or they don’t exist.

-

The content of child modules may be defined either inline in the parent as

mod child { ... }, or in a file with a relative path of ‘./child.rs’ or ‘./child/mod.rs’.

Did I miss anything important?

Without this basic explanation up-front, I have no idea what to do with the stream of information I’m reading in a lengthy article on the topic – I’ve been given no scaffolding onto which to bolt all the details and examples. So this is the “bottom line” that I would like to see “up front” in descriptions of Rust’s modules.

Other misunderstandings, e.g., around item visibility, are explained really well by the compiler if you get them mixed up, so I’m not sure how much value there is in mixing them in to articles about how modules are structured before those two basic facts are presented.

The processing of that source file may result in other source files being loaded as modules. It is not that one source file makes up a crate: it’s that starting from that one source file, you can find all the files making up the crate, as opposed to other compilation models where the compiler might be given many file names to start from.

其实从代码完整性考虑,crate确实就是编译的最小基本单位。因为它不仅指一个源码文件(xx.rs),而是包含这个源码文件里面引入的所有其他module。这个时候,rustc才会开始编译这个crate

The exact things hosted on crates.io are crates inside packages. A crate is the output artifact of the compiler. The compilation model centers on artifacts called crates. Each compilation processes a single crate in source form, and if successful, produces a single crate in binary form: either an executable or some sort of library. A package is an artifact managed by Cargo, the Rust package manager.

local

Cargo与crate生命周期

- Cargo与crate生命周期

- Cargo.toml细说

- Rust程序运行方式总结

- 参考资源

cargo : 用生命周期理解Cargo指令系列

新建

cargo new

cargo init

开发

cargo clean

cargo doc

依赖管理

cargo check

该命令用来快速检查当前代码是否可以通过编译,但是不去生成真正可执行的程序。这样可以加快我们的检查速度。

cargo fix

cargo fetch

cargo search/install/uninstall

从crates.io拉取安装

cargo install

从源码进行安装

cargo install <Cargo.toml path> –debug –locked

cargo report

cargo generate-lockfile

cargo locate-project

cargo metadata

cargo pkgid

cargo tree

cargo update

cargo vendor

cargo verify-project

测试

cargo test

cargo bench

运行

cargo run

cargo watch

每保存一次都自动编译,需要安装crate

cargo expand

构建

cargo rustc

cargo build

cargo build --release

该命令将会在 target/release/目录下生成优化过的可执行程序。这样生成的可执行程序拥有更好的性能。

cargo rustdoc

发布

cargo login

cargo owner

cargo package

cargo publish

cargo yank

维护

分区

Cargo.toml细说

Rust程序运行方式总结

脚本

项目

参考资源

online-book

fragment

local

cargo与rustc

- cargo与rustc

rustc

rustc是什么

全称应该是“rust complier“, 是 Rust 编程语言的编译器,由项目本身提供。编译器获取源代码并生成二进制代码,作为库或可执行文件。

基础使用

rustc target_file.rs

rustc与cargo的关系

这其实就类似前端webpack.config和package.json的关系, cargo在运行时会默认调用rustc指令。

cargo style

cargo可以看作是基于rustc的“管理框架“,主要还是对于项目用到的包的管理。

这里可以看到具体有哪些功能

cargo essential structure

但是对于大多数场景下,一般采用如下的项目结构

$ tree use-benchmarking -L 2 ─╯

use-benchmarking

├── Cargo.toml

├── README.md

└── src

├── benchmarking.rs

├── lib.rs

├── mock.rs

├── tests.rs

└── weights.rs

1 directory, 7 files

.cargo 扩展

除了cargo, 它的全局相关配置文件都会放在$HOME/.cargo目录下,这里值得看看

tree overview

tree -L 1 $HOME/.cargo ─╯

├── bin # 安装的二进制相关可执行文件

├── env # rustup的环境变量设置脚本

├── git

└── registry

bin

tree -L 1 $HOME/.cargo/bin ─╯

├── cargo -> /usr/local/bin/rustup-init

├── cargo-clippy -> /usr/local/bin/rustup-init

├── cargo-fmt -> /usr/local/bin/rustup-init

├── cargo-miri -> /usr/local/bin/rustup-init

├── clippy-driver -> /usr/local/bin/rustup-init

├── mdbook

├── mdbook-admonish

├── mdbook-checklist

├── mdbook-mermaid

├── mdbook-pdf

├── mdbook-rss

├── mdbook-template

├── rls -> /usr/local/bin/rustup-init

├── rust-gdb -> /usr/local/bin/rustup-init

├── rust-lldb -> /usr/local/bin/rustup-init

├── rustc -> /usr/local/bin/rustup-init

├── rustdoc -> /usr/local/bin/rustup-init

├── rustfmt -> /usr/local/bin/rustup-init

└── rustup -> /usr/local/bin/rustup-init

0 directories, 19 files

env

#!/bin/sh

# rustup shell setup

# affix colons on either side of $PATH to simplify matching

case ":${PATH}:" in

*:"$HOME/.cargo/bin":*)

;;

*)

# Prepending path in case a system-installed rustc needs to be overridden

export PATH="$HOME/.cargo/bin:$PATH"

;;

esac

git

tree -L 3 $HOME/.cargo/git ─╯

/Users/kuanhsiaokuo/.cargo/git

├── checkouts

│ ├── substrate-7e08433d4c370a21

│ │ ├── 174735e

│ │ ├── 257cdb5

│ │ ├── 279593d

│ │ ├── 3348e14

│ │ ├── 346471d

│ │ ├── 4d28ebe

│ │ ├── 7ba4e4c

│ │ ├── 7eb671f

│ │ ├── 814752f

│ │ ├── 852bab0

│ │ ├── b6c1c1b

│ │ └── bf9683e

│ └── unveil-rs-403565214a7cc66c

│ └── 3d8e9ad

└── db

├── substrate-7e08433d4c370a21

│ ├── FETCH_HEAD

│ ├── HEAD

│ ├── config

│ ├── description

│ ├── hooks

│ ├── info

│ ├── objects

│ └── refs

└── unveil-rs-403565214a7cc66c

├── FETCH_HEAD

├── HEAD

├── config

├── description

├── hooks

├── info

├── objects

└── refs

27 directories, 8 files

registry

tree -L 2 $HOME/.cargo/registry ─╯

/Users/kuanhsiaokuo/.cargo/registry

├── cache

│ └── github.com-1ecc6299db9ec823

├── index

│ └── github.com-1ecc6299db9ec823

└── src

└── github.com-1ecc6299db9ec823

6 directories, 0 files

Cargo 与 git 的关联!

cargo tree

- Cargo.toml是分等级的,最外层的Cargo.toml里面可以只用一个members,然后里面列出内部包含的其他packages

最外层的Cargo.toml

[workspace]

members = [

"node",

"pallets/template",

"runtime",

]

[profile.release]

panic = "unwind"

- 然后内部的其他packages就需要列出用到的[dependencies]

- dependencies的完整使用参数如下:

[dependencies]

pallet-aura = { version = "4.0.0-dev", default-features = false, git = "https://github.com/paritytech/substrate.git", branch = "polkadot-v0.9.24" }

[dependencies.pallet-aura]

version = "4.0.0-dev"

default-features = false

git = "https://github.com/paritytech/substrate.git"

branch = "polkadot-v0.9.24"

这里的branch也可以用tag(git tag)

git

上面dependencie里面的git+branch/tag唯一确定了一份代码,cargo下载对应的git代码之后,会从最外层Cargo.toml顺着members一层层找到[package]如下所示的Cargo.toml来确定对应的依赖包

[package]

name = "pallet-aura"

version = "4.0.0-dev"

authors = ["Parity Technologies <admin@parity.io>"]

edition = "2021"

license = "Apache-2.0"

homepage = "https://substrate.io"

repository = "https://github.com/paritytech/substrate/"

description = "FRAME AURA consensus pallet"

readme = "README.md"

关于依赖冲突问题

目前Cargo无法解决依赖冲突问题,一般都会是因为dependencies里面的git+branch/tag对应的依赖更新导致。

应用场景: substrate添加pallet

Cargo相关问题解决

版本冲突:failed to select a version for the requirement

Apparently, Cargo can sometimes get into a state where its local registry cache will corrupt itself, and Cargo won’t be able to discover new versions of the dependencies. To resolve this, delete the ~/.cargo/registry folder and run the build command again.

- 修改dependencies cargo install 出现需求版本选择失败怎么办–Qiita

Cargo项目结构

基础说明

- cargo.toml和cargo.lock文件总是位于项目根目录下。

- 源代码位于src目录下。

- 默认的库入口文件是src/lib.rs。

- 默认的可执行程序入口文件是src/main.rs。

- 其他可选的可执行文件位于src/bin/*.rs(这里每一个rs文件均对应一个可执行文件)。

- 外部测试源代码文件位于tests目录下。

- 示例程序源代码文件位于examples。

- 基准测试源代码文件位于benches目录下。

cargo.toml和cargo.lock

cargo.toml和cargo.lock是cargo项目代码管理的核心两个文件,cargo工具的所有活动均基于这两个文件。

cargo.toml是cargo特有的项目数据描述文件,对于猿们而言,cargo.toml文件存储了项目的所有信息,它直接面向rust猿,猿们如果想让自己的rust项目能够按照期望的方式进行构建、测试和运行,那么,必须按照合理的方式构建’cargo.toml’。

而cargo.lock文件则不直接面向猿,猿们也不需要直接去修改这个文件。lock文件是cargo工具根据同一项目的toml文件生成的项目依赖详细清单文件,所以我们一般不用不管他,只需要对着cargo.toml文件撸就行了。

构建、清理、更新以及安装

领会了toml描述文件的写法,是一个重要的方面。另一个重要的方面,就是cargo工具本身为我们程序猿提供的各种好用的工具。如果大家感兴趣,自己在终端中输入’cargo –help’查看即可。

- 其中开发时最常用的命令就是’cargo build’,用于构建项目。

- 此外,’cargo clean’命令可以清理target文件夹中的所有内容;

- ’cargo update’根据toml描述文件重新检索并更新各种依赖项的信息,并写入lock文件,例如依赖项版本的更新变化等等;

- ’cargo install’可用于实际的生产部署。这些命令在实际的开发部署中均是非常有用的。

main.rs 和 lib.rs

┏━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ _ ┃

┃ _ __ __ _(_)_ _ _ _ ___ ┃

┃ | ' \/ _` | | ' \ _| '_(_-< ┃

┃ |_|_|_\__,_|_|_||_(_)_| /__/ ┃

┃ ┃

┃ _ _ _ _ _ _ ┃

┃| |_ __ _ _ _ __| | |___ ___ _ _ _ _ _ _ _ _ (_)_ _ __ _ | |_| |_ ___ ┃

┃| ' \/ _` | ' \/ _` | / -_|_-< | '_| || | ' \| ' \| | ' \/ _` | | _| ' \/ -_)┃

┃|_||_\__,_|_||_\__,_|_\___/__/ |_| \_,_|_||_|_||_|_|_||_\__, | \__|_||_\___|┃

┃ |___/ ┃

┃ ┃

┃ _ __ _ _ ___ __ _ _ _ __ _ _ __ ┃

┃ | '_ \ '_/ _ \/ _` | '_/ _` | ' \ ┃

┃ | .__/_| \___/\__, |_| \__,_|_|_|_| ┃

┃ |_| |___/ ┃

┃ ┃

┃1. cargo new --bin ┃

┃- Calling the command line parsing logic with the argument values ┃

┃- Setting up any other configuration ┃

┃- Calling a run function in lib.rs ┏━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┻━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃- Handling the error if run returns an error ┃All are rust basic entry: ╳ _ _ _ ┃

┃ ┃1. main.rs is the running entry ╳ | (_) |__ _ _ ___ ┃

┃ ┃2. lib.rs is the library entry ╳ | | | '_ \_| '_(_-< ┃

┃ ┃╳╳╳╳╳╳╳╳╳╳╳╳╳╳╳╳╳╳╳╳╳╳╳╳╳╳╳╳╳╳╳╳ |_|_|_.__(_)_| /__/ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┫ ┃

┃ _ _ _ _ _ _ _ _ _ ┃

┃ | |_ __ _ _ _ __| | |___ ___ __ _| | | | |_| |_ ___ | |___ __ _(_)__ ┃

┃ | ' \/ _` | ' \/ _` | / -_|_-< / _` | | | | _| ' \/ -_) | / _ \/ _` | / _| ┃

┃ |_||_\__,_|_||_\__,_|_\___/__/ \__,_|_|_| \__|_||_\___| |_\___/\__, |_\__| ┃

┃ |___/ ┃

┃ __ _ _ _ _ _ _ _ ┃

┃ ___ / _| | |_| |_ ___ | |_ __ _ __| |__ __ _| |_ | |_ __ _ _ _ __| | ┃

┃ / _ \ _| | _| ' \/ -_) | _/ _` (_-< / / / _` | _| | ' \/ _` | ' \/ _` | ┃

┃ \___/_| \__|_||_\___| \__\__,_/__/_\_\ \__,_|\__| |_||_\__,_|_||_\__,_| ┃

┃ ┃

┃ ┃

┃ ┃

┃ ┃

┃ ┃

┃ ┃

┃ ┃

┃ ┃

┃ ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

-

包(package)创建规则:

- 一个包中至多只能包含一个库Crate。 - 包中可以包含任意多个二进制Crate。 - 包中至少包含一个 crate,无论是库的还是二进制的。 - 包中应该包含一个 Cargo.toml 配置文件,用来说明如何去构建这些 crate。示例一:cargo new –bin 创建一个包含 二进制Crate 的包 示例二:cargo new –lib 创建一个包含库(lib)crate的包 示例三:–lib和–bin不可以同时使用,这种情况下可以示例一的基础上自己创建一个lib.rs文件

- 一般情况下,我们将与程序运行相关的代码放在 main.rs 文件,其他真正的任务逻辑放在 lib.rs 文件中。

-