源码解析逻辑

- 源码解析逻辑

项目文档

来源

- 第三方crate可以在官方文档上面搜索

- 本地crate可以使用命令

cargo doc --open.

cargo doc命令使用

–open

自动生成文档并在浏览器打开

–no-deps

默认情况下会把项目依赖的包文档也生成,这也是文档左侧Crates的来源之一。 这个参数可以屏蔽掉依赖的crates

使用区别

- 二者内容没有区别,官方文档也是执行命令生成文档。

- 官方文档还可以提供很多细节,比如git分支地址

使用细节

这里按照文档的层级进行递进说明

Crates

所有文档的首页都会有这一项,列出项目包含的crate

crate包含成员

点击Crates下的某个crate,右侧页面就会显示当前crate包含的元素, 主要有下列内容

- Re-exports

- Modules

- Macros

- Derive Macros

- Attribute Macros

- Structs

- Enums

- Constants

- Traits

- Functions

- Type Definitions

Re-exports

futures_util

#![allow(unused)] fn main() { pub use reader::DecompressorCustomIo; }

Modules

其实就是mod,点击之后将会列出某个mod里面的成员

Macros

Derive Macros

darling_macro、clap_derive

Attribute Macros

tokio_macros、futures_macro

Structs

Definition

Associated Types

Implementations

Trait Implementations

Auto Trait Implementations

Blanket Implementations

Enums

Definition

Variants

Trait Implementations

Auto Trait Implementations

Blanket Implementations

Constants

Traits

Definition

Required methods

Implementations on Foreign Types

Implementors

Functions

Definition

Type Definitions

Definition

html2md

#![allow(unused)] fn main() { pub type BoxedError = Box<dyn Error + Send + Sync>; }

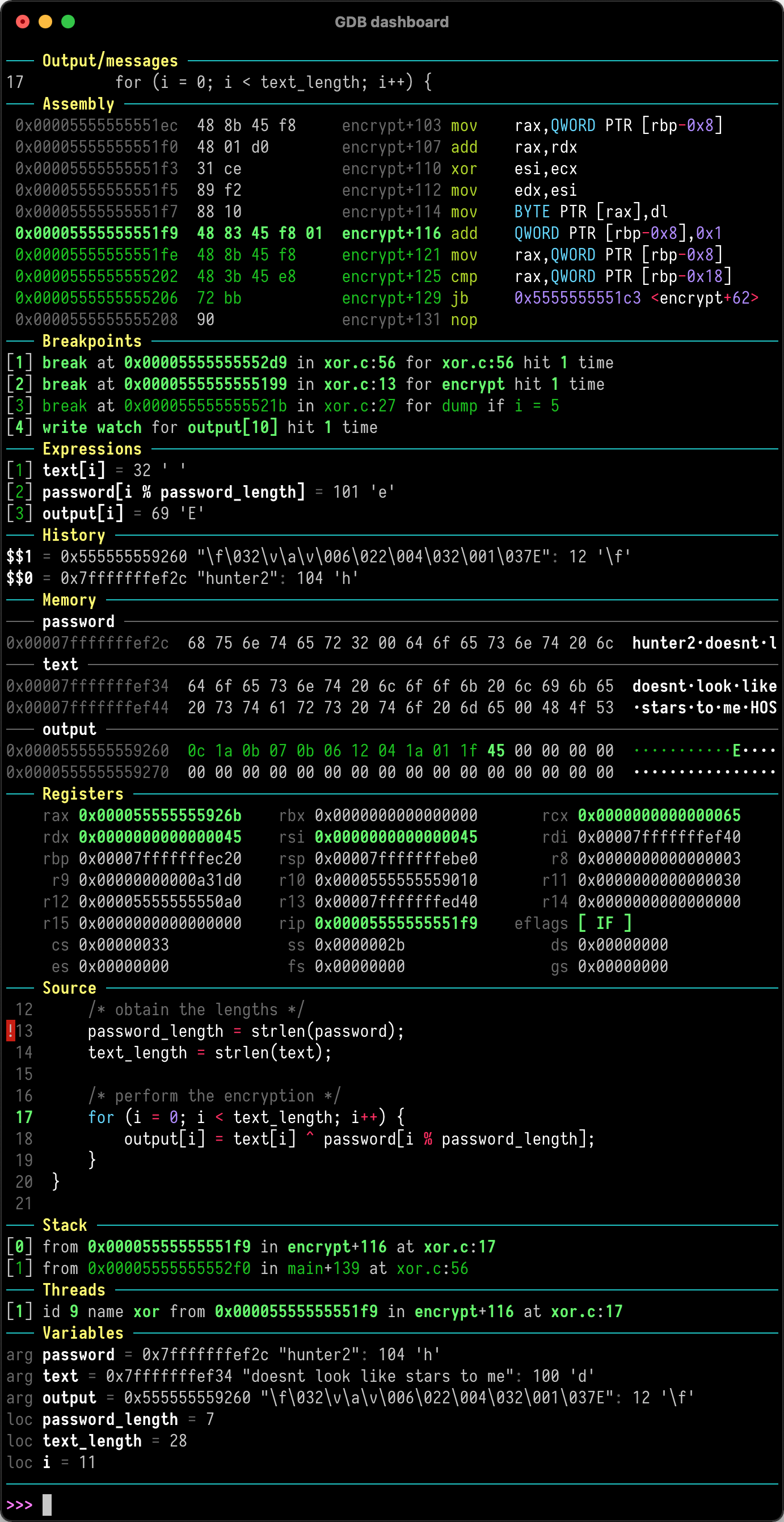

gdb/lldb调试或查看内存结构

gdb/lldb

资料整理

官方数据结构cheat sheet

gdb强化插件

gdb: 主要是linux系统

lldb: 主要OSX系统

IDEA

gdb与lldb命令对照

gdb与lldb命令对照

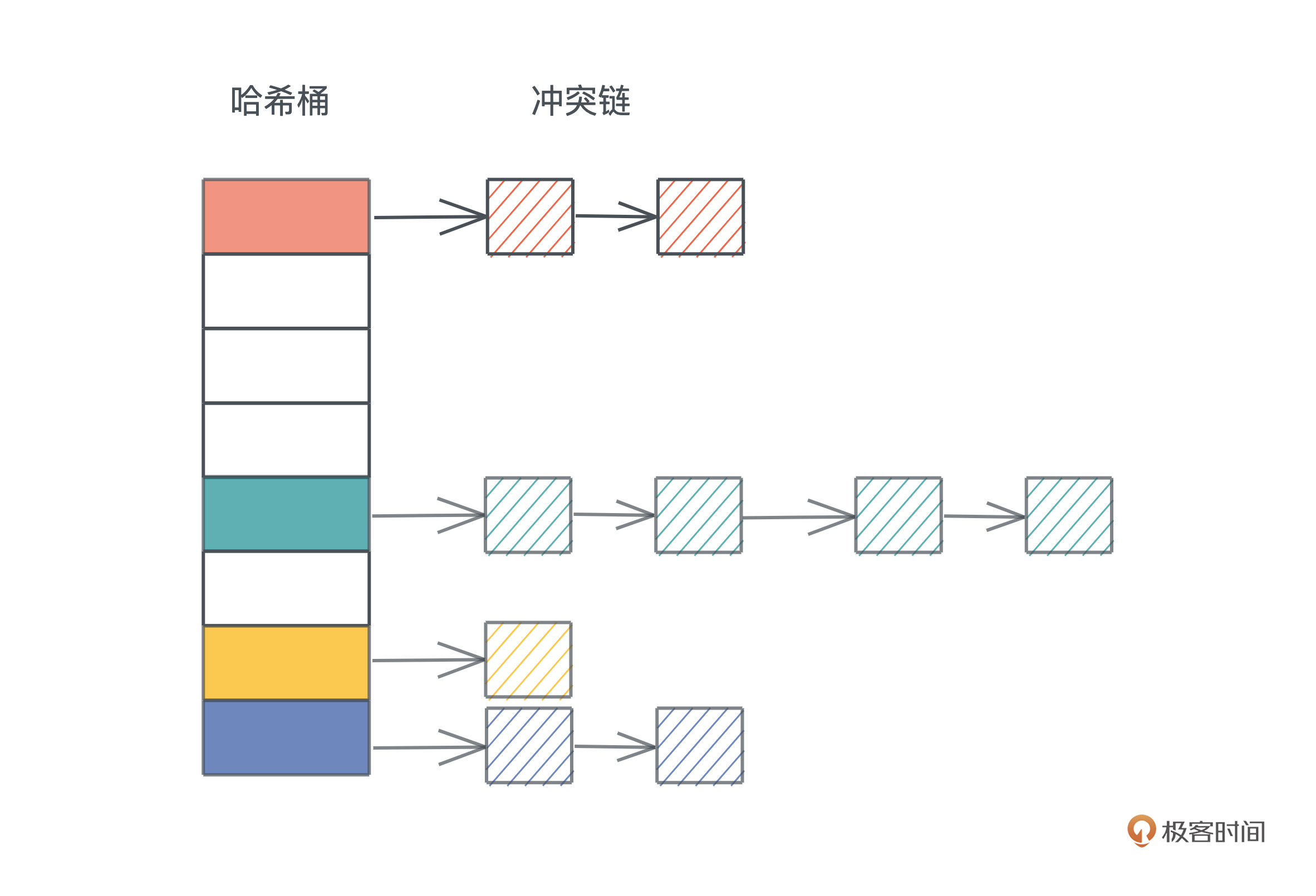

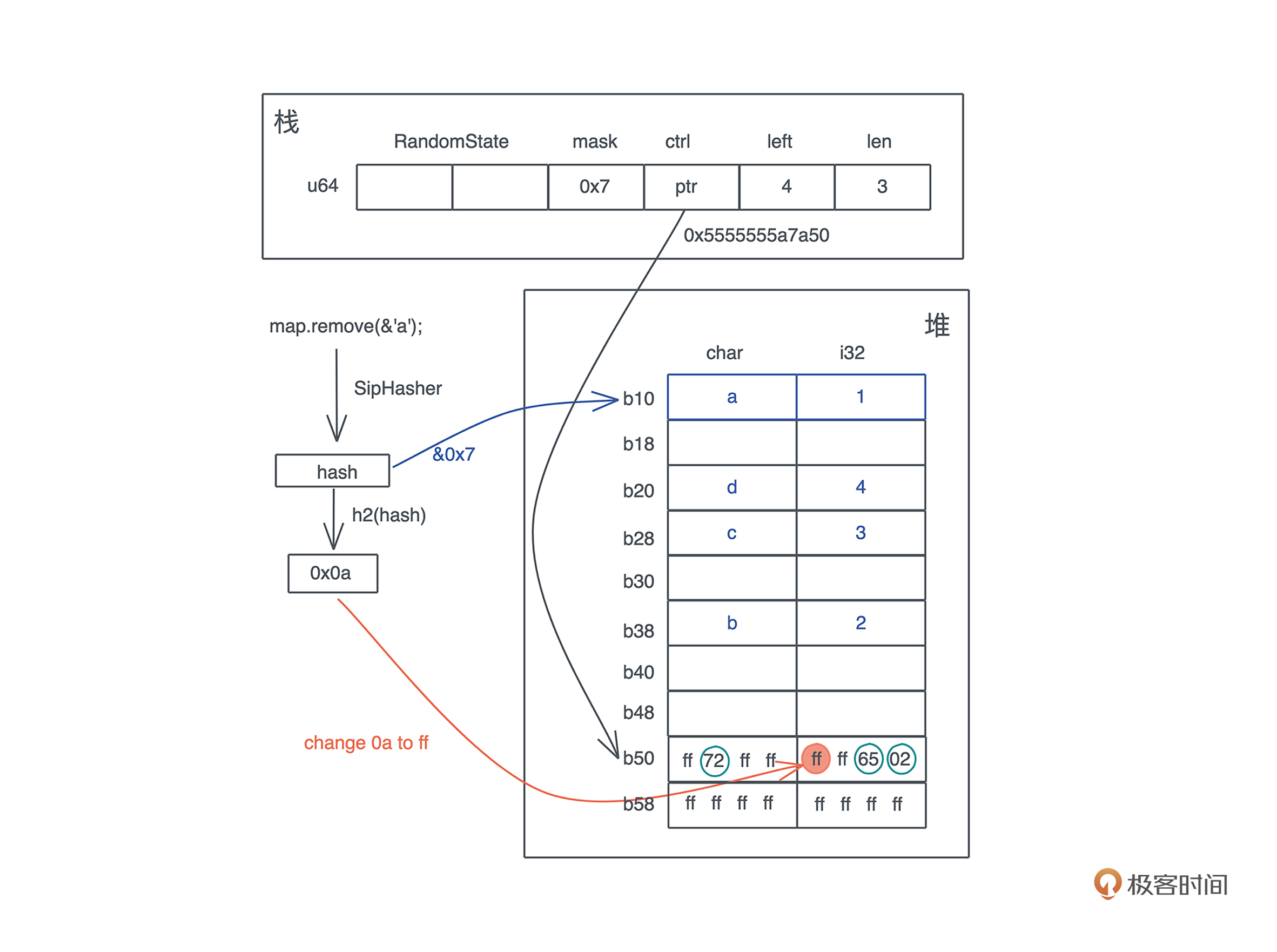

查看hashmap内存结构

- bin配置与运行

[package]

name = "hashtable"

version = "0.1.0"

edition = "2021"

[[bin]]

name = "hashmap1"

path = "src/hashmap1.rs"

[[bin]]

name = "hashmap2"

path = "src/hashmap2.rs"

[[bin]]

name = "hash"

path = "src/hash.rs"

[[bin]]

name = "siphasher"

path = "src/siphasher.rs"

doc = false

[[bin]]

name = "hashmap3"

path = "src/hashmap3.rs"

[[bin]]

name = "btreemap1"

path = "src/btreemap1.rs"

# See more keys and their definitions at https://doc.rust-lang.org/cargo/reference/manifest.html

[dependencies]

如果要单独运行指定bin文件:

cargo run --bin hashmap2

- 目标调试代码

use std::collections::HashMap; fn main() { let map = HashMap::new(); let mut map = explain("empty", map); map.insert('a', 1); let mut map = explain("added 1", map); map.insert('b', 2); map.insert('c', 3); let mut map = explain("added 3", map); map.insert('d', 4); let mut map = explain("added 4", map); map.remove(&'a'); explain("final", map); } // HashMap 结构有两个 u64 的 RandomState,然后是四个 usize, // 分别是 bucket_mask, ctrl, growth_left 和 items // 我们 transmute 打印之后,再 transmute 回去 fn explain<K, V>(name: &str, map: HashMap<K, V>) -> HashMap<K, V> { let arr: [usize; 6] = unsafe { std::mem::transmute(map) }; println!( "{}: bucket_mask 0x{:x}, ctrl 0x{:x}, growth_left: {}, items: {}", name, arr[2], arr[3], arr[4], arr[5] ); unsafe { std::mem::transmute(arr) } }

使用gdb/lldb进行调试查看内存结构

- 开始调试

rust-lldb target/debug/hashmap2 ─╯

(lldb) command script import "/Users/kuanhsiaokuo/.rustup/toolchains/stable-x86_64-apple-darwin/lib/rustlib/etc/lldb_lookup.py"

(lldb) command source -s 0 '/Users/kuanhsiaokuo/.rustup/toolchains/stable-x86_64-apple-darwin/lib/rustlib/etc/lldb_commands'

Executing commands in '/Users/kuanhsiaokuo/.rustup/toolchains/stable-x86_64-apple-darwin/lib/rustlib/etc/lldb_commands'.

(lldb) type synthetic add -l lldb_lookup.synthetic_lookup -x ".*" --category Rust

(lldb) type summary add -F lldb_lookup.summary_lookup -e -x -h "^(alloc::([a-z_]+::)+)String$" --category Rust

(lldb) type summary add -F lldb_lookup.summary_lookup -e -x -h "^&(mut )?str$" --category Rust

(lldb) type summary add -F lldb_lookup.summary_lookup -e -x -h "^&(mut )?\\[.+\\]$" --category Rust

(lldb) type summary add -F lldb_lookup.summary_lookup -e -x -h "^(std::ffi::([a-z_]+::)+)OsString$" --category Rust

(lldb) type summary add -F lldb_lookup.summary_lookup -e -x -h "^(alloc::([a-z_]+::)+)Vec<.+>$" --category Rust

(lldb) type summary add -F lldb_lookup.summary_lookup -e -x -h "^(alloc::([a-z_]+::)+)VecDeque<.+>$" --category Rust

(lldb) type summary add -F lldb_lookup.summary_lookup -e -x -h "^(alloc::([a-z_]+::)+)BTreeSet<.+>$" --category Rust

(lldb) type summary add -F lldb_lookup.summary_lookup -e -x -h "^(alloc::([a-z_]+::)+)BTreeMap<.+>$" --category Rust

(lldb) type summary add -F lldb_lookup.summary_lookup -e -x -h "^(std::collections::([a-z_]+::)+)HashMap<.+>$" --category Rust

(lldb) type summary add -F lldb_lookup.summary_lookup -e -x -h "^(std::collections::([a-z_]+::)+)HashSet<.+>$" --category Rust

(lldb) type summary add -F lldb_lookup.summary_lookup -e -x -h "^(alloc::([a-z_]+::)+)Rc<.+>$" --category Rust

(lldb) type summary add -F lldb_lookup.summary_lookup -e -x -h "^(alloc::([a-z_]+::)+)Arc<.+>$" --category Rust

(lldb) type summary add -F lldb_lookup.summary_lookup -e -x -h "^(core::([a-z_]+::)+)Cell<.+>$" --category Rust

(lldb) type summary add -F lldb_lookup.summary_lookup -e -x -h "^(core::([a-z_]+::)+)Ref<.+>$" --category Rust

(lldb) type summary add -F lldb_lookup.summary_lookup -e -x -h "^(core::([a-z_]+::)+)RefMut<.+>$" --category Rust

(lldb) type summary add -F lldb_lookup.summary_lookup -e -x -h "^(core::([a-z_]+::)+)RefCell<.+>$" --category Rust

(lldb) type category enable Rust

(lldb) target create "target/debug/hashmap2"

Current executable set to '/Users/kuanhsiaokuo/Developer/spare_projects/rust_lab/geektime-rust/geektime_rust_codes/target/debug/hashmap2' (x86_64).

(lldb)

- b(reakpoint): 添加断点

在32行打断点,方便看std::mem::transmute(arr)

(lldb) b hashmap2.rs:32

Breakpoint 1: where = hashmap2`hashmap2::explain::h4091c852f38a0de4 + 406 at hashmap2.rs:32:34, address = 0x0000000100008d16

- r(un):运行到断点

(lldb) r

Process 69337 launched: '/Users/kuanhsiaokuo/Developer/spare_projects/rust_lab/geektime-rust/geektime_rust_codes/target/debug/hashmap2' (x86_64)

empty: bucket_mask 0x0, ctrl 0x100043d20, growth_left: 0, items: 0

Process 69337 stopped

* thread #1, queue = 'com.apple.main-thread', stop reason = breakpoint 1.1

frame #0: 0x0000000100008d16 hashmap2`hashmap2::explain::h4091c852f38a0de4(name="empty", map=<unavailable>) at hashmap2.rs:32:34

29 "{}: bucket_mask 0x{:x}, ctrl 0x{:x}, growth_left: {}, items: {}",

30 name, arr[2], arr[3], arr[4], arr[5]

31 );

-> 32 unsafe { std::mem::transmute(arr) }

33 }

Target 0: (hashmap2) stopped.

# 最初的状态,哈希表为空

empty: bucket_mask 0x0, ctrl 0x100043d20, growth_left: 0, items: 0

- c(ontinue):继续单步执行

(lldb) c

Process 69337 resuming

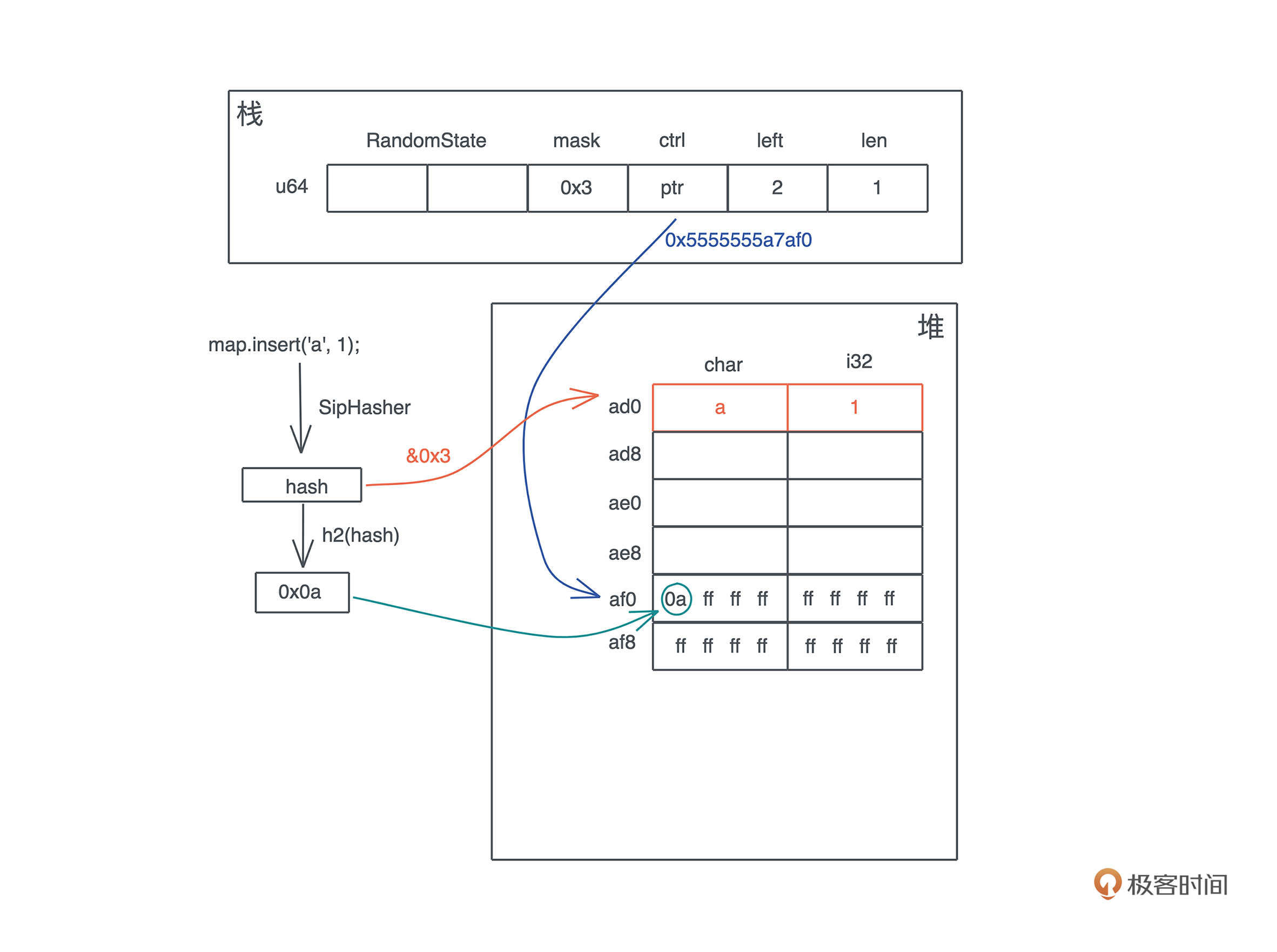

added 1: bucket_mask 0x3, ctrl 0x600001700160, growth_left: 2, items: 1

Process 69337 stopped

* thread #1, queue = 'com.apple.main-thread', stop reason = breakpoint 1.1

frame #0: 0x0000000100008d16 hashmap2`hashmap2::explain::h4091c852f38a0de4(name="added 1", map=<unavailable>) at hashmap2.rs:32:34

29 "{}: bucket_mask 0x{:x}, ctrl 0x{:x}, growth_left: {}, items: {}",

30 name, arr[2], arr[3], arr[4], arr[5]

31 );

-> 32 unsafe { std::mem::transmute(arr) }

33 }

Target 0: (hashmap2) stopped.

# 插入了一个元素后,bucket 有 4 个(0x3+1),堆地址起始位置 0x600001700160 - 4*8(0x20)

added 1: bucket_mask 0x3, ctrl 0x600001700160, growth_left: 2, items: 1

- x: 打印内存地址

# 以12进制打印从内存地址开始的值

(lldb) x/12x 0x600001700160

0x600001700160: 0xffff6dff 0xffffffff 0xffffffff 0xffffffff

0x600001700170: 0xffff6dff 0x00000000 0x00000000 0x00000000

0x600001700180: 0x20ec913f 0x00007ff8 0x4e5ef01e 0x00000000

- c(ontinue): 继续执行到下一个断点

(lldb) c

Process 69337 resuming

added 3: bucket_mask 0x3, ctrl 0x600001700160, growth_left: 0, items: 3

Process 69337 stopped

* thread #1, queue = 'com.apple.main-thread', stop reason = breakpoint 1.1

frame #0: 0x0000000100008d16 hashmap2`hashmap2::explain::h4091c852f38a0de4(name="added 3", map=<unavailable>) at hashmap2.rs:32:34

29 "{}: bucket_mask 0x{:x}, ctrl 0x{:x}, growth_left: {}, items: {}",

30 name, arr[2], arr[3], arr[4], arr[5]

31 );

-> 32 unsafe { std::mem::transmute(arr) }

33 }

Target 0: (hashmap2) stopped.

# # 插入了三个元素后,哈希表没有剩余空间,堆地址起始位置不变 0x600001700160 - 4*8(0x20)

added 3: bucket_mask 0x3, ctrl 0x600001700160, growth_left: 0, items: 3

(lldb) x/12x 0x600001700160

0x600001700160: 0x16ff6d66 0xffffffff 0xffffffff 0xffffffff

0x600001700170: 0x16ff6d66 0x00000000 0x00000000 0x00000000

0x600001700180: 0x20ec913f 0x00007ff8 0x4e5ef01e 0x00000000

(lldb) c

Process 69337 resuming

added 4: bucket_mask 0x7, ctrl 0x600002604040, growth_left: 3, items: 4

Process 69337 stopped

* thread #1, queue = 'com.apple.main-thread', stop reason = breakpoint 1.1

frame #0: 0x0000000100008d16 hashmap2`hashmap2::explain::h4091c852f38a0de4(name="added 4", map=<unavailable>) at hashmap2.rs:32:34

29 "{}: bucket_mask 0x{:x}, ctrl 0x{:x}, growth_left: {}, items: {}",

30 name, arr[2], arr[3], arr[4], arr[5]

31 );

-> 32 unsafe { std::mem::transmute(arr) }

33 }

Target 0: (hashmap2) stopped.

# 插入第四个元素后,哈希表扩容,堆地址起始位置变为 0x600002604040 - 8*8(0x40)

added 4: bucket_mask 0x7, ctrl 0x600002604040, growth_left: 3, items: 4

(lldb) x/12x 0x600002604040

0x600002604040: 0x16446d66 0xffffffff 0xffffffff 0xffffffff

0x600002604050: 0x16446d66 0xffffffff 0x00000000 0x00000000

0x600002604060: 0x00000000 0x00000000 0x00000000 0x00000000

(lldb) x/20x 0x600002604040

0x600002604040: 0x16446d66 0xffffffff 0xffffffff 0xffffffff

0x600002604050: 0x16446d66 0xffffffff 0x00000000 0x00000000

0x600002604060: 0x00000000 0x00000000 0x00000000 0x00000000

0x600002604070: 0x00000000 0x00000000 0x00000000 0x00000000

0x600002604080: 0x00000000 0x00000000 0x00000000 0x00000000

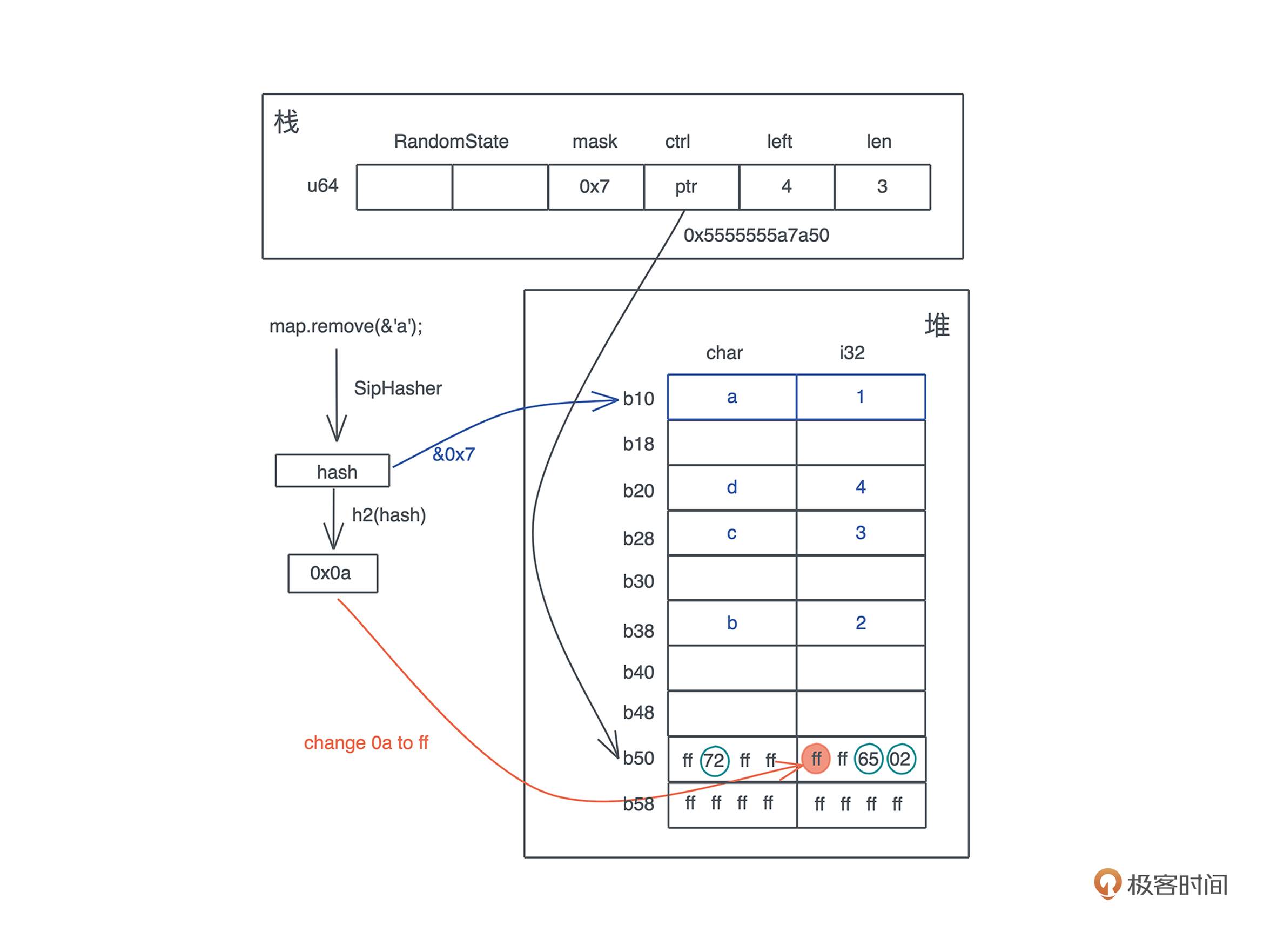

(lldb) c

Process 69337 resuming

final: bucket_mask 0x7, ctrl 0x600002604040, growth_left: 4, items: 3

Process 69337 stopped

* thread #1, queue = 'com.apple.main-thread', stop reason = breakpoint 1.1

frame #0: 0x0000000100008d16 hashmap2`hashmap2::explain::h4091c852f38a0de4(name="final", map=<unavailable>) at hashmap2.rs:32:34

29 "{}: bucket_mask 0x{:x}, ctrl 0x{:x}, growth_left: {}, items: {}",

30 name, arr[2], arr[3], arr[4], arr[5]

31 );

-> 32 unsafe { std::mem::transmute(arr) }

33 }

Target 0: (hashmap2) stopped.

# 删除 a 后,剩余 4 个位置。注意 ctrl bit 的变化,以及 0x61 0x1 并没有被清除

final: bucket_mask 0x7, ctrl 0x600002604040, growth_left: 4, items: 3

(lldb) x/12x 0x600002604040

0x600002604040: 0x1644ff66 0xffffffff 0xffffffff 0xffffffff

0x600002604050: 0x1644ff66 0xffffffff 0x00000000 0x00000000

0x600002604060: 0x00000000 0x00000000 0x00000000 0x00000000

(lldb) x/20x 0x600002604040

0x600002604040: 0x1644ff66 0xffffffff 0xffffffff 0xffffffff

0x600002604050: 0x1644ff66 0xffffffff 0x00000000 0x00000000

0x600002604060: 0x00000000 0x00000000 0x00000000 0x00000000

0x600002604070: 0x00000000 0x00000000 0x00000000 0x00000000

0x600002604080: 0x00000000 0x00000000 0x00000000 0x00000000

查看闭包的结构

代码:

use std::{collections::HashMap, mem::size_of_val}; fn main() { // 长度为 0 let c1 = || println!("hello world!"); // 和参数无关,长度也为 0 let c2 = |i: i32| println!("hello: {}", i); let name = String::from("tyr"); let name1 = name.clone(); let mut table = HashMap::new(); table.insert("hello", "world"); // 如果捕获一个引用,长度为 8 let c3 = || println!("hello: {}", name); // 捕获移动的数据 name1(长度 24) + table(长度 48),closure 长度 72 let c4 = move || println!("hello: {}, {:?}", name1, table); let name2 = name.clone(); // 和局部变量无关,捕获了一个 String name2,closure 长度 24 let c5 = move || { let x = 1; let name3 = String::from("lindsey"); println!("hello: {}, {:?}, {:?}", x, name2, name3); }; println!( "c1: {}, c2: {}, c3: {}, c4: {}, c5: {}, main: {}", size_of_val(&c1), size_of_val(&c2), size_of_val(&c3), size_of_val(&c4), size_of_val(&c5), size_of_val(&main), ) }

运行进入lldb

# 自动去examples目录找对应名字的代码文件

cargo run --example closure_size

rust-lldb ../target/debug/examples/closure_size ─╯

(lldb) command script import "/Users/kuanhsiaokuo/.rustup/toolchains/stable-x86_64-apple-darwin/lib/rustlib/etc/lldb_lookup.py"

(lldb) command source -s 0 '/Users/kuanhsiaokuo/.rustup/toolchains/stable-x86_64-apple-darwin/lib/rustlib/etc/lldb_commands'

Executing commands in '/Users/kuanhsiaokuo/.rustup/toolchains/stable-x86_64-apple-darwin/lib/rustlib/etc/lldb_commands'.

(lldb) type synthetic add -l lldb_lookup.synthetic_lookup -x ".*" --category Rust

(lldb) type summary add -F lldb_lookup.summary_lookup -e -x -h "^(alloc::([a-z_]+::)+)String$" --category Rust

(lldb) type summary add -F lldb_lookup.summary_lookup -e -x -h "^&(mut )?str$" --category Rust

(lldb) type summary add -F lldb_lookup.summary_lookup -e -x -h "^&(mut )?\\[.+\\]$" --category Rust

(lldb) type summary add -F lldb_lookup.summary_lookup -e -x -h "^(std::ffi::([a-z_]+::)+)OsString$" --category Rust

(lldb) type summary add -F lldb_lookup.summary_lookup -e -x -h "^(alloc::([a-z_]+::)+)Vec<.+>$" --category Rust

(lldb) type summary add -F lldb_lookup.summary_lookup -e -x -h "^(alloc::([a-z_]+::)+)VecDeque<.+>$" --category Rust

(lldb) type summary add -F lldb_lookup.summary_lookup -e -x -h "^(alloc::([a-z_]+::)+)BTreeSet<.+>$" --category Rust

(lldb) type summary add -F lldb_lookup.summary_lookup -e -x -h "^(alloc::([a-z_]+::)+)BTreeMap<.+>$" --category Rust

(lldb) type summary add -F lldb_lookup.summary_lookup -e -x -h "^(std::collections::([a-z_]+::)+)HashMap<.+>$" --category Rust

(lldb) type summary add -F lldb_lookup.summary_lookup -e -x -h "^(std::collections::([a-z_]+::)+)HashSet<.+>$" --category Rust

(lldb) type summary add -F lldb_lookup.summary_lookup -e -x -h "^(alloc::([a-z_]+::)+)Rc<.+>$" --category Rust

(lldb) type summary add -F lldb_lookup.summary_lookup -e -x -h "^(alloc::([a-z_]+::)+)Arc<.+>$" --category Rust

(lldb) type summary add -F lldb_lookup.summary_lookup -e -x -h "^(core::([a-z_]+::)+)Cell<.+>$" --category Rust

(lldb) type summary add -F lldb_lookup.summary_lookup -e -x -h "^(core::([a-z_]+::)+)Ref<.+>$" --category Rust

(lldb) type summary add -F lldb_lookup.summary_lookup -e -x -h "^(core::([a-z_]+::)+)RefMut<.+>$" --category Rust

(lldb) type summary add -F lldb_lookup.summary_lookup -e -x -h "^(core::([a-z_]+::)+)RefCell<.+>$" --category Rust

(lldb) type category enable Rust

(lldb) target create "../target/debug/examples/closure_size"

Current executable set to '/Users/kuanhsiaokuo/Developer/spare_projects/rust_lab/geektime-rust/geektime_rust_codes/target/debug/examples/closure_size' (x86_64).

(lldb)

(lldb) b closure_size.rs:14

Breakpoint 1: where = closure_size`closure_size::main::h679d75437a0cd078 + 199 at closure_size.rs:14:14, address = 0x00000001000056b7

(lldb) r

Process 95084 launched: '/Users/kuanhsiaokuo/Developer/spare_projects/rust_lab/geektime-rust/geektime_rust_codes/target/debug/examples/closure_size' (x86_64)

Process 95084 stopped

* thread #1, queue = 'com.apple.main-thread', stop reason = breakpoint 1.1

frame #0: 0x00000001000056b7 closure_size`closure_size::main::h679d75437a0cd078 at closure_size.rs:14:14

11 // 如果捕获一个引用,长度为 8

12 let c3 = || println!("hello: {}", name);

13 // 捕获移动的数据 name1(长度 24) + table(长度 48),closure 长度 72

-> 14 let c4 = move || println!("hello: {}, {:?}", name1, table);

15 let name2 = name.clone();

16 // 和局部变量无关,捕获了一个 String name2,closure 长度 24

17 let c5 = move || {

Target 0: (closure_size) stopped.

(lldb) frame variable

(closure_size::main::{closure_env#0}) c1 =

(closure_size::main::{closure_env#1}) c2 =

(alloc::string::String) name = "tyr" {

vec = size=3 {

[0] = 't'

[1] = 'y'

[2] = 'r'

}

}

(alloc::string::String) name1 = "tyr" {

vec = size=3 {

[0] = 't'

[1] = 'y'

[2] = 'r'

}

}

(std::collections::hash::map::HashMap<&str, &str, std::collections::hash::map::RandomState>) table = size=1 {

[0] = {

0 = "hello" {

data_ptr = 0x0000000100043daf "helloworld, c2: , c3: , c4: , c5: \n"

length = 5

}

1 = "world" {

data_ptr = 0x0000000100043db4 "world, c2: , c3: , c4: , c5: \n"

length = 5

}

}

}

(lldb) fr v

(closure_size::main::{closure_env#0}) c1 =

(closure_size::main::{closure_env#1}) c2 =

(alloc::string::String) name = "tyr" {

vec = size=3 {

[0] = 't'

[1] = 'y'

[2] = 'r'

}

}

(alloc::string::String) name1 = "tyr" {

vec = size=3 {

[0] = 't'

[1] = 'y'

[2] = 'r'

}

}

(std::collections::hash::map::HashMap<&str, &str, std::collections::hash::map::RandomState>) table = size=1 {

[0] = {

0 = "hello" {

data_ptr = 0x0000000100043daf "helloworld, c2: , c3: , c4: , c5: \n"

length = 5

}

1 = "world" {

data_ptr = 0x0000000100043db4 "world, c2: , c3: , c4: , c5: \n"

length = 5

}

}

}

(lldb) x/gx c1

error: memory read failed for 0x0

(lldb) x/gx &c1

0x7ff7bfefed20: 0x0000000100266000

(lldb) x/gx &c2

0x7ff7bfefed28: 0x00006000017041c0

(lldb) x/gx &c3

0x7ff7bfefed90: 0x00007ff7bfefed30

(lldb) x/gx 0x00007ff7bfefed30

0x7ff7bfefed30: 0x0000600000008010

(lldb) x/3c 0x0000600000008010

error: reading memory as characters of size 8 is not supported

(lldb) x/gx 0x0000600000008010

0x600000008010: 0x0000000000727974

- g表示八字节。当我们指定了字节长度后,GDB会从指内存定的内存地址开始,读写指定字节,并把其当作一个值取出来。

- 可以看出:c1是

(lldb) n

Process 95084 stopped

* thread #1, queue = 'com.apple.main-thread', stop reason = step over

frame #0: 0x0000000100005744 closure_size`closure_size::main::h679d75437a0cd078 at closure_size.rs:15:17

12 let c3 = || println!("hello: {}", name);

13 // 捕获移动的数据 name1(长度 24) + table(长度 48),closure 长度 72

14 let c4 = move || println!("hello: {}, {:?}", name1, table);

-> 15 let name2 = name.clone();

16 // 和局部变量无关,捕获了一个 String name2,closure 长度 24

17 let c5 = move || {

18 let x = 1;

Target 0: (closure_size) stopped.

(lldb) x/9gx c4

error: memory read failed for 0x0

(lldb) x/9gx &c4

0x7ff7bfefed98: 0x0000600000008020 0x0000000000000003

0x7ff7bfefeda8: 0x0000000000000003 0x3e49f3270a1a0fb0

0x7ff7bfefedb8: 0x79dd9a78e6c327e7 0x0000000000000003

0x7ff7bfefedc8: 0x0000600003304080 0x0000000000000002

0x7ff7bfefedd8: 0x0000000000000001

(lldb) x/3c 0x0000600000008020

error: reading memory as characters of size 8 is not supported

(lldb) x/gx 0x0000600000008020

0x600000008020: 0x0000000000727974

(lldb) x/18gx 0x0000600000008020 - 0x80

error: memory read takes a start address expression with an optional end address expression.

warning: Expressions should be quoted if they contain spaces or other special characters.

(lldb) x/18gx '0x0000600000008020 - 0x80'

0x600000007fa0: 0x0000000000000000 0x0000000000000000

0x600000007fb0: 0x0000000000000000 0x0000000000000000

0x600000007fc0: 0x0000000000000000 0x0000000000000000

0x600000007fd0: 0x0000000000000000 0x0000000000000000

0x600000007fe0: 0x0000000000000000 0x0000000000000000

0x600000007ff0: 0x0000000000000000 0x0000000000000000

0x600000008000: 0x000000006e69616d 0x0000000000000000

0x600000008010: 0x0000000000727974 0x0000000000000000

0x600000008020: 0x0000000000727974 0x0000000000000000

- 0x: C语言里的0x0和0x1分别表示十六进制的数的0和1。

C语言、C++、Shell、Python、Java语言及其他相近的语言使用字首“0x”,例如“0x5A3”。开头的“0”令解析器更易辨认数,而“x”则代表十六进制(就如“O”代表八进制)。在“0x”中的“x”可以大写或小写。对于字符量C语言中则以x+两位十六进制数的方式表示,如xFF。

因此,0x0中“0x”表示的是十六进制数,0是十六进制数值0,0x,1中“0x”表示的是十六进制数,1是十六进制数值1

- C语言中的相关数值表示法:

1、在C语言里,整数有三种表示形式:十进制,八进制,十六进制。其中以数字0开头,由0~7组成的数是八进制。以0X或0x开头,由0~9,A~F或a~f 组成是十六进制。除表示正负的符号外,以1~9开头,由0~9组成是十进制。

2、十进制:除表示正负的符号外,以1~9开头,由0~9组成。如,128,+234,-278。

3、八进制:以0开头,由0~7组成的数。如,0126,050000.

4、十六进制:以0X或0x开头,由0~9,A~F或a~f 组成。如,0x12A,0x5a000。

get hands dirty

httpie源码剖析

example的使用

Cargo.toml

[package]

name = "httpie"

version = "0.1.0"

edition = "2021"

# See more keys and their definitions at https://doc.rust-lang.org/cargo/reference/manifest.html

[[example]]

name = "cli"

[[example]]

name = "cli_verify"

[[example]]

name = "cli_get"

[dependencies]

anyhow = "1" # 错误处理

clap = { version = "3", features = ["derive"] } # 命令行解析

colored = "2" # 命令终端多彩显示

jsonxf = "1.1" # JSON pretty print 格式化

mime = "0.3" # 处理 mime 类型

# reqwest 默认使用 openssl,有些 linux 用户如果没有安装好 openssl 会无法编译,这里我改成了使用 rustls

reqwest = { version = "0.11", default-features = false, features = ["json", "rustls-tls"] } # HTTP 客户端

tokio = { version = "1", features = ["full"] } # 异步处理库

syntect = "4"

[[example]]

name = "cli"

[[example]]

name = "cli_verify"

[[example]]

name = "cli_get"

- 示例代码放在根目录的examples文件夹,与src同级

tree -L 2 ─╯

.

├── Cargo.toml

├── examples

│ ├── cli.rs

│ ├── cli_get.rs

│ └── cli_verify.rs

└── src

└── main.rs

2 directories, 5 files

- 执行指令

cargo run --example <example-name-in-cargo>

cargo run --example cli

cargo run --example cli_get

cargo run --example cli_verify

- 使用示例

cargo run --example cli ─╯

Finished dev [unoptimized + debuginfo] target(s) in 0.70s

Running `/Users/kuanhsiaokuo/Developer/spare_projects/rust_lab/geektime-rust/geektime_rust_codes/target/debug/examples/cli`

httpie 1.0

Tyr Chen <tyr@chen.com>

A naive httpie implementation with Rust, can you imagine how easy it is?

USAGE:

cli <SUBCOMMAND>

OPTIONS:

-h, --help Print help information

-V, --version Print version information

SUBCOMMANDS:

get feed get with an url and we will retrieve the response for you

help Print this message or the help of the given subcommand(s)

post feed post with an url and optional key=value pairs. We will post the data as JSON,

and retrieve the response for you

- Run a binary or example of the local package

- SUBCOMMANDS来自代码中的注释

Step1:指令解析

- 源码

use clap::Parser; // 定义 httpie 的 CLI 的主入口,它包含若干个子命令 // 下面 /// 的注释是文档,clap 会将其作为 CLI 的帮助 /// A naive httpie implementation with Rust, can you imagine how easy it is? #[derive(Parser, Debug)] #[clap(version = "1.0", author = "Tyr Chen <tyr@chen.com>")] struct Opts { #[clap(subcommand)] subcmd: SubCommand, } // 子命令分别对应不同的 HTTP 方法,目前只支持 get / post #[derive(Parser, Debug)] enum SubCommand { Get(Get), Post(Post), // 我们暂且不支持其它 HTTP 方法 } // get 子命令 /// feed get with an url and we will retrieve the response for you #[derive(Parser, Debug)] struct Get { /// HTTP 请求的 URL url: String, } // post 子命令。需要输入一个 url,和若干个可选的 key=value,用于提供 json body /// feed post with an url and optional key=value pairs. We will post the data /// as JSON, and retrieve the response for you #[derive(Parser, Debug)] struct Post { /// HTTP 请求的 URL url: String, /// HTTP 请求的 body body: Vec<String>, } fn main() { let opts: Opts = Opts::parse(); let opt_subcmd: SubCommand = opts.subcmd; // println!("{:?}", opts); println!("{:?}", opt_subcmd); // println!("{:?}", opts.subcmd); // 这里就可以看出,结构体的内在元素使用"."来获取 // println!("{:?}", opts::subcmd); }

clap::Parser相关资料

- clap的parser派生宏会自动实现parse方法来接收指令参数

struct Opts { #[clap(subcommand)] subcmd: SubCommand, } // 子命令分别对应不同的 HTTP 方法,目前只支持 get / post #[derive(Parser, Debug)]

fn main() { let opts: Opts = Opts::parse(); let opt_subcmd: SubCommand = opts.subcmd; // println!("{:?}", opts);

- 运行效果

cargo run --example cli get http://jsonplaceholder.typicode.com/posts/2 ─╯

Compiling httpie v0.1.0 (/Users/kuanhsiaokuo/Developer/spare_projects/rust_lab/geektime-rust/geektime_rust_codes/04_httpie)

Finished dev [unoptimized + debuginfo] target(s) in 2.31s

Running `/Users/kuanhsiaokuo/Developer/spare_projects/rust_lab/geektime-rust/geektime_rust_codes/target/debug/examples/cli get 'http://jsonplaceholder.typicode.com/posts/2'`

Opts { subcmd: Get(Get { url: "http://jsonplaceholder.typicode.com/posts/2" }) }

cargo run --example cli post http://jsonplaceholder.typicode.com/posts/2 ─╯

Finished dev [unoptimized + debuginfo] target(s) in 0.31s

Running `/Users/kuanhsiaokuo/Developer/spare_projects/rust_lab/geektime-rust/geektime_rust_codes/target/debug/examples/cli post 'http://jsonplaceholder.typicode.com/posts/2'`

Opts { subcmd: Post(Post { url: "http://jsonplaceholder.typicode.com/posts/2", body: [] }) }

cargo run --example cli delete http://jsonplaceholder.typicode.com/posts/2 ─╯

Finished dev [unoptimized + debuginfo] target(s) in 0.24s

Running `/Users/kuanhsiaokuo/Developer/spare_projects/rust_lab/geektime-rust/geektime_rust_codes/target/debug/examples/cli delete 'http://jsonplaceholder.typicode.com/posts/2'`

error: Found argument 'delete' which wasn't expected, or isn't valid in this context

USAGE:

cli <SUBCOMMAND>

For more information try --help

- opts的获取:自动以空格分隔,根据

模式匹配,之后的参数依次赋值给 struct里面的元素

Step2:添加参数验证与键值对改造

- 参数验证

/// feed get with an url and we will retrieve the response for you #[derive(Parser, Debug)] struct Get { /// HTTP 请求的 URL #[clap(parse(try_from_str = parse_url))] url: String, } // post 子命令。需要输入一个 url,和若干个可选的 key=value,用于提供 json body /// feed post with an url and optional key=value pairs. We will post the data /// as JSON, and retrieve the response for you #[derive(Parser, Debug)] struct Post { /// HTTP 请求的 URL #[clap(parse(try_from_str = parse_url))] url: String, /// HTTP 请求的 body #[clap(parse(try_from_str=parse_kv_pair))] body: Vec<KvPair>, }

clap 允许你为每个解析出来的值添加自定义的解析函数,我们这里定义了parse_url和parse_kv_pair检查一下。

/// 因为我们为 KvPair 实现了 FromStr,这里可以直接 s.parse() 得到 KvPair fn parse_kv_pair(s: &str) -> Result<KvPair> { s.parse() } fn parse_url(s: &str) -> Result<String> { // 这里我们仅仅检查一下 URL 是否合法 let _url: Url = s.parse()?; Ok(s.into()) }

- 键值对改造

/// 命令行中的 key=value 可以通过 parse_kv_pair 解析成 KvPair 结构 #[allow(dead_code)] #[derive(Debug)] struct KvPair { k: String, v: String, } /// 当我们实现 FromStr trait 后,可以用 str.parse() 方法将字符串解析成 KvPair impl FromStr for KvPair { type Err = anyhow::Error; fn from_str(s: &str) -> Result<Self, Self::Err> { // 使用 = 进行 split,这会得到一个迭代器 let mut split = s.split('='); let err = || anyhow!(format!("Failed to parse {}", s)); Ok(Self { // 从迭代器中取第一个结果作为 key,迭代器返回 Some(T)/None // 我们将其转换成 Ok(T)/Err(E),然后用 ? 处理错误 k: (split.next().ok_or_else(err)?).to_string(), // 从迭代器中取第二个结果作为 value v: (split.next().ok_or_else(err)?).to_string(), }) } }

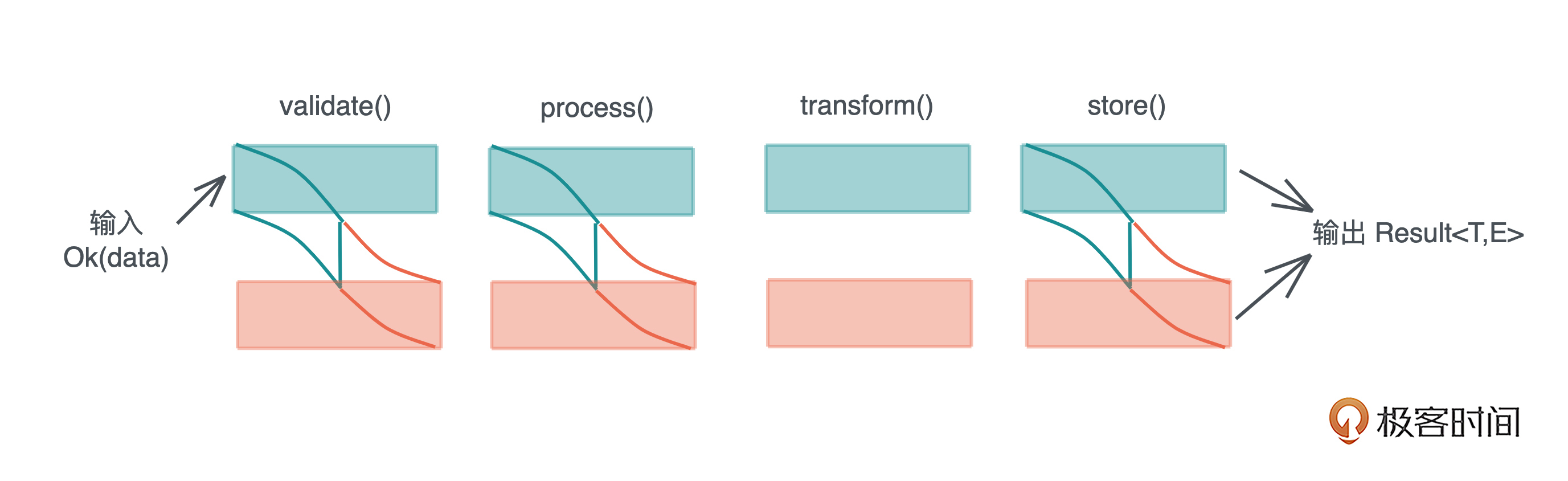

Step3:异步请求改造

Step3:异步请求改造

#[tokio::main] async fn main() -> Result<()> { let opts: Opts = Opts::parse(); // 生成一个 let client = Client::new(); match opts.subcmd { SubCommand::Get(ref args) => get(client, args).await?, SubCommand::Post(ref args) => post(client, args).await?, }; Ok(()) } async fn get(client: Client, args: &Get) -> Result<()> { let resp = client.get(&args.url).send().await?; println!("{:?}", resp.text().await?); Ok(()) } async fn post(client: Client, args: &Post) -> Result<()> { let mut body = HashMap::new(); for pair in args.body.iter() { body.insert(&pair.k, &pair.v); } let resp = client.post(&args.url).json(&body).send().await?; println!("{:?}", resp.text().await?); Ok(()) }

Step4: 语法高亮打印

Step4: 语法高亮打印

// 打印服务器版本号 + 状态码 fn print_status(resp: &Response) { let status = format!("{:?} {}", resp.version(), resp.status()).blue(); println!("{}\n", status); } // 打印服务器返回的 HTTP header fn print_headers(resp: &Response) { for (name, value) in resp.headers() { println!("{}: {:?}", name.to_string().green(), value); } println!(); } /// 打印服务器返回的 HTTP body fn print_body(m: Option<Mime>, body: &str) { match m { // 对于 "application/json" 我们 pretty print Some(v) if v == mime::APPLICATION_JSON => print_syntect(body, "json"), Some(v) if v == mime::TEXT_HTML => print_syntect(body, "html"), // 其它 mime type,我们就直接输出 _ => println!("{}", body), } } /// 打印整个响应 async fn print_resp(resp: Response) -> Result<()> { print_status(&resp); print_headers(&resp); let mime = get_content_type(&resp); let body = resp.text().await?; print_body(mime, &body); Ok(()) } /// 将服务器返回的 content-type 解析成 Mime 类型 fn get_content_type(resp: &Response) -> Option<Mime> { resp.headers() .get(header::CONTENT_TYPE) .map(|v| v.to_str().unwrap().parse().unwrap()) } fn print_syntect(s: &str, ext: &str) { // Load these once at the start of your program let ps = SyntaxSet::load_defaults_newlines(); let ts = ThemeSet::load_defaults(); let syntax = ps.find_syntax_by_extension(ext).unwrap(); let mut h = HighlightLines::new(syntax, &ts.themes["base16-ocean.dark"]); for line in LinesWithEndings::from(s) { let ranges: Vec<(Style, &str)> = h.highlight(line, &ps); let escaped = as_24_bit_terminal_escaped(&ranges[..], true); print!("{}", escaped); } }

/// 程序的入口函数,因为在 http 请求时我们使用了异步处理,所以这里引入 tokio #[tokio::main] async fn main() -> Result<()> { let opts: Opts = Opts::parse(); let mut headers = header::HeaderMap::new(); // 为我们的 http 客户端添加一些缺省的 HTTP 头 headers.insert("X-POWERED-BY", "Rust".parse()?); headers.insert(header::USER_AGENT, "Rust Httpie".parse()?); let client = Client::builder() .default_headers(headers) .build()?; let result = match opts.subcmd { SubCommand::Get(ref args) => get(client, args).await?, SubCommand::Post(ref args) => post(client, args).await?, }; Ok(result) }

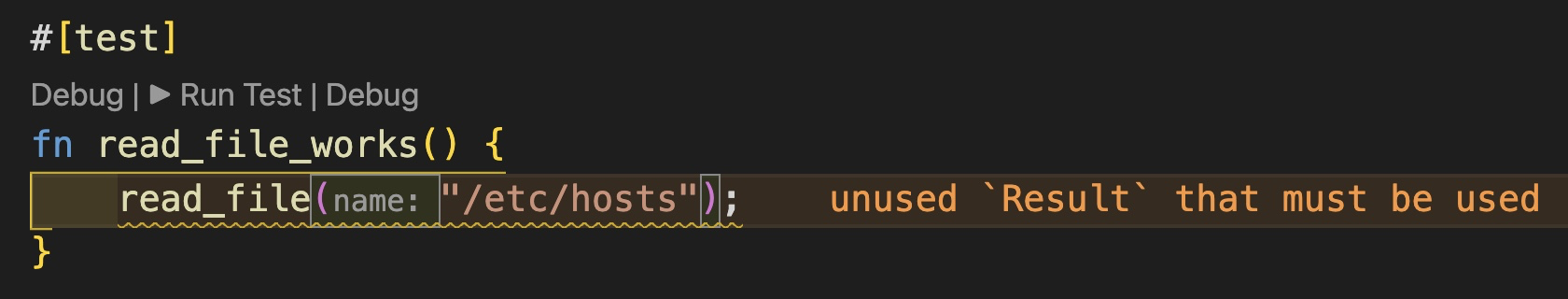

Step5: 添加单元测试

Step5: 添加单元测试

// 仅在 cargo test 时才编译 #[cfg(test)] mod tests { use super::*; #[test] fn parse_url_works() { assert!(parse_url("abc").is_err()); assert!(parse_url("http://abc.xyz").is_ok()); assert!(parse_url("https://httpbin.org/post").is_ok()); } #[test] fn parse_kv_pair_works() { assert!(parse_kv_pair("a").is_err()); assert_eq!( parse_kv_pair("a=1").unwrap(), KvPair { k: "a".into(), v: "1".into(), } ); assert_eq!( parse_kv_pair("b=").unwrap(), KvPair { k: "b".into(), v: "".into(), } ); } }

rgrep

Cargo.toml

Cargo.toml

[package]

name = "rgrep"

version = "0.1.0"

edition = "2021"

# See more keys and their definitions at https://doc.rust-lang.org/cargo/reference/manifest.html

[dependencies]

anyhow = "1"

clap = { version = "3", features = ["derive"] }

colored = "2"

glob = "0.3"

itertools = "0.10"

rayon = "1"

regex = "1"

thiserror = "1"

src/error.rs: thiserror会自动转换

它们都是需要进行转换的错误。thiserror 能够通过宏帮我们完成错误类型的转换。

它们都是需要进行转换的错误。thiserror 能够通过宏帮我们完成错误类型的转换。

use thiserror::Error; #[derive(Error, Debug)] pub enum GrepError { #[error("Glob pattern error")] GlobPatternError(#[from] glob::PatternError), #[error("Regex pattern error")] RegexPatternError(#[from] regex::Error), #[error("I/O error")] IoError(#[from] std::io::Error), }

src/lib.rs:定义结构体+实现方法+单元测试

定义结构体: 专门简化复杂类型

这里其实就是传入一个指定结构的函数对象

/// 定义类型,这样,在使用时可以简化复杂类型的书写 pub type StrategyFn = fn(&Path, &mut dyn BufRead, &Regex, &mut dyn Write) -> Result<(), GrepError>;

专门的结合版本grep结构体

/// 简化版本的 grep,支持正则表达式和文件通配符 #[derive(Parser, Debug)] #[clap(version = "1.0", author = "Tyr Chen <tyr@chen.com>")] pub struct GrepConfig { /// 用于查找的正则表达式 pattern: String, /// 文件通配符 glob: String, }

lib.rs: 给结构体实现方法

impl GrepConfig { /// 使用缺省策略来查找匹配 pub fn match_with_default_strategy(&self) -> Result<(), GrepError> { self.match_with(default_strategy) } /// 使用某个策略函数来查找匹配 pub fn match_with(&self, strategy: StrategyFn) -> Result<(), GrepError> { let regex = Regex::new(&self.pattern)?; // 生成所有符合通配符的文件列表 let files: Vec<_> = glob::glob(&self.glob)?.collect(); // 并行处理所有文件 files.into_par_iter().for_each(|v| { if let Ok(filename) = v { if let Ok(file) = File::open(&filename) { let mut reader = BufReader::new(file); let mut stdout = io::stdout(); if let Err(e) = strategy(filename.as_path(), &mut reader, ®ex, &mut stdout) { println!("Internal error: {:?}", e); } } } }); Ok(()) } }

主要实现两种解析策略:

- 默认策略:match_with_default_strategy, 使用default_strategy

- 指定策略:match_with, 使用传入的strategy: StrategyFn

默认策略: default_strategy

/// 缺省策略,从头到尾串行查找,最后输出到 writer pub fn default_strategy( path: &Path, reader: &mut dyn BufRead, pattern: &Regex, writer: &mut dyn Write, ) -> Result<(), GrepError> { let matches: String = reader .lines() .enumerate() .map(|(lineno, line)| { line.ok() .map(|line| { pattern .find(&line) .map(|m| format_line(&line, lineno + 1, m.range())) }) .flatten() }) .filter_map(|v| v.ok_or(()).ok()) .join("\n"); if !matches.is_empty() { writer.write_all(path.display().to_string().green().as_bytes())?; writer.write_all(b"\n")?; writer.write_all(matches.as_bytes())?; writer.write_all(b"\n")?; } Ok(()) }

格式化输出

/// 格式化输出匹配的行,包含行号,列号和带有高亮的第一个匹配项 pub fn format_line(line: &str, lineno: usize, range: Range<usize>) -> String { let Range { start, end } = range; let prefix = &line[..start]; format!( "{0: >6}:{1: <3} {2}{3}{4}", lineno.to_string().blue(), // 找到匹配项的起始位置,注意对汉字等非 ascii 字符,我们不能使用 prefix.len() // 这是一个 O(n) 的操作,会拖累效率,这里只是为了演示的效果 (prefix.chars().count() + 1).to_string().cyan(), prefix, &line[start..end].red(), &line[end..] ) }

单元测试

#[cfg(test)] mod tests { use super::*; #[test] fn format_line_should_work() { let result = format_line("Hello, Tyr~", 1000, 7..10); let expected = format!( "{0: >6}:{1: <3} Hello, {2}~", "1000".blue(), "8".cyan(), "Tyr".red() ); assert_eq!(result, expected); } #[test] fn default_strategy_should_work() { let path = Path::new("src/main.rs"); let input = b"hello world!\nhey Tyr!"; let mut reader = BufReader::new(&input[..]); let pattern = Regex::new(r"he\w+").unwrap(); let mut writer = Vec::new(); default_strategy(path, &mut reader, &pattern, &mut writer).unwrap(); let result = String::from_utf8(writer).unwrap(); let expected = [ String::from("src/main.rs"), format_line("hello world!", 1, 0..5), format_line("hey Tyr!\n", 2, 0..3), ]; assert_eq!(result, expected.join("\n")); } }

src/main.rs

主函数:main()

use regex::Regex; use std::{ fs::File, io::{self, BufRead, BufReader, Write}, ops::Range, path::Path, };

使用

示例:cargo run –quiet – “正则表达式” “src/*.rs”

cargo run --quiet -- "Re[^\\s]+" "src/*.rs" ─╯

src/main.rs

1:13 use anyhow::Result;

5:14 fn main() -> Result<()> {

src/error.rs

7:14 #[error("Regex pattern error")]

8:5 RegexPatternError(#[from] regex::Error),

src/lib.rs

5:12 use regex::Regex;

8:19 io::{self, BufRead, BufReader, Write},

17:45 pub type StrategyFn = fn(&Path, &mut dyn BufRead, &Regex, &mut dyn Write) -> Result<(), GrepError>;

31:50 pub fn match_with_default_strategy(&self) -> Result<(), GrepError> {

36:55 pub fn match_with(&self, strategy: StrategyFn) -> Result<(), GrepError> {

37:21 let regex = Regex::new(&self.pattern)?;

44:41 let mut reader = BufReader::new(file);

60:25 reader: &mut dyn BufRead,

61:15 pattern: &Regex,

63:6 ) -> Result<(), GrepError> {

126:29 let mut reader = BufReader::new(&input[..]);

127:23 let pattern = Regex::new(r"he\w+").unwrap();

thumbor图片服务

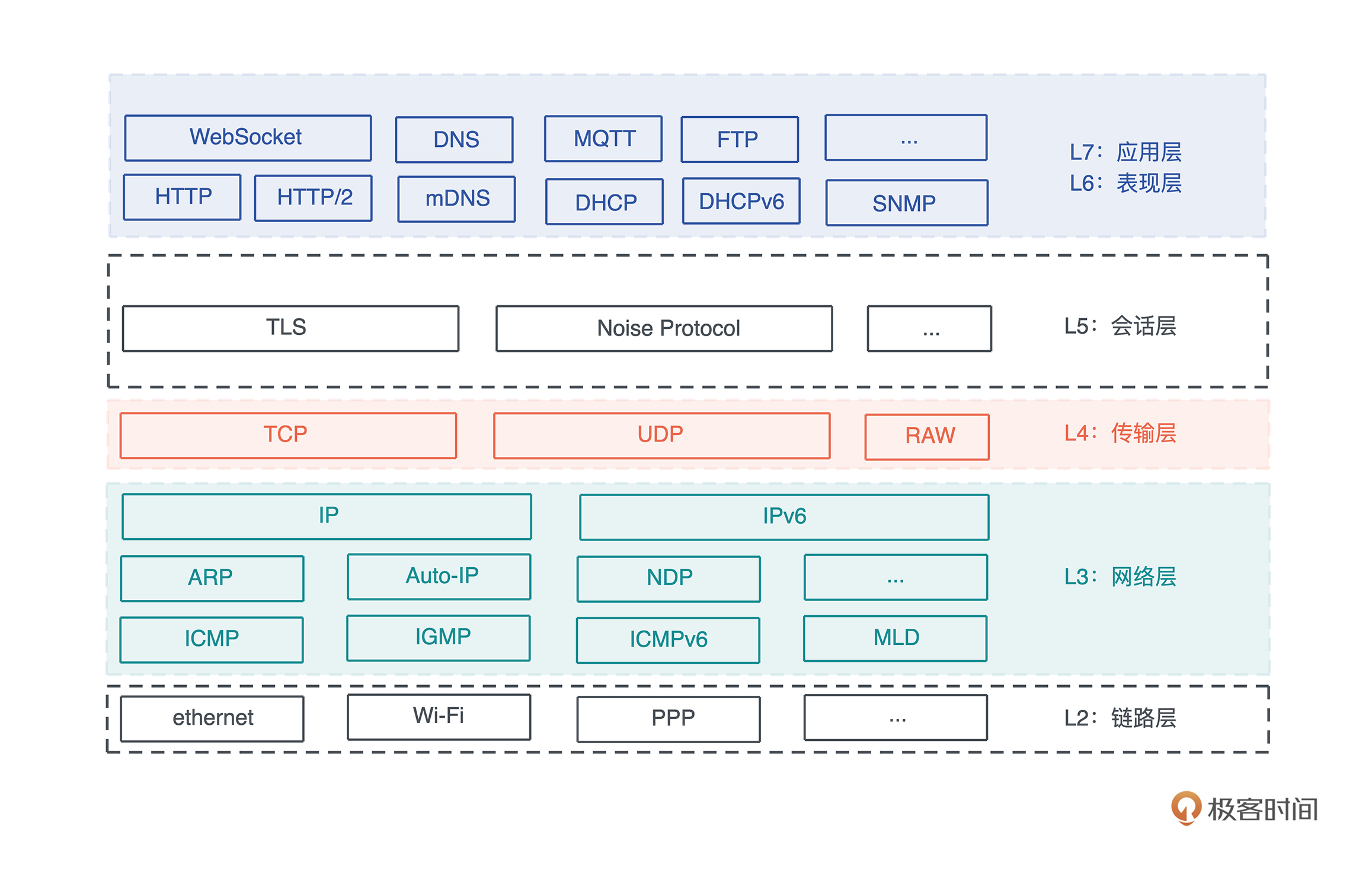

protobuf相关处理

abi.proto

syntax = "proto3"; package abi; // 一个 ImageSpec 是一个有序的数组,服务器按照 spec 的顺序处理 message ImageSpec { repeated Spec specs = 1; } // 处理图片改变大小 message Resize { uint32 width = 1; uint32 height = 2; enum ResizeType { NORMAL = 0; SEAM_CARVE = 1; } ResizeType rtype = 3; enum SampleFilter { UNDEFINED = 0; NEAREST = 1; TRIANGLE = 2; CATMULL_ROM = 3; GAUSSIAN = 4; LANCZOS3 = 5; } SampleFilter filter = 4; } // 处理图片截取 message Crop { uint32 x1 = 1; uint32 y1 = 2; uint32 x2 = 3; uint32 y2 = 4; } // 处理水平翻转 message Fliph {} // 处理垂直翻转 message Flipv {} // 处理对比度 message Contrast { float contrast = 1; } // 处理滤镜 message Filter { enum Filter { UNSPECIFIED = 0; OCEANIC = 1; ISLANDS = 2; MARINE = 3; // more: https://docs.rs/photon-rs/0.3.1/photon_rs/filters/fn.filter.html } Filter filter = 1; } // 处理水印 message Watermark { uint32 x = 1; uint32 y = 2; } // 一个 spec 可以包含上述的处理方式之一 message Spec { oneof data { Resize resize = 1; Crop crop = 2; Flipv flipv = 3; Fliph fliph = 4; Contrast contrast = 5; Filter filter = 6; Watermark watermark = 7; } }

build.rs

use std::process::Command; fn main() { // 在编译时可选择检查环境变量。 let build_enabled = option_env!("BUILD_PROTO") .map(|v| v == "1") .unwrap_or(false); // 如果没有找到环境变量的对应值,就直接return,不再进行后续编译 if !build_enabled { println!("=== Skipped compiling protos ==="); return; } // 使用 prost_build 把 abi.proto 编译到 src/pb 目录下 prost_build::Config::new() .out_dir("src/pb") .compile_protos(&["abi.proto"], &["."]) .unwrap(); Command::new("cargo") .args(&["fmt", "--", "src/*.rs"]) .status() .expect("cargo fmt failed"); }

在编译时可选择检查环境变量。

关于rust的模块

可以参考这篇:Rust 模块系统理解 - 知乎

mod全认识

- mod(mod.rs或mod关键字)将代码分为多个逻辑模块,并管理这些模块的可见性(public / private)。

- 模块是项(item)的集合,项可以是:函数,结构体,trait,impl块,甚至其它模块。

- 一个目录下的所有代码,可以通过 mod.rs 声明

- Rust模块有三种形式:

- mod.rs: 一个目录下的所有代码,可以通过 mod.rs 声明

- 文件/目录即模块:编译器的机制决定,除了mod.rs外,每一个文件和目录都是一个模块。不允许只分拆文件,但是不声明mod,我们通常使用pub use,在父空间直接调用子空间的函数。

- mod关键字: 在文件内部分拆模块

- Rust编译器只接受一个源文件,输出一个crate

- 每一个crate都有一个匿名的根命名空间,命名空间可以无限嵌套

- “mod mod-name { … }“ 将大括号中的代码置于命名空间mod-name之下

- “use mod-name1::mod-name2;“ 可以打开命名空间,减少无休止的::操作符

- “mod mod-name;“ 可以指导编译器将多个文件组装成一个文件

- “pub use mod-nam1::mod-name2::item-name;“ 语句可以将mod-name2下的item-name提升到这条语句所在的空间,item-name通常是函数或者结构体。Rust社区通常用这个方法来缩短库API的命名空间深度 编译器规定use语句一定要在mod语句之前

mod文件定义与实现分离

在rust中,一般会在模块的mod.rs文件中对供外部使用的项进行实现, 项可以是:函数,结构体,trait,impl块,甚至其它模块. 这样有个好处,高内聚,可以在代码增长时,将变动局限在服务提供者内部,对外提供的api不变,不会造成破坏性更新。

pb模块: 处理protobuf

pb/abi.rs里面还有子模块

/// Nested message and enum types in `Spec`. pub mod spec { #[derive(Clone, PartialEq, ::prost::Oneof)] pub enum Data { #[prost(message, tag = "1")] Resize(super::Resize), #[prost(message, tag = "2")] Crop(super::Crop), #[prost(message, tag = "3")] Flipv(super::Flipv), #[prost(message, tag = "4")] Fliph(super::Fliph), #[prost(message, tag = "5")] Contrast(super::Contrast), #[prost(message, tag = "6")] Filter(super::Filter), #[prost(message, tag = "7")] Watermark(super::Watermark), } }

pb/abi.rs另外定义了spec::Data里面的各个元素结构体/嵌套模块mod

/// 一个 ImageSpec 是一个有序的数组,服务器按照 spec 的顺序处理 #[derive(Clone, PartialEq, ::prost::Message)] pub struct ImageSpec { #[prost(message, repeated, tag = "1")] pub specs: ::prost::alloc::vec::Vec<Spec>, } /// 处理图片改变大小 #[derive(Clone, PartialEq, ::prost::Message)] pub struct Resize { #[prost(uint32, tag = "1")] pub width: u32, #[prost(uint32, tag = "2")] pub height: u32, #[prost(enumeration = "resize::ResizeType", tag = "3")] pub rtype: i32, #[prost(enumeration = "resize::SampleFilter", tag = "4")] pub filter: i32, } /// Nested message and enum types in `Resize`. pub mod resize { #[derive(Clone, Copy, Debug, PartialEq, Eq, Hash, PartialOrd, Ord, ::prost::Enumeration)] #[repr(i32)] pub enum ResizeType { Normal = 0, SeamCarve = 1, } #[derive(Clone, Copy, Debug, PartialEq, Eq, Hash, PartialOrd, Ord, ::prost::Enumeration)] #[repr(i32)] pub enum SampleFilter { Undefined = 0, Nearest = 1, Triangle = 2, CatmullRom = 3, Gaussian = 4, Lanczos3 = 5, } } /// 处理图片截取 #[derive(Clone, PartialEq, ::prost::Message)] pub struct Crop { #[prost(uint32, tag = "1")] pub x1: u32, #[prost(uint32, tag = "2")] pub y1: u32, #[prost(uint32, tag = "3")] pub x2: u32, #[prost(uint32, tag = "4")] pub y2: u32, } /// 处理水平翻转 #[derive(Clone, PartialEq, ::prost::Message)] pub struct Fliph {} /// 处理垂直翻转 #[derive(Clone, PartialEq, ::prost::Message)] pub struct Flipv {} /// 处理对比度 #[derive(Clone, PartialEq, ::prost::Message)] pub struct Contrast { #[prost(float, tag = "1")] pub contrast: f32, } /// 处理滤镜 #[derive(Clone, PartialEq, ::prost::Message)] pub struct Filter { #[prost(enumeration = "filter::Filter", tag = "1")] pub filter: i32, } /// Nested message and enum types in `Filter`. pub mod filter { #[derive(Clone, Copy, Debug, PartialEq, Eq, Hash, PartialOrd, Ord, ::prost::Enumeration)] #[repr(i32)] pub enum Filter { Unspecified = 0, Oceanic = 1, Islands = 2, /// more: <https://docs.rs/photon-rs/0.3.1/photon_rs/filters/fn.filter.html> Marine = 3, } } /// 处理水印 #[derive(Clone, PartialEq, ::prost::Message)] pub struct Watermark { #[prost(uint32, tag = "1")] pub x: u32, #[prost(uint32, tag = "2")] pub y: u32, }

pb/abi.rs有个特殊结构体

/// 一个 spec 可以包含上述的处理方式之一 #[derive(Clone, PartialEq, ::prost::Message)] pub struct Spec { #[prost(oneof = "spec::Data", tags = "1, 2, 3, 4, 5, 6, 7")] pub data: ::core::option::Option<spec::Data>, }

ImageSpec

定义:有序数组

- pb/abi.rs

/// 一个 ImageSpec 是一个有序的数组,服务器按照 spec 的顺序处理 #[derive(Clone, PartialEq, ::prost::Message)] pub struct ImageSpec { #[prost(message, repeated, tag = "1")] pub specs: ::prost::alloc::vec::Vec<Spec>, }

实现:new方法、From&TryFrom实现类型转化

- pb/mod.rs

impl ImageSpec { pub fn new(specs: Vec<Spec>) -> Self { Self { specs } } } // 让 ImageSpec 可以生成一个字符串 impl From<&ImageSpec> for String { fn from(image_spec: &ImageSpec) -> Self { let data = image_spec.encode_to_vec(); encode_config(data, URL_SAFE_NO_PAD) } } // 让 ImageSpec 可以通过一个字符串创建。比如 s.parse().unwrap() impl TryFrom<&str> for ImageSpec { type Error = anyhow::Error; fn try_from(value: &str) -> Result<Self, Self::Error> { let data = decode_config(value, URL_SAFE_NO_PAD)?; Ok(ImageSpec::decode(&data[..])?) } }

Filter

定义:枚举体mod

- pb/abi.rs

/// Nested message and enum types in `Filter`. pub mod filter { #[derive(Clone, Copy, Debug, PartialEq, Eq, Hash, PartialOrd, Ord, ::prost::Enumeration)] #[repr(i32)] pub enum Filter { Unspecified = 0, Oceanic = 1, Islands = 2, /// more: <https://docs.rs/photon-rs/0.3.1/photon_rs/filters/fn.filter.html> Marine = 3, } }

实现:双引号的使用、模式匹配

- pb/mod.rs

// 辅助函数,photon_rs 相应的方法里需要字符串 impl filter::Filter { pub fn to_str(self) -> Option<&'static str> { match self { filter::Filter::Unspecified => None, filter::Filter::Oceanic => Some("oceanic"), filter::Filter::Islands => Some("islands"), filter::Filter::Marine => Some("marine"), } } }

SampleFilter

定义:枚举体mod

- pb/abi.rs

/// Nested message and enum types in `Resize`. pub mod resize { #[derive(Clone, Copy, Debug, PartialEq, Eq, Hash, PartialOrd, Ord, ::prost::Enumeration)] #[repr(i32)] pub enum ResizeType { Normal = 0, SeamCarve = 1, } #[derive(Clone, Copy, Debug, PartialEq, Eq, Hash, PartialOrd, Ord, ::prost::Enumeration)] #[repr(i32)] pub enum SampleFilter { Undefined = 0, Nearest = 1, Triangle = 2, CatmullRom = 3, Gaussian = 4, Lanczos3 = 5, } }

实现:mod使用双引号、From转为不同结果

- pb/mod.rs

impl From<resize::SampleFilter> for SamplingFilter { fn from(v: resize::SampleFilter) -> Self { match v { resize::SampleFilter::Undefined => SamplingFilter::Nearest, resize::SampleFilter::Nearest => SamplingFilter::Nearest, resize::SampleFilter::Triangle => SamplingFilter::Triangle, resize::SampleFilter::CatmullRom => SamplingFilter::CatmullRom, resize::SampleFilter::Gaussian => SamplingFilter::Gaussian, resize::SampleFilter::Lanczos3 => SamplingFilter::Lanczos3, } } }

Spec

定义:结构体

- pb/abi.rs

/// 一个 spec 可以包含上述的处理方式之一 #[derive(Clone, PartialEq, ::prost::Message)] pub struct Spec { #[prost(oneof = "spec::Data", tags = "1, 2, 3, 4, 5, 6, 7")] pub data: ::core::option::Option<spec::Data>, }

注意区别Self和self的使用:

注意区别Self和self的使用:

实现:类似面向对象中添加类方法Self

- pb/mod.rs

// 提供一些辅助函数,让创建一个 spec 的过程简单一些 impl Spec { pub fn new_resize_seam_carve(width: u32, height: u32) -> Self { Self { data: Some(spec::Data::Resize(Resize { width, height, rtype: resize::ResizeType::SeamCarve as i32, filter: resize::SampleFilter::Undefined as i32, })), } } pub fn new_resize(width: u32, height: u32, filter: resize::SampleFilter) -> Self { Self { data: Some(spec::Data::Resize(Resize { width, height, rtype: resize::ResizeType::Normal as i32, filter: filter as i32, })), } } pub fn new_filter(filter: filter::Filter) -> Self { Self { data: Some(spec::Data::Filter(Filter { filter: filter as i32, })), } } pub fn new_watermark(x: u32, y: u32) -> Self { Self { data: Some(spec::Data::Watermark(Watermark { x, y })), } } }

单元测试

单元测试

#[cfg(test)] mod tests { use super::*; use std::borrow::Borrow; #[test] fn encoded_spec_could_be_decoded() { let spec1 = Spec::new_resize(600, 600, resize::SampleFilter::CatmullRom); let spec2 = Spec::new_filter(filter::Filter::Marine); let image_spec = ImageSpec::new(vec![spec1, spec2]); let s: String = image_spec.borrow().into(); assert_eq!(image_spec, s.as_str().try_into().unwrap()); } }

engine模块: 处理图片

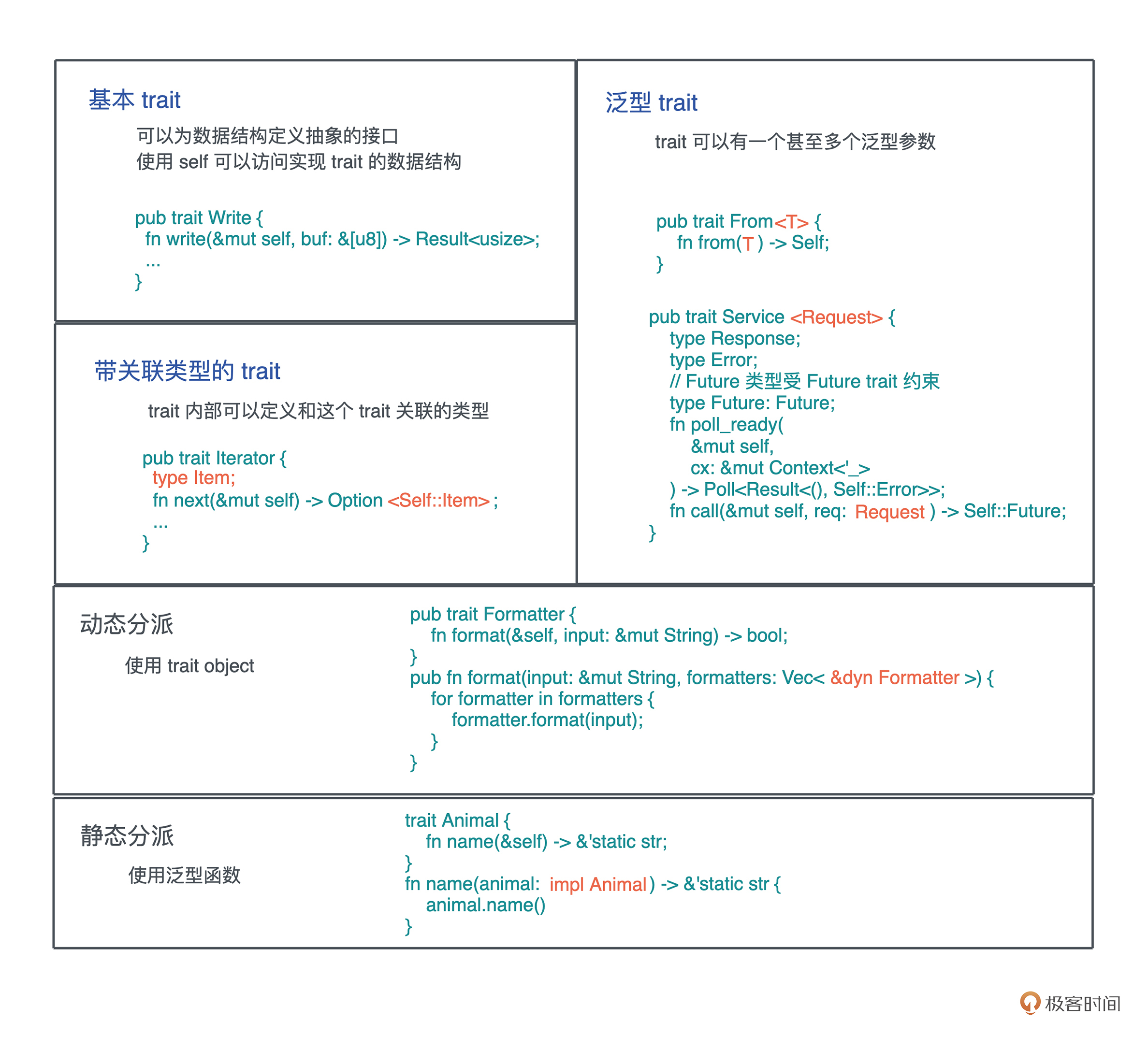

mod.rs: 定义统一的引擎trait

// Engine trait:未来可以添加更多的 engine,主流程只需要替换 engine pub trait Engine { // 对 engine 按照 specs 进行一系列有序的处理 fn apply(&mut self, specs: &[Spec]); // 从 engine 中生成目标图片,注意这里用的是 self,而非 self 的引用 fn generate(self, format: ImageOutputFormat) -> Vec<u8>; } // SpecTransform:未来如果添加更多的 spec,只需要实现它即可 pub trait SpecTransform<T> { // 对图片使用 op 做 transform fn transform(&mut self, op: T); }

photon.rs > 静态变量加载

lazy_static! { // 预先把水印文件加载为静态变量 static ref WATERMARK: PhotonImage = { let data = include_bytes!("../../rust-logo.png"); let watermark = open_image_from_bytes(data).unwrap(); transform::resize(&watermark, 64, 64, transform::SamplingFilter::Nearest) }; }

photon.rs > 具体引擎Photon的定义与转化TryFrom

pub struct Photon(PhotonImage); // 从 Bytes 转换成 Photon 结构 impl TryFrom<Bytes> for Photon { type Error = anyhow::Error; fn try_from(data: Bytes) -> Result<Self, Self::Error> { Ok(Self(open_image_from_bytes(&data)?)) } }

photon.rs > 具体引擎Photon的trait实现

Engine Trait

impl Engine for Photon { fn apply(&mut self, specs: &[Spec]) { for spec in specs.iter() { match spec.data { Some(spec::Data::Crop(ref v)) => self.transform(v), Some(spec::Data::Contrast(ref v)) => self.transform(v), Some(spec::Data::Filter(ref v)) => self.transform(v), Some(spec::Data::Fliph(ref v)) => self.transform(v), Some(spec::Data::Flipv(ref v)) => self.transform(v), Some(spec::Data::Resize(ref v)) => self.transform(v), Some(spec::Data::Watermark(ref v)) => self.transform(v), // 对于目前不认识的 spec,不做任何处理 _ => {} } } }

SpecTransform Trait

格式语义化

#![allow(unused)] fn main() { impl SpecTransform(&OpreationName) for SpecificEngine { fn transform(&mut self, _op: &OperationName) { transform::OperationMethod(&mut self.0) } } }

impl SpecTransform<&Crop> for Photon { fn transform(&mut self, op: &Crop) { let img = transform::crop(&mut self.0, op.x1, op.y1, op.x2, op.y2); self.0 = img; } } impl SpecTransform<&Contrast> for Photon { fn transform(&mut self, op: &Contrast) { effects::adjust_contrast(&mut self.0, op.contrast); } } impl SpecTransform<&Flipv> for Photon { fn transform(&mut self, _op: &Flipv) { transform::flipv(&mut self.0) } } impl SpecTransform<&Fliph> for Photon { fn transform(&mut self, _op: &Fliph) { transform::fliph(&mut self.0) } } impl SpecTransform<&Filter> for Photon { fn transform(&mut self, op: &Filter) { match filter::Filter::from_i32(op.filter) { Some(filter::Filter::Unspecified) => {} Some(f) => filters::filter(&mut self.0, f.to_str().unwrap()), _ => {} } } } impl SpecTransform<&Resize> for Photon { fn transform(&mut self, op: &Resize) { let img = match resize::ResizeType::from_i32(op.rtype).unwrap() { resize::ResizeType::Normal => transform::resize( &self.0, op.width, op.height, resize::SampleFilter::from_i32(op.filter).unwrap().into(), ), resize::ResizeType::SeamCarve => transform::seam_carve(&self.0, op.width, op.height), }; self.0 = img; } } impl SpecTransform<&Watermark> for Photon { fn transform(&mut self, op: &Watermark) { multiple::watermark(&mut self.0, &WATERMARK, op.x, op.y); } }

photon.rs > 在内存中对图片转换格式的方法

fn image_to_buf(img: PhotonImage, format: ImageOutputFormat) -> Vec<u8> { let raw_pixels = img.get_raw_pixels(); let width = img.get_width(); let height = img.get_height(); let img_buffer = ImageBuffer::from_vec(width, height, raw_pixels).unwrap(); let dynimage = DynamicImage::ImageRgba8(img_buffer); let mut buffer = Vec::with_capacity(32768); dynimage.write_to(&mut buffer, format).unwrap(); buffer }

main.rs

先引入mod,再use

// 参数使用 serde 做 Deserialize,axum 会自动识别并解析 #[derive(Deserialize)] struct Params { spec: String, url: String, }

主流程main函数

main()

#[tokio::main] async fn main() { // 初始化 tracing tracing_subscriber::fmt::init(); let cache: Cache = Arc::new(Mutex::new(LruCache::new(1024))); // 构建路由 let app = Router::new() // `GET /` 会执行 .route("/image/:spec/:url", get(generate)) .layer( ServiceBuilder::new() .load_shed() .concurrency_limit(1024) .timeout(Duration::from_secs(10)) .layer(TraceLayer::new_for_http()) .layer(AddExtensionLayer::new(cache)) .layer(CompressionLayer::new()) .into_inner(), ); // 运行 web 服务器 let addr = "127.0.0.1:3000".parse().unwrap(); print_test_url("https://images.pexels.com/photos/1562477/pexels-photo-1562477.jpeg?auto=compress&cs=tinysrgb&dpr=3&h=750&w=1260"); info!("Listening on {}", addr); axum::Server::bind(&addr) .serve(app.into_make_service()) .await .unwrap(); }

建造者模式

ServiceBuilder::new() .load_shed() .concurrency_limit(1024) .timeout(Duration::from_secs(10)) .layer(TraceLayer::new_for_http()) .layer(AddExtensionLayer::new(cache)) .layer(CompressionLayer::new()) .into_inner(),

笔记:类型转换总结

- 数字与字符串

- String 与 & str

- 智能指针

路由绑定的处理函数handler

// basic handler that responds with a static string async fn generate( Path(Params { spec, url }): Path<Params>, Extension(cache): Extension<Cache>, ) -> Result<(HeaderMap, Vec<u8>), StatusCode> { let spec: ImageSpec = spec .as_str() .try_into() .map_err(|_| StatusCode::BAD_REQUEST)?; let url: &str = &percent_decode_str(&url).decode_utf8_lossy(); let data = retrieve_image(url, cache) .await .map_err(|_| StatusCode::BAD_REQUEST)?; // 使用 image engine 处理 let mut engine: Photon = data .try_into() .map_err(|_| StatusCode::INTERNAL_SERVER_ERROR)?; engine.apply(&spec.specs); // TODO: 这里目前类型写死了,应该使用 content negotiation let image = engine.generate(ImageOutputFormat::Jpeg(85)); info!("Finished processing: image size {}", image.len()); let mut headers = HeaderMap::new(); headers.insert("content-type", HeaderValue::from_static("image/jpeg")); Ok((headers, image)) }

处理函数用到的图片获取方法

对于图片的网络请求,我们先把 URL 做个哈希,在 LRU 缓存中查找,找不到才用 reqwest 发送请求。

#[instrument(level = "info", skip(cache))] async fn retrieve_image(url: &str, cache: Cache) -> Result<Bytes> { let mut hasher = DefaultHasher::new(); url.hash(&mut hasher); let key = hasher.finish(); let g = &mut cache.lock().await; let data = match g.get(&key) { Some(v) => { info!("Match cache {}", key); v.to_owned() } None => { info!("Retrieve url"); let resp = reqwest::get(url).await?; let data = resp.bytes().await?; g.put(key, data.clone()); data } }; Ok(data) }

一个用于调试的辅助函数

// 调试辅助函数 fn print_test_url(url: &str) { use std::borrow::Borrow; let spec1 = Spec::new_resize(500, 800, resize::SampleFilter::CatmullRom); let spec2 = Spec::new_watermark(20, 20); let spec3 = Spec::new_filter(filter::Filter::Marine); let image_spec = ImageSpec::new(vec![spec1, spec2, spec3]); let s: String = image_spec.borrow().into(); let test_image = percent_encode(url.as_bytes(), NON_ALPHANUMERIC).to_string(); println!("test url: http://localhost:3000/image/{}/{}", s, test_image); }

运行与日志

SQL查询工具

workspace: 这里使用虚拟清单(virtual manifest)方式

虚拟清单

若一个 Cargo.toml 有 [workspace] 但是没有 [package] 部分,则它是虚拟清单类型的工作空间。

对于没有主 package 的场景或你希望将所有的 package 组织在单独的目录中时,这种方式就非常适合。

workspace关键点

- 所有的 package 共享同一个 Cargo.lock 文件,该文件位于工作空间的根目录中

- 所有的 package 共享同一个输出目录,该目录默认的名称是 target ,位于工作空间根目录下

- 只有工作空间根目录的 Cargo.toml 才能包含 [patch], [replace] 和 [profile.*],而成员的 Cargo.toml 中的相应部分将被自动忽略

workspace使用方式

cargo run -p <member package>

cargo build -p queryer

使用说明

-

在工作空间中,package 相关的 Cargo 命令(例如 cargo build )可以使用 -p 、 –package 或 –workspace 命令行参数来指定想要操作的 package。

-

若没有指定任何参数,则 Cargo 将使用当前工作目录的中的 package 。若工作目录是虚拟清单类型的工作空间,则该命令将作用在所有成员上(就好像是使用了 –workspace 命令行参数)。而 default-members 可以在命令行参数没有被提供时,手动指定操作的成员

queryer package

cargo.toml

两个使用示例

- dialect.rs:SQL解析

use sqlparser::{dialect::GenericDialect, parser::Parser}; fn main() { tracing_subscriber::fmt::init(); let sql = "SELECT a a1, b, 123, myfunc(b), * \ FROM data_source \ WHERE a > b AND b < 100 AND c BETWEEN 10 AND 20 \ ORDER BY a DESC, b \ LIMIT 50 OFFSET 10"; let ast = Parser::parse_sql(&GenericDialect::default(), sql); println!("{:#?}", ast); }

- covid.rs: AST转换

use anyhow::Result; use queryer::query; #[tokio::main] async fn main() -> Result<()> { tracing_subscriber::fmt::init(); let url = "https://raw.githubusercontent.com/owid/covid-19-data/master/public/data/latest/owid-covid-latest.csv"; // 使用 sql 从 URL 里获取数据 let sql = format!( "SELECT location name, total_cases, new_cases, total_deaths, new_deaths \ FROM {} where new_deaths >= 500 ORDER BY new_cases DESC", url ); let df1 = query(sql).await?; println!("{:?}", df1); Ok(()) }

src/convert.rs

结构体定义:sql与对应部分结构体, 注意限于孤儿原则的再包装

/// 解析出来的 SQL pub struct Sql<'a> { pub(crate) selection: Vec<Expr>, pub(crate) condition: Option<Expr>, pub(crate) source: &'a str, pub(crate) order_by: Vec<(String, bool)>, pub(crate) offset: Option<i64>, pub(crate) limit: Option<usize>, } // 因为 Rust trait 的孤儿规则,我们如果要想对已有的类型实现已有的 trait, // 需要简单包装一下 pub struct Expression(pub(crate) Box<SqlExpr>); pub struct Operation(pub(crate) SqlBinaryOperator); pub struct Projection<'a>(pub(crate) &'a SelectItem); pub struct Source<'a>(pub(crate) &'a [TableWithJoins]); pub struct Order<'a>(pub(crate) &'a OrderByExpr); pub struct Offset<'a>(pub(crate) &'a SqlOffset); pub struct Limit<'a>(pub(crate) &'a SqlExpr); pub struct Value(pub(crate) SqlValue);

sql的转换

/// 把 SqlParser 解析出来的 Statement 转换成我们需要的结构 impl<'a> TryFrom<&'a Statement> for Sql<'a> { type Error = anyhow::Error; fn try_from(sql: &'a Statement) -> Result<Self, Self::Error> { match sql { // 目前我们只关心 query (select ... from ... where ...) Statement::Query(q) => { let offset = q.offset.as_ref(); let limit = q.limit.as_ref(); let orders = &q.order_by; let Select { from: table_with_joins, selection: where_clause, projection, group_by: _, .. } = match &q.body { SetExpr::Select(statement) => statement.as_ref(), _ => return Err(anyhow!("We only support Select Query at the moment")), }; let source = Source(table_with_joins).try_into()?; let condition = match where_clause { Some(expr) => Some(Expression(Box::new(expr.to_owned())).try_into()?), None => None, }; let mut selection = Vec::with_capacity(8); for p in projection { let expr = Projection(p).try_into()?; selection.push(expr); } let mut order_by = Vec::new(); for expr in orders { order_by.push(Order(expr).try_into()?); } let offset = offset.map(|v| Offset(v).into()); let limit = limit.map(|v| Limit(v).into()); Ok(Sql { selection, condition, source, order_by, offset, limit, }) } _ => Err(anyhow!("We only support Query at the moment")), } } }

对应部分结构体的转换

/// 把 SqlParser 的 Expr 转换成 DataFrame 的 Expr impl TryFrom<Expression> for Expr { type Error = anyhow::Error; fn try_from(expr: Expression) -> Result<Self, Self::Error> { match *expr.0 { SqlExpr::BinaryOp { left, op, right } => Ok(Expr::BinaryExpr { left: Box::new(Expression(left).try_into()?), op: Operation(op).try_into()?, right: Box::new(Expression(right).try_into()?), }), SqlExpr::Wildcard => Ok(Self::Wildcard), SqlExpr::IsNull(expr) => Ok(Self::IsNull(Box::new(Expression(expr).try_into()?))), SqlExpr::IsNotNull(expr) => Ok(Self::IsNotNull(Box::new(Expression(expr).try_into()?))), SqlExpr::Identifier(id) => Ok(Self::Column(Arc::new(id.value))), SqlExpr::Value(v) => Ok(Self::Literal(Value(v).try_into()?)), v => Err(anyhow!("expr {:#?} is not supported", v)), } } } /// 把 SqlParser 的 BinaryOperator 转换成 DataFrame 的 Operator impl TryFrom<Operation> for Operator { type Error = anyhow::Error; fn try_from(op: Operation) -> Result<Self, Self::Error> { match op.0 { SqlBinaryOperator::Plus => Ok(Self::Plus), SqlBinaryOperator::Minus => Ok(Self::Minus), SqlBinaryOperator::Multiply => Ok(Self::Multiply), SqlBinaryOperator::Divide => Ok(Self::Divide), SqlBinaryOperator::Modulo => Ok(Self::Modulus), SqlBinaryOperator::Gt => Ok(Self::Gt), SqlBinaryOperator::Lt => Ok(Self::Lt), SqlBinaryOperator::GtEq => Ok(Self::GtEq), SqlBinaryOperator::LtEq => Ok(Self::LtEq), SqlBinaryOperator::Eq => Ok(Self::Eq), SqlBinaryOperator::NotEq => Ok(Self::NotEq), SqlBinaryOperator::And => Ok(Self::And), SqlBinaryOperator::Or => Ok(Self::Or), v => Err(anyhow!("Operator {} is not supported", v)), } } } /// 把 SqlParser 的 SelectItem 转换成 DataFrame 的 Expr impl<'a> TryFrom<Projection<'a>> for Expr { type Error = anyhow::Error; fn try_from(p: Projection<'a>) -> Result<Self, Self::Error> { match p.0 { SelectItem::UnnamedExpr(SqlExpr::Identifier(id)) => Ok(col(&id.to_string())), SelectItem::ExprWithAlias { expr: SqlExpr::Identifier(id), alias, } => Ok(Expr::Alias( Box::new(Expr::Column(Arc::new(id.to_string()))), Arc::new(alias.to_string()), )), SelectItem::QualifiedWildcard(v) => Ok(col(&v.to_string())), SelectItem::Wildcard => Ok(col("*")), item => Err(anyhow!("projection {} not supported", item)), } } } impl<'a> TryFrom<Source<'a>> for &'a str { type Error = anyhow::Error; fn try_from(source: Source<'a>) -> Result<Self, Self::Error> { if source.0.len() != 1 { return Err(anyhow!("We only support single data source at the moment")); } let table = &source.0[0]; if !table.joins.is_empty() { return Err(anyhow!("We do not support joint data source at the moment")); } match &table.relation { TableFactor::Table { name, .. } => Ok(&name.0.first().unwrap().value), _ => Err(anyhow!("We only support table")), } } } /// 把 SqlParser 的 order by expr 转换成 (列名, 排序方法) impl<'a> TryFrom<Order<'a>> for (String, bool) { type Error = anyhow::Error; fn try_from(o: Order) -> Result<Self, Self::Error> { let name = match &o.0.expr { SqlExpr::Identifier(id) => id.to_string(), expr => { return Err(anyhow!( "We only support identifier for order by, got {}", expr )) } }; Ok((name, !o.0.asc.unwrap_or(true))) } } /// 把 SqlParser 的 offset expr 转换成 i64 impl<'a> From<Offset<'a>> for i64 { fn from(offset: Offset) -> Self { match offset.0 { SqlOffset { value: SqlExpr::Value(SqlValue::Number(v, _b)), .. } => v.parse().unwrap_or(0), _ => 0, } } } /// 把 SqlParser 的 Limit expr 转换成 usize impl<'a> From<Limit<'a>> for usize { fn from(l: Limit<'a>) -> Self { match l.0 { SqlExpr::Value(SqlValue::Number(v, _b)) => v.parse().unwrap_or(usize::MAX), _ => usize::MAX, } } } /// 把 SqlParser 的 value 转换成 DataFrame 支持的 LiteralValue impl TryFrom<Value> for LiteralValue { type Error = anyhow::Error; fn try_from(v: Value) -> Result<Self, Self::Error> { match v.0 { SqlValue::Number(v, _) => Ok(LiteralValue::Float64(v.parse().unwrap())), SqlValue::Boolean(v) => Ok(LiteralValue::Boolean(v)), SqlValue::Null => Ok(LiteralValue::Null), v => Err(anyhow!("Value {} is not supported", v)), } } }

单元测试

#[cfg(test)] mod tests { use super::*; use crate::TyrDialect; use sqlparser::parser::Parser; #[test] fn parse_sql_works() { let url = "http://abc.xyz/abc?a=1&b=2"; let sql = format!( "select a, b, c from {} where a=1 order by c desc limit 5 offset 10", url ); let statement = &Parser::parse_sql(&TyrDialect::default(), sql.as_ref()).unwrap()[0]; let sql: Sql = statement.try_into().unwrap(); assert_eq!(sql.source, url); assert_eq!(sql.limit, Some(5)); assert_eq!(sql.offset, Some(10)); assert_eq!(sql.order_by, vec![("c".into(), true)]); assert_eq!(sql.selection, vec![col("a"), col("b"), col("c")]); } }

src/dialect.rs

给方言结构体实现trait

// 创建自己的 sql 方言。TyrDialect 支持 identifier 可以是简单的 url impl Dialect for TyrDialect { fn is_identifier_start(&self, ch: char) -> bool { ('a'..='z').contains(&ch) || ('A'..='Z').contains(&ch) || ch == '_' } // identifier 可以有 ':', '/', '?', '&', '=' fn is_identifier_part(&self, ch: char) -> bool { ('a'..='z').contains(&ch) || ('A'..='Z').contains(&ch) || ('0'..='9').contains(&ch) || [':', '/', '?', '&', '=', '-', '_', '.'].contains(&ch) } }

添加测试用函数

/// 测试辅助函数 pub fn example_sql() -> String { let url = "https://raw.githubusercontent.com/owid/covid-19-data/master/public/data/latest/owid-covid-latest.csv"; let sql = format!( "SELECT location name, total_cases, new_cases, total_deaths, new_deaths \ FROM {} where new_deaths >= 500 ORDER BY new_cases DESC LIMIT 6 OFFSET 5", url ); sql }

单元测试

#[cfg(test)] mod tests { use super::*; use sqlparser::parser::Parser; #[test] fn it_works() { assert!(Parser::parse_sql(&TyrDialect::default(), &example_sql()).is_ok()); } }

src/loader.rs

定义Loader与CsvLoader

#[derive(Debug)] #[non_exhaustive] pub enum Loader { Csv(CsvLoader), } #[derive(Default, Debug)] pub struct CsvLoader(pub(crate) String);

定义trait并给CsvLoader实现

let sql = format!( "SELECT location name, total_cases, new_cases, total_deaths, new_deaths \ FROM {} where new_deaths >= 500 ORDER BY new_cases DESC LIMIT 6 OFFSET 5", url ); sql } #[cfg(test)] mod tests { use super::*; use sqlparser::parser::Parser;

todo: 给CsvLoader添加内容检测

fn it_works() { assert!(Parser::parse_sql(&TyrDialect::default(), &example_sql()).is_ok()); } }

src/fetcher.rs

定义UrlFetcher与FileFetcher

struct UrlFetcher<'a>(pub(crate) &'a str); struct FileFetcher<'a>(pub(crate) &'a str);

定义trait并给Fetcher与FileFetcher实现

// Rust 的 async trait 还没有稳定,可以用 async_trait 宏 #[async_trait] pub trait Fetch { type Error; async fn fetch(&self) -> Result<String, Self::Error>; } #[async_trait] impl<'a> Fetch for UrlFetcher<'a> { type Error = anyhow::Error; async fn fetch(&self) -> Result<String, Self::Error> { Ok(reqwest::get(self.0).await?.text().await?) } } #[async_trait] impl<'a> Fetch for FileFetcher<'a> { type Error = anyhow::Error; async fn fetch(&self) -> Result<String, Self::Error> { Ok(fs::read_to_string(&self.0[7..]).await?) } }

最后定义一个获取数据的方法

/// 从文件源或者 http 源中获取数据,返回字符串 pub async fn retrieve_data(source: impl AsRef<str>) -> Result<String> { let name = source.as_ref(); match &name[..4] { // 包括 http / https "http" => UrlFetcher(name).fetch().await, // 处理 file://<filename> "file" => FileFetcher(name).fetch().await, _ => Err(anyhow!("We only support http/https/file at the moment")), } }

queryer-js package: 使用neon

Cargo.toml

[package]

name = "queryer-js"

version = "0.1.0"

license = "ISC"

edition = "2021"

exclude = ["index.node"]

[lib]

crate-type = ["cdylib"]

[dependencies]

anyhow = "1"

queryer = { path = "../queryer" }

tokio = { version = "1", features = ["full"] }

[dependencies.neon]

version = "0.9"

default-features = false

features = ["napi-6"]

build in package.json

{

"name": "queryer-js",

"version": "0.1.0",

"description": "",

"main": "index.node",

"scripts": {

"build": "cargo-cp-artifact -nc index.node -- cargo build --message-format=json-render-diagnostics",

"build-debug": "npm run build --",

"build-release": "npm run build -- --release",

"install": "npm run build-release",

"test": "cargo test"

},

"author": "",

"license": "ISC",

"devDependencies": {

"cargo-cp-artifact": "^0.1"

}

}

src/lib.rs

use neon::prelude::*; pub fn example_sql(mut cx: FunctionContext) -> JsResult<JsString> { Ok(cx.string(queryer::example_sql())) } fn query(mut cx: FunctionContext) -> JsResult<JsString> { let sql = cx.argument::<JsString>(0)?.value(&mut cx); let output = match cx.argument::<JsString>(1) { Ok(v) => v.value(&mut cx), Err(_) => "csv".to_string(), }; let rt = tokio::runtime::Runtime::new().unwrap(); let data = rt.block_on(async { queryer::query(sql).await.unwrap() }); match output.as_str() { "csv" => Ok(cx.string(data.to_csv().unwrap())), v => cx.throw_type_error(format!("Output type {} not supported", v)), } } #[neon::main] fn main(mut cx: ModuleContext) -> NeonResult<()> { cx.export_function("example_sql", example_sql)?; cx.export_function("query", query)?; Ok(()) }

queryer-py package: 使用pyo3

python调用查询包

Cargo.toml

[package]

name = "queryer_py" # Python 模块需要用下划线

version = "0.1.0"

edition = "2021"

[lib]

crate-type = ["cdylib"] # 使用 cdylib 类型

[dependencies]

queryer = { path = "../queryer" } # 引入 queryer

tokio = { version = "1", features = ["full"] }

[dependencies.pyo3]

version = "0.14"

features = ["extension-module"]

[build-dependencies]

pyo3-build-config = "0.14"

src/lib.rs

#![allow(clippy::needless_option_as_deref)] use pyo3::{exceptions, prelude::*}; #[pyfunction] pub fn example_sql() -> PyResult<String> { Ok(queryer::example_sql()) } #[pyfunction] pub fn query(sql: &str, output: Option<&str>) -> PyResult<String> { let rt = tokio::runtime::Runtime::new().unwrap(); let data = rt.block_on(async { queryer::query(sql).await.unwrap() }); match output { Some("csv") | None => Ok(data.to_csv().unwrap()), Some(v) => Err(exceptions::PyTypeError::new_err(format!( "Output type {} not supported", v ))), } } #[pymodule] fn queryer_py(_py: Python, m: &PyModule) -> PyResult<()> { m.add_function(wrap_pyfunction!(query, m)?)?; m.add_function(wrap_pyfunction!(example_sql, m)?)?; Ok(()) }

data-viewer package: 使用tauri

Cargo.toml

[package] name = "app" version = "0.1.0" description = "A Tauri App" authors = ["you"] license = "" repository = "" default-run = "app" edition = "2021" build = "src/build.rs" See more keys and their definitions at https://doc.rust-lang.org/cargo/reference/manifest.html [build-dependencies] tauri-build = { version = "1.0.0-beta.4" } [dependencies] anyhow = "1" serde_json = "1" queryer = { path = "../../queryer" } serde = { version = "1.0", features = ["derive"] } tauri = { version = "1.0.0-beta.8", features = ["api-all"] } [features] default = [ "custom-protocol" ] custom-protocol = [ "tauri/custom-protocol" ]

main.rs

#![cfg_attr( all(not(debug_assertions), target_os = "windows"), windows_subsystem = "windows" )] #[tauri::command] fn example_sql() -> String { queryer::example_sql() } #[tauri::command] async fn query(sql: String) -> Result<String, String> { let data = queryer::query(&sql).await.map_err(|err| err.to_string())?; Ok(data.to_csv().map_err(|err| err.to_string())?) } fn main() { tauri::Builder::default() .invoke_handler(tauri::generate_handler![example_sql, query]) .run(tauri::generate_context!()) .expect("error while running tauri application"); }

Rust核心深入

资料推荐

I. 从栈堆、所有权、生命周期开始内存管理

内存

graph made by cursor

graph TD

A[内存] --> B[栈]

A --> C[堆]

B --> D[栈溢出]

C --> E[堆溢出]

C --> F[使用堆引用共享数据]

B --> G[栈帧示意图]

C --> H[字符串内存使用图]

`

Summarize made by cursor

本文主要介绍了 Rust 中的内存管理:

- 包括栈和堆的概念、栈溢出和堆溢出的问题以及如何使用堆引用共享数据。

- 文章通过图片和代码示例详细讲解了这些概念和问题

- 对于 Rust 初学者来说是一篇很好的入门文章。

Answers made by cursor

-

Rust中的内存管理包括哪些概念和问题? 本文介绍了 Rust 中的内存管理,包括栈和堆的概念、栈溢出和堆溢出的问题以及如何使用堆引用共享数据。

-

什么是栈和堆?它们有什么区别? 栈和堆都是内存中的一部分,栈是一种后进先出的数据结构,用于存储函数调用时的局部变量和函数调用的返回地址等信息,而堆是一种动态分配内存的机制,用于存储程序运行时动态分配的数据。栈和堆的主要区别在于它们的分配方式和管理方式不同。

-

如何使用堆引用共享数据? 可以使用指针或引用来引用堆中的数据,从而实现数据的共享。在 Rust 中,可以使用 Box

类型来创建堆上的数据,并使用 & 操作符来创建指向堆上数据的引用。 -

如何考虑栈溢出和堆溢出的问题? 栈溢出和堆溢出都是内存管理中的常见问题。栈溢出通常是由于递归调用或者函数调用层数过多导致的,可以通过增加栈的大小或者优化代码来解决。堆溢出通常是由于动态分配内存时没有正确释放导致的,可以通过手动释放内存或者使用 Rust 的内存管理机制来解决。

字符串内存使用图

栈

栈帧示意图

考虑栈溢出

堆

使用堆引用共享数据

考虑堆溢出

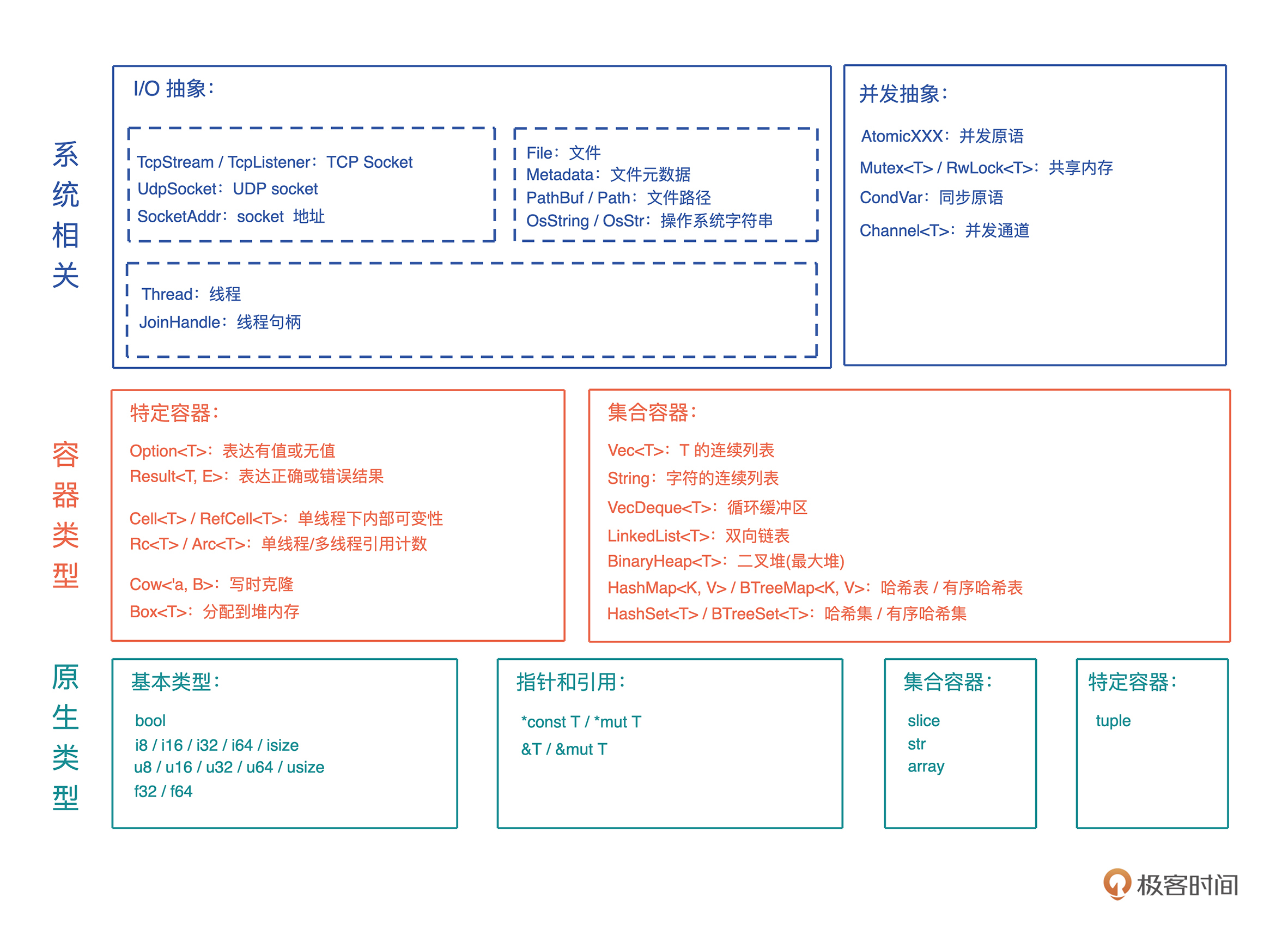

编程四大类基本概念

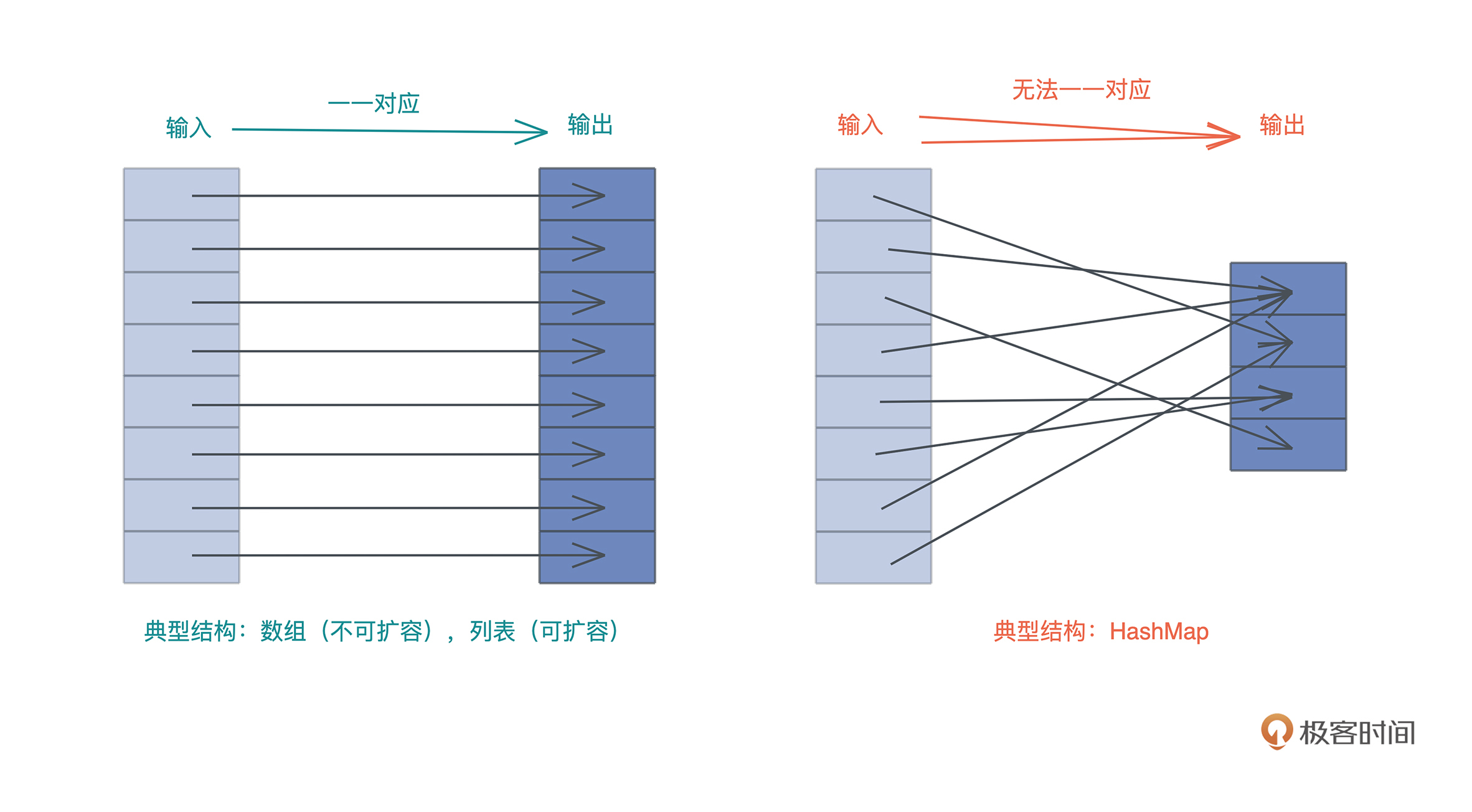

1. 数据

值和类型

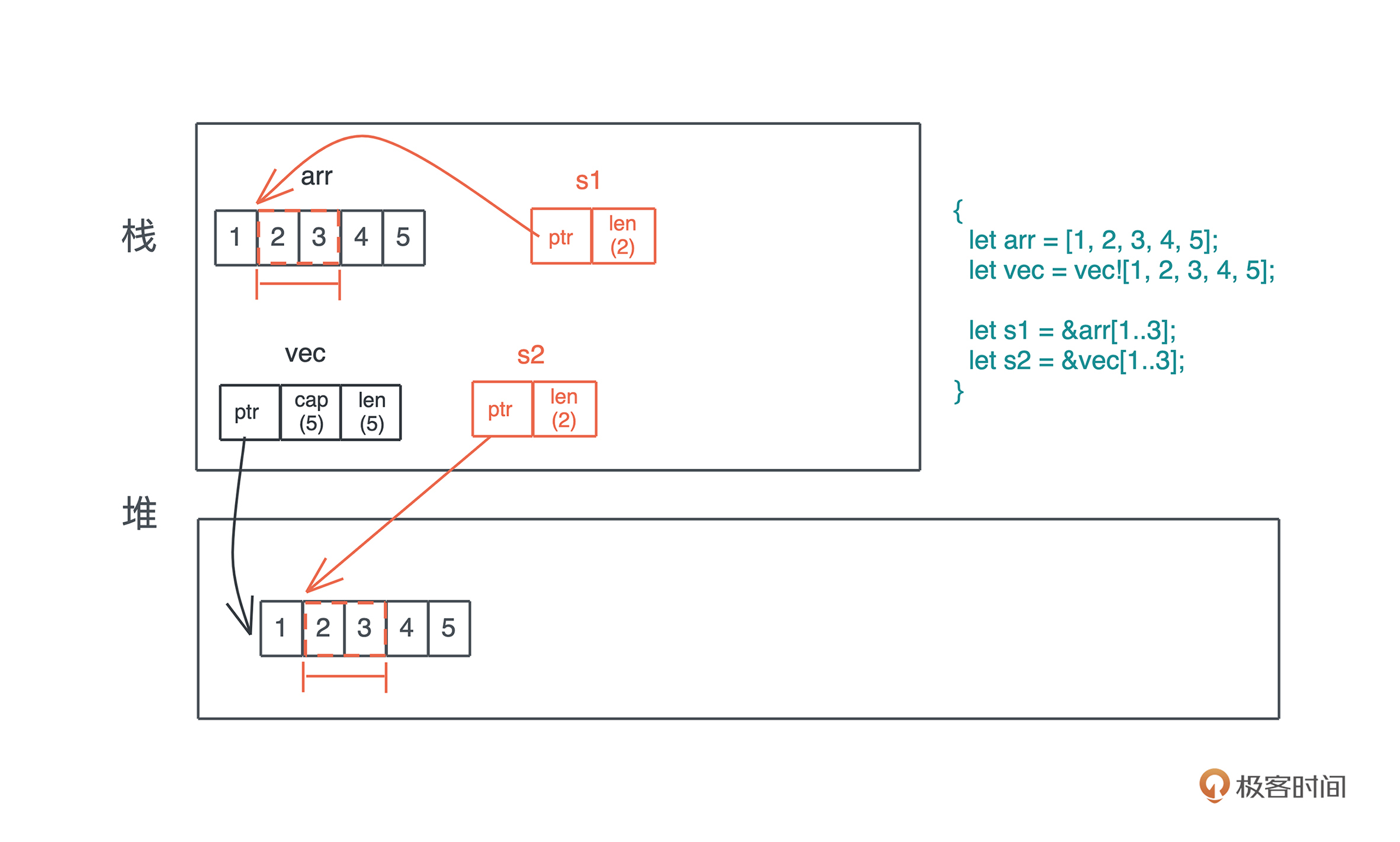

指针和引用

2. 代码

函数 -> 方法 -> 闭包

闭包示意图

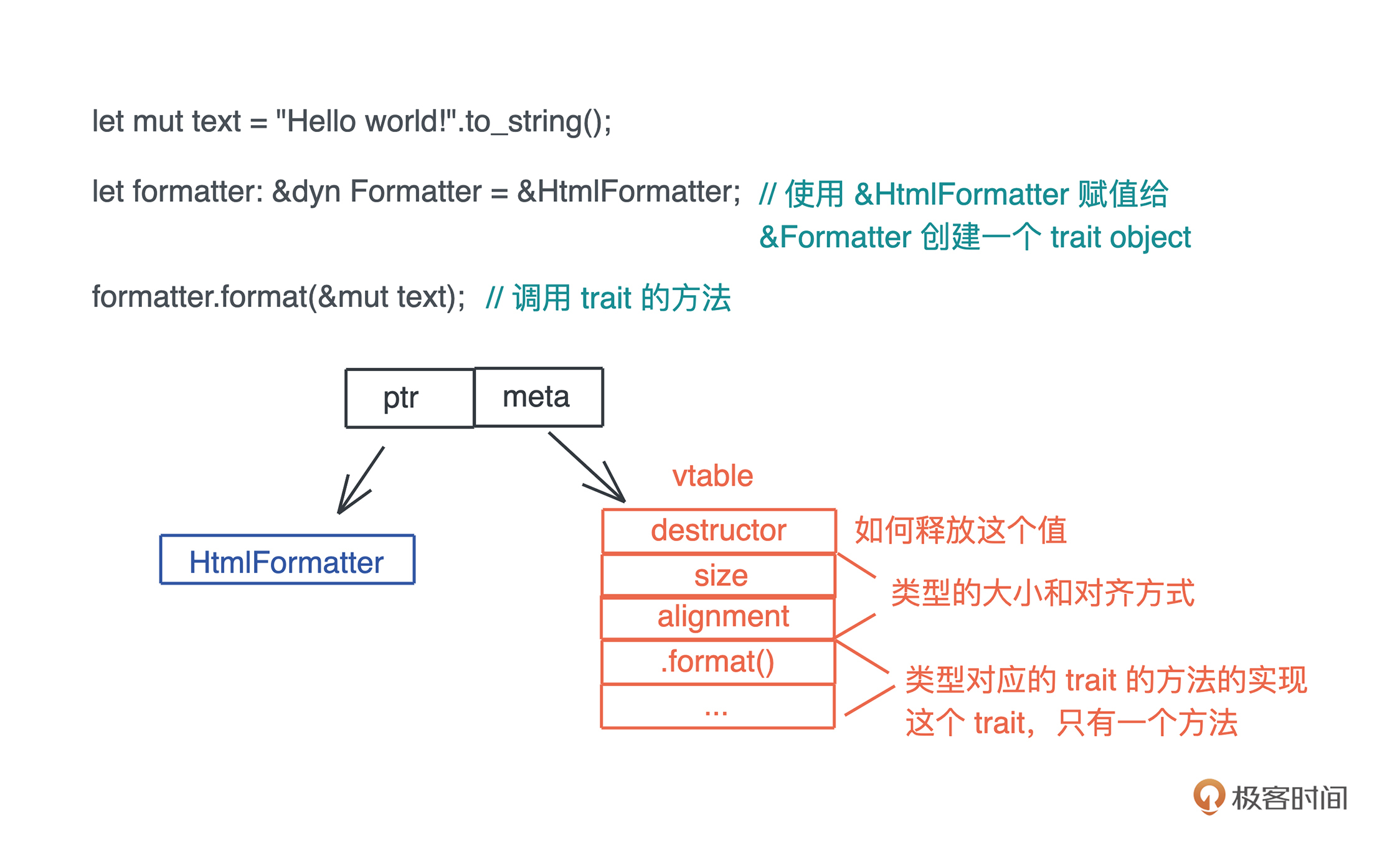

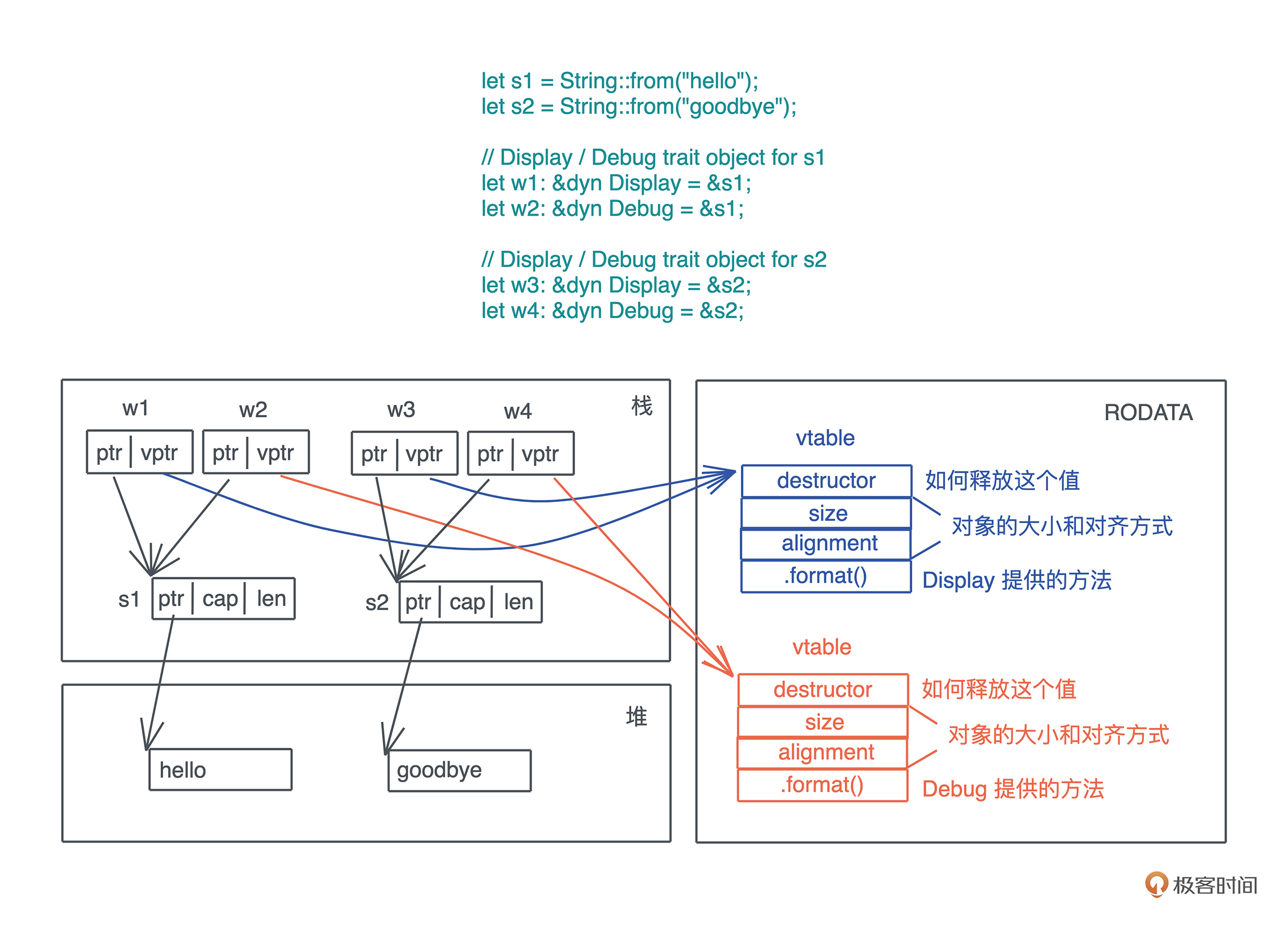

接口与虚表

3. 运行方式

并发与并行

同步和异步

4. 编程范式

泛型编程

函数式编程

面向对象编程

一、所有权: 单一/共享

对比单一/共享所有权

单一所有权:掌控生杀大权

从多引用开始

Rust如何解决

方案一、单一所有权

方案二、Copy

单一所有权规则整理

单一所有权借用

两种传参方式:传值/传址

只读借用/引用

借用的生命周期与约束

可变借用/引用

同一个上下文中多个可变引用是不安全的,那如果同时有一个可变引用和若干个只读引 用就可以

第一性原理理解单一所有权规则

共享内存-多个所有者:引用计数

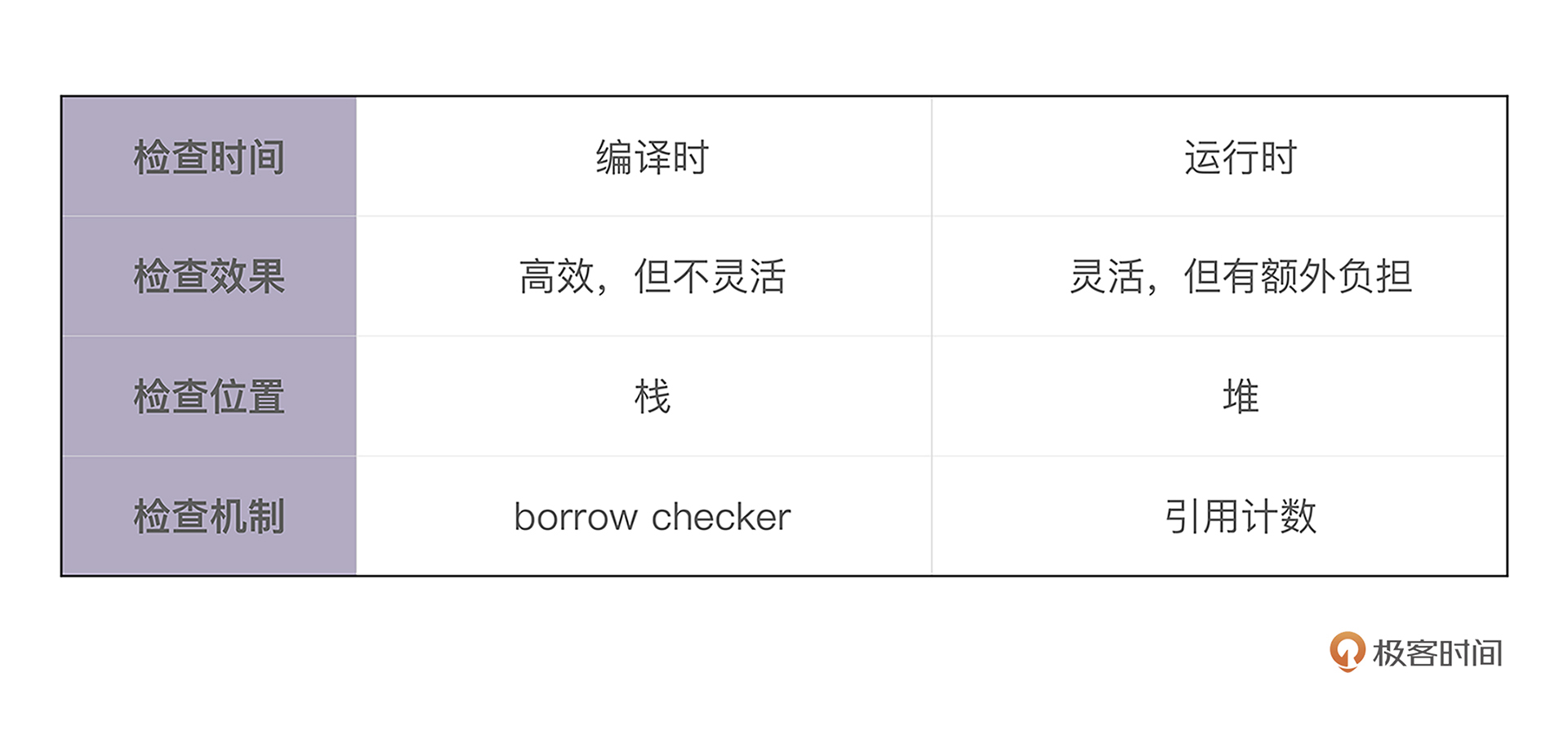

单一所有权与多个所有者是否有冲突?

- 静态检查:单一所有权是rust的编译期默认检查内容

- 动态检查:多个所有者主要是用于共享内存,这是专门提供Rc/Arc、Box::leak()、RefCell/Mutex/RwLock等工具。

这里其实可以看出rust如何使用’二八法则’解决问题:

- 对于常用场景,用编译期静态检查来默认解决

- 对于特别场景,用专门的语法显式表达出来,提供运行期动态检查来专门解决

Rc使用说明: 只读引用计数

对一个 Rc 结构进行 clone(),不会将其内部的数据复制,只会增加引用计数

use std::rc::Rc; fn main() { let a = Rc::new(1); let b = a.clone(); let c = a.clone(); }

clone源码

fn clone(&self) -> Rc<T> { // 增加引用计数 self.inner().inc_strong(); // 通过 self.ptr 生成一个新的 Rc 结构 Self::from_inner(self.ptr) }

Rc使用Box::leak()

有了 Box::leak(),我们就可以跳出 Rust 编译器的静态检查

保证 Rc 指向的堆内存,有最大的生命周期,然后我们再通过引用计数,在合适的时机,结束这段内存的生命周期。如果你对此感兴趣,可以看 Rc::new() 的源码。

使用Rc实现DAG

不可修改版本

use std::rc::Rc; #[allow(dead_code)] #[derive(Debug)] struct Node { id: usize, downstream: Option<Rc<Node>>, } impl Node { pub fn new(id: usize) -> Self { Self { id, downstream: None, } } pub fn update_downstream(&mut self, downstream: Rc<Node>) { self.downstream = Some(downstream); } pub fn get_downstream(&self) -> Option<Rc<Node>> { self.downstream.as_ref().cloned() } } fn main() { let mut node1 = Node::new(1); let mut node2 = Node::new(2); let mut node3 = Node::new(3); let node4 = Node::new(4); node3.update_downstream(Rc::new(node4)); node1.update_downstream(Rc::new(node3)); node2.update_downstream(node1.get_downstream().unwrap()); println!("node1: {:?}, node2: {:?}", node1, node2); // 无法编译通过: cannot borrow as mutable // let node5 = Node::new(5); // let node3 = node1.get_downstream().unwrap(); // node3.update_downstream(Rc::new(node5)); // println!("node1: {:?}, node2: {:?}", node1, node2); }

- new():建立一个新的 Node。

- update_downstream():设置 Node 的 downstream。

- get_downstream():clone 一份 Node 里的 downstream。

RefCell: 提供内部可变性,可变引用计数

外部可变性与内部可变性

RefCell简单使用

获得 RefCell 内部数据的可变借用

use std::cell::RefCell; fn main() { let data = RefCell::new(1); { // 获得 RefCell 内部数据的可变借用 let mut v = data.borrow_mut(); *v += 1; } println!("data: {:?}", data.borrow()); }

使用RefCell实现可修改版本DAG

use std::cell::RefCell; use std::rc::Rc; #[allow(dead_code)] #[derive(Debug)] struct Node { id: usize, // 使用 Rc<RefCell<T>> 让节点可以被修改 downstream: Option<Rc<RefCell<Node>>>, } impl Node { pub fn new(id: usize) -> Self { Self { id, downstream: None, } } pub fn update_downstream(&mut self, downstream: Rc<RefCell<Node>>) { self.downstream = Some(downstream); } pub fn get_downstream(&self) -> Option<Rc<RefCell<Node>>> { self.downstream.as_ref().cloned() } } fn main() { let mut node1 = Node::new(1); let mut node2 = Node::new(2); let mut node3 = Node::new(3); let node4 = Node::new(4); node3.update_downstream(Rc::new(RefCell::new(node4))); node1.update_downstream(Rc::new(RefCell::new(node3))); node2.update_downstream(node1.get_downstream().unwrap()); println!("node1: {:?}, node2: {:?}", node1, node2); let node5 = Node::new(5); let node3 = node1.get_downstream().unwrap(); // 获得可变引用,来修改 downstream node3.borrow_mut().downstream = Some(Rc::new(RefCell::new(node5))); println!("node1: {:?}, node2: {:?}", node1, node2); }

- 首先数据结构的 downstream 需要 Rc 内部嵌套一个 RefCell

- 这样,就可以利用 RefCell 的内部可变性,来获得数据的可变借用

- 同时 Rc 还允许值有多个所有者。

线程安全版本计数器:Arc(Rc)、Mutex/RwLock(RefCell)

Rust实现两套不同的引用计数数据结构

Arc 内部的引用计数使用了 Atomic Usize ,而非普通的 usize。 从名称上也可以感觉出来,Atomic Usize 是 usize 的原子类型,它使用了 CPU 的特殊指令,来保证多线程下的安全。 如果你对原子类型感兴趣,可以看 std::sync::atomic 的文档。

Rust 实现两套不同的引用计数数据结构,完全是为了性能考虑,从这里我们也可以感受到 Rust 对性能的极致渴求:

- 如果不用跨线程访问,可以用效率非常高的 Rc; 如果要跨线程访问,那么必须用 Arc。

- 同样的,RefCell 也不是线程安全的,如果我们要在多线程中,使用内部可变性,Rust 提供了 Mutex 和 RwLock。

Mutex/RwLock其实是并发的两个方案

这两个数据结构你应该都不陌生:

- Mutex 是互斥量,获得互斥量的线程对数据独占访问.

- RwLock 是读写锁,获得写锁的线程对数据独占访问,但当没有写锁的时候,允许有多个读锁。

- 读写锁的规则和 Rust 的借用规则非常类似,我们可以类比着学。

- Mutex 和 RwLock 都用在多线程环境下,对共享数据访问的保护上。

- 前面构建的 DAG 如果要用在多线程环境下,需要把 Rc> 替换为 Arc> 或者 Arc>。

二、生命周期

动态还是静态?

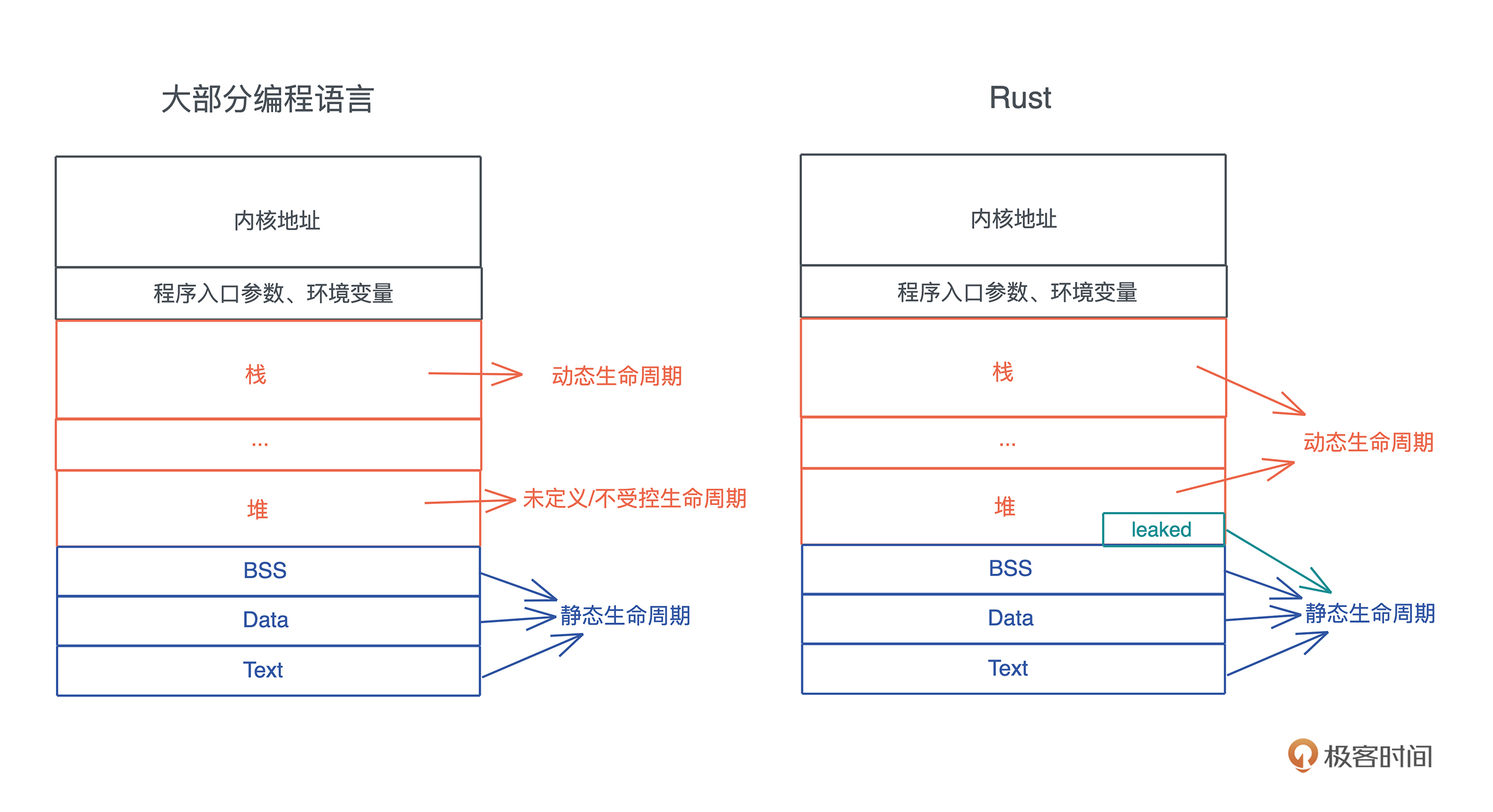

动态/静态生命周期定义与表示方式

- 静态生命周期: ’static str

- 如果一个值的生命周期贯穿整个进程的生命周期,那么我们就称这种生命周期为静态生命周期。

- 当值拥有静态生命周期,其引用也具有静态生命周期。

- 我们在表述这种引用的时候,可以用 ’static 来表示。比如: &’static str 代表这是一个具有静态生命周期的字符串引用。

- 一般来说,全局变量、静态变量、字符串字面量(string literal (字面) )等,都拥有静态生命周期。

- 堆内存,如果使用了 Box::leak 后,也具有静态生命周期。

- 动态生命周期: ’a 、’b 或者 ’hello 这样的小写字符或者字符串来表述

- 如果一个值是在某个作用域中定义的,也就是说它被创建在栈上或者堆上,那么其生命周期是动态的。

- 当这个值的作用域结束时,值的生命周期也随之结束。

- 对于动态生命周期,我们约定用 ’a 、’b 或者 ’hello 这样的小写字符或者字符串来表述。

- ’ 后面具体是什么名字不重要,它代表某一段动态的生命周期

- 其中, &’a str 和 &’b str 表示这两个字符串引用的生命周期可能不一致。

动静态生命周期示意图

- 分配在堆和栈上的内存有其各自的作用域,它们的生命周期是动态的。

- 全局变量、静态变量、字符串字面量、代码等内容,在编译时,会被编译到可执行文件中的 BSS/Data/RoData/Text 段,然后在加载时,装入内存。

- 因而,它们的生命周期和进程的生命周期一致,所以是静态的。

- 所以,函数指针的生命周期也是静态的,因为函数在 Text 段中,只要进程活着,其内存一直存在。

如何识别生命周期

其实生命周期参数主要用于帮助编译器识别引用的生命周期范围,对于明显不符合生命周期参数的变量,哪怕加了生命周期参数也不会通过。

只有传址的参数,且多于一个,才可能需要生命周期标注

两个小例子

两个小例子

- x 引用了在内层作用域中创建出来的变量 y。由于,变量从开始定义到其作用域结束的这段时间,是它的生命周期,所以 x 的生命周期 ’a 大于 y 的生命周期 ’b,当 x 引用 y 时,编译器报错。

- y 和 x 处在同一个作用域下, x 引用了 y,我们可以看到 x 的生命周期 ’a 和 y 的生命周期 ’b 几乎同时结束,或者说 ’a 小于等于 ’b,所以,x 引用 y 是可行的。

编译器其实会自动进行生命周期标注

编译器希望尽可能减轻开发者的负担,其实所有使用了引用的函数,都需要生命周期的标注,只不过编译器会自动做这件事,省却了开发者的麻烦

编译器自动进行生命周期标注

- 无标注版本

fn main() { let s1 = "Hello world"; println!("first word of s1: {}", first(s1)); } // 如果你用 clippy,多余的 lifetime 会提醒你不需要 // fn first<'a>(s: &'a str) -> &'a str { fn first(s: &str) -> &str { let trimmed = s.trim(); match trimmed.find(' ') { None => "", Some(pos) => &trimmed[..pos], } }

- 自动标注

fn main() { let s1 = "Lindsey"; let s2 = String::from("Rosie"); let result = max(s1, &s2); println!("bigger one: {}", result); } fn max<'a>(s1: &'a str, s2: &'a str) -> &'a str { if s1 > s2 { s1 } else { s2 } }

返回值如何标注?是 ’a 还是’b 呢?这里的冲突,编译器无能为力。

自动标注规则

- 所有引用类型的参数都有独立的生命周期 ’a 、’b 等。

- 如果只有一个引用型输入,它的生命周期会赋给所有输出。

- 如果有多个引用类型的参数,其中一个是 self,那么它的生命周期会赋给所有输出。

需要生命周期标注的情况

missing lifetime specifier

fn main() { let s1 = String::from("Lindsey"); let s2 = String::from("Rosie"); let result = max(&s1, &s2); println!("bigger one: {}", result); let result = get_max(s1); println!("bigger one: {}", result); } fn get_max(s1: &str) -> &str { // 字符串字面量的生命周期是静态的,而 s1 是动态的,它们的生命周期显然不一致 max(s1, "Cynthia") } // 这段代码无法编译通过 fn max(s1: &str, s2: &str) -> &str { if s1 > s2 { s1 } else { s2 } }

- 编译器在编译 max() 函数时,无法判断 s1、s2 和返回值的生命周期。

- 函数本身携带的信息,就是编译器在编译时使用的全部信息。

- 这里函数本身提供的信息就告诉编译期,生命周期不一致

添加生命周期标注即可编译通过

fn main() { let s1 = String::from("Lindsey"); let s2 = String::from("Rosie"); let result = max(&s1, &s2); println!("bigger one: {}", result); let result = get_max(&s1); println!("bigger one: {}", result); } fn get_max(s1: &str) -> &str { max(s1, "Cynthia") } fn max<'a>(s1: &'a str, s2: &'a str) -> &'a str { if s1 > s2 { s1 } else { s2 } }

生命周期标注练习

标注练习题

pub fn strtok(s: &mut &str, delimiter: char) -> &str { if let Some(i) = s.find(delimiter) { let prefix = &s[..i]; // 由于 delimiter 可以是 utf8,所以我们需要获得其 utf8 长度, // 直接使用 len 返回的是字节长度,会有问题 let suffix = &s[(i + delimiter.len_utf8())..]; *s = suffix; prefix } else { // 如果没找到,返回整个字符串,把原字符串指针 s 指向空串 let prefix = *s; *s = ""; prefix } } fn main() { let s = "hello world".to_owned(); let mut s1 = s.as_str(); let hello = strtok(&mut s1, ' '); println!("hello is: {}, s1: {}, s: {}", hello, s1, s); }

- 按照编译器的规则, &mut &str 添加生命周期后变成 &’b mut &’a str

- 这将导致返回的 ’&str 无法选择一个合适的生命周期。

标注练习题参考

pub fn strtok<'a>(s: &mut &'a str, delimiter: char) -> &'a str { if let Some(i) = s.find(delimiter) { let prefix = &s[..i]; let suffix = &s[(i + delimiter.len_utf8())..]; *s = suffix; prefix } else { let prefix = *s; *s = ""; prefix } } fn main() { let s = "hello world".to_owned(); let mut s1 = s.as_str(); let hello = strtok(&mut s1, ' '); println!("hello is: {}, s1: {}, s: {}", hello, s1, s); }

生命周期标注的目的

生命周期标注的目的是,在参数和返回值之间建立联系或者约束

生命周期标注的目的是,在参数和返回值之间建立联系或者约束:

- 调用函数时,传入的参数的生命周期需要大于等于标注的生命周期。

- 当每个函数都添加好生命周期标注后,编译器,就可以从函数调用的上下文中分析出,在传参时,引用的生命周期,是否和函数签名中要求的生命周期匹配。

- 如果不匹配,就违背了“引用的生命周期不能超出值的生命周期”,编译器就会报错。

三、融会贯通,从创建到消亡

创建

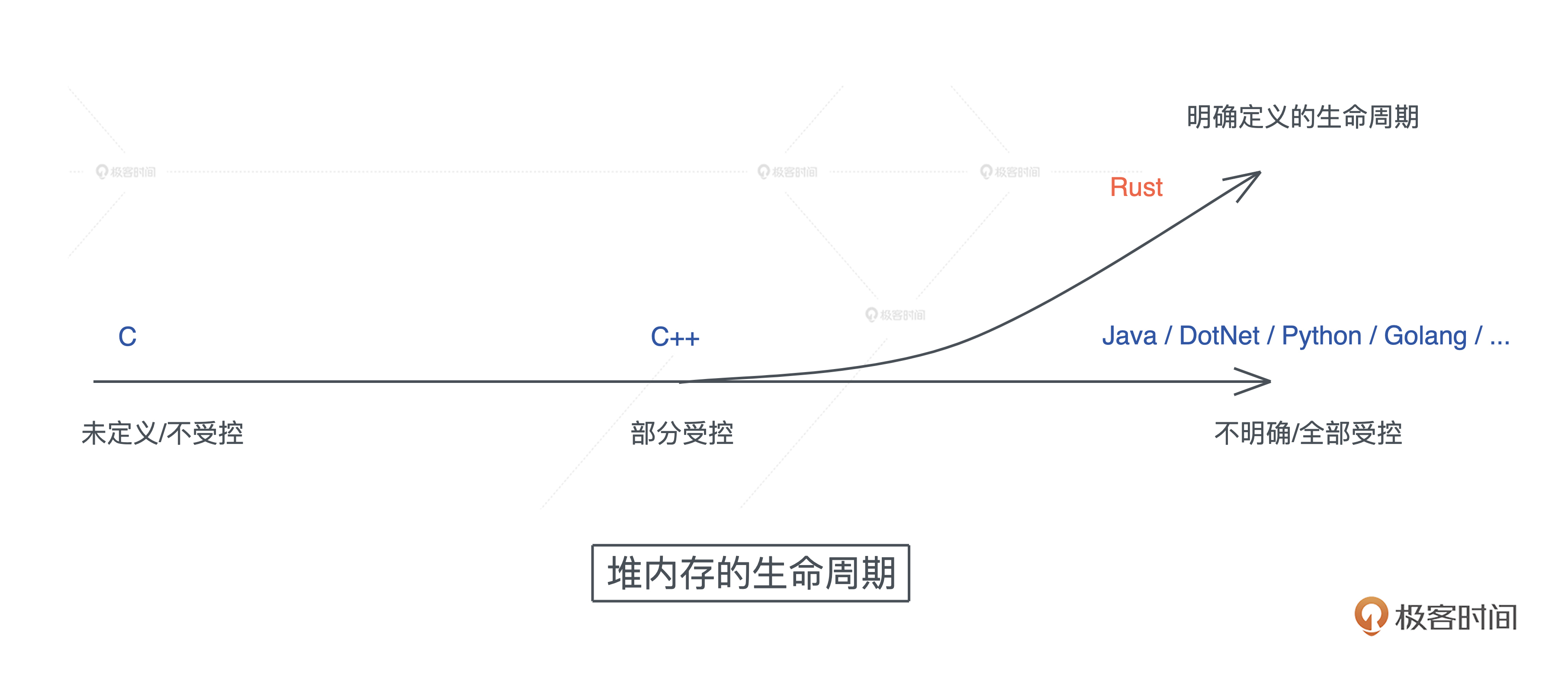

堆内存生命周期管理发展史

堆内存管理需求:动态大小 or 生命周期

Rust 的创造者们,重新审视了堆内存的生命周期,发现:

- 大部分堆内存的需求在于动态大小

- 小部分需求是更长的生命周期。

所以它默认将堆内存的生命周期和使用它的栈内存的生命周期绑在一起,并留了个小口子 leaked 机制,让堆内存在需要的时候,可以有超出帧存活期的生命周期。

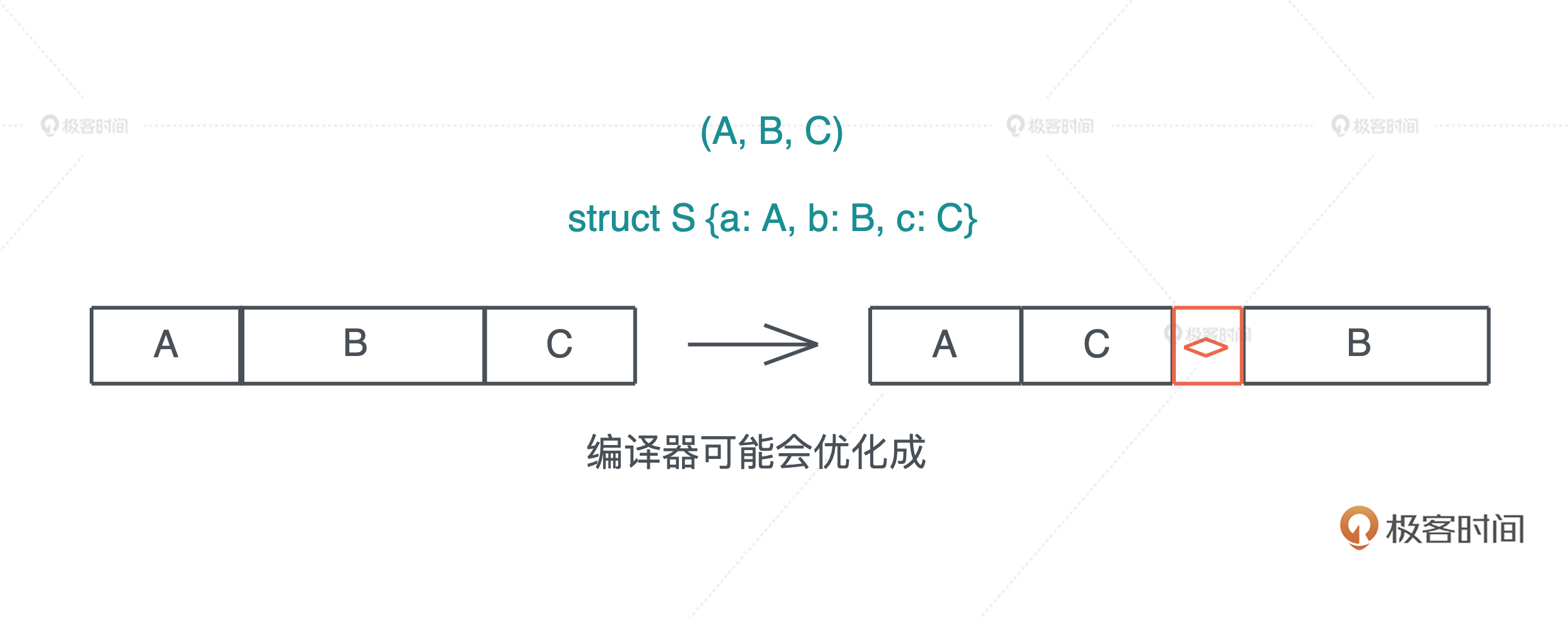

struct/enum/vec/String创建时的内存布局

内存布局优化什么意思?

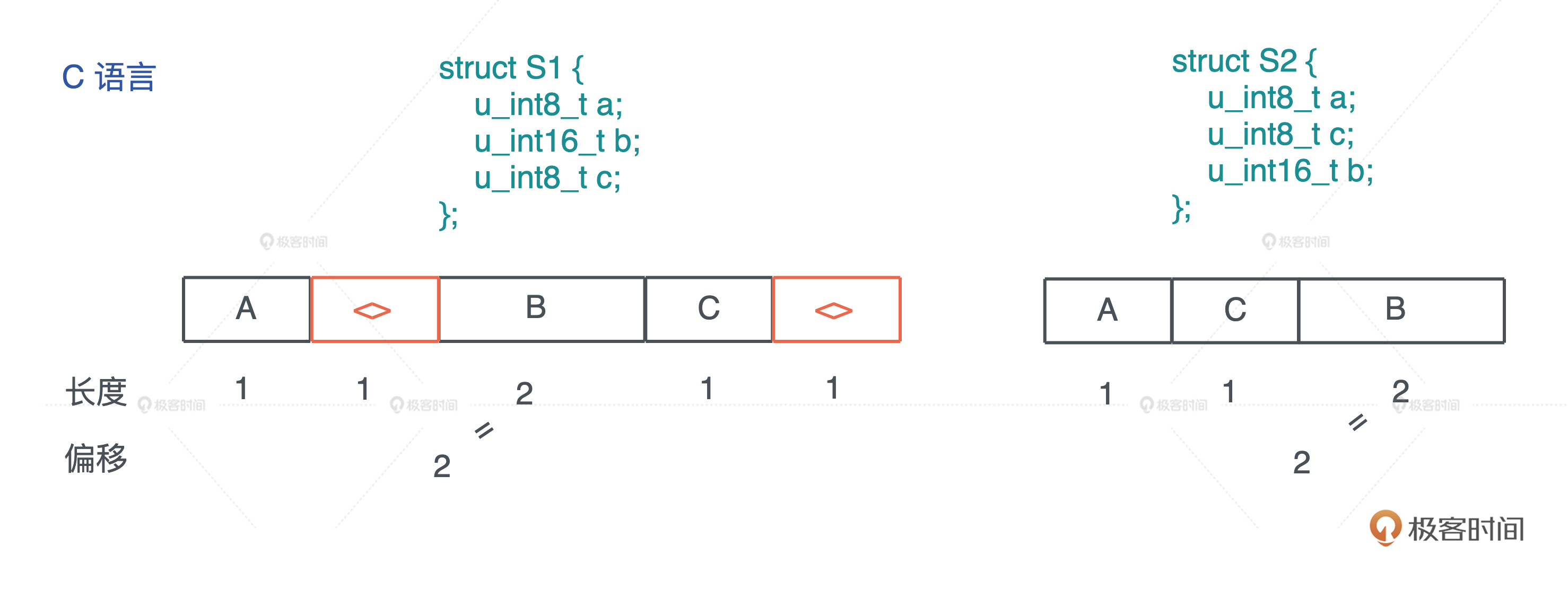

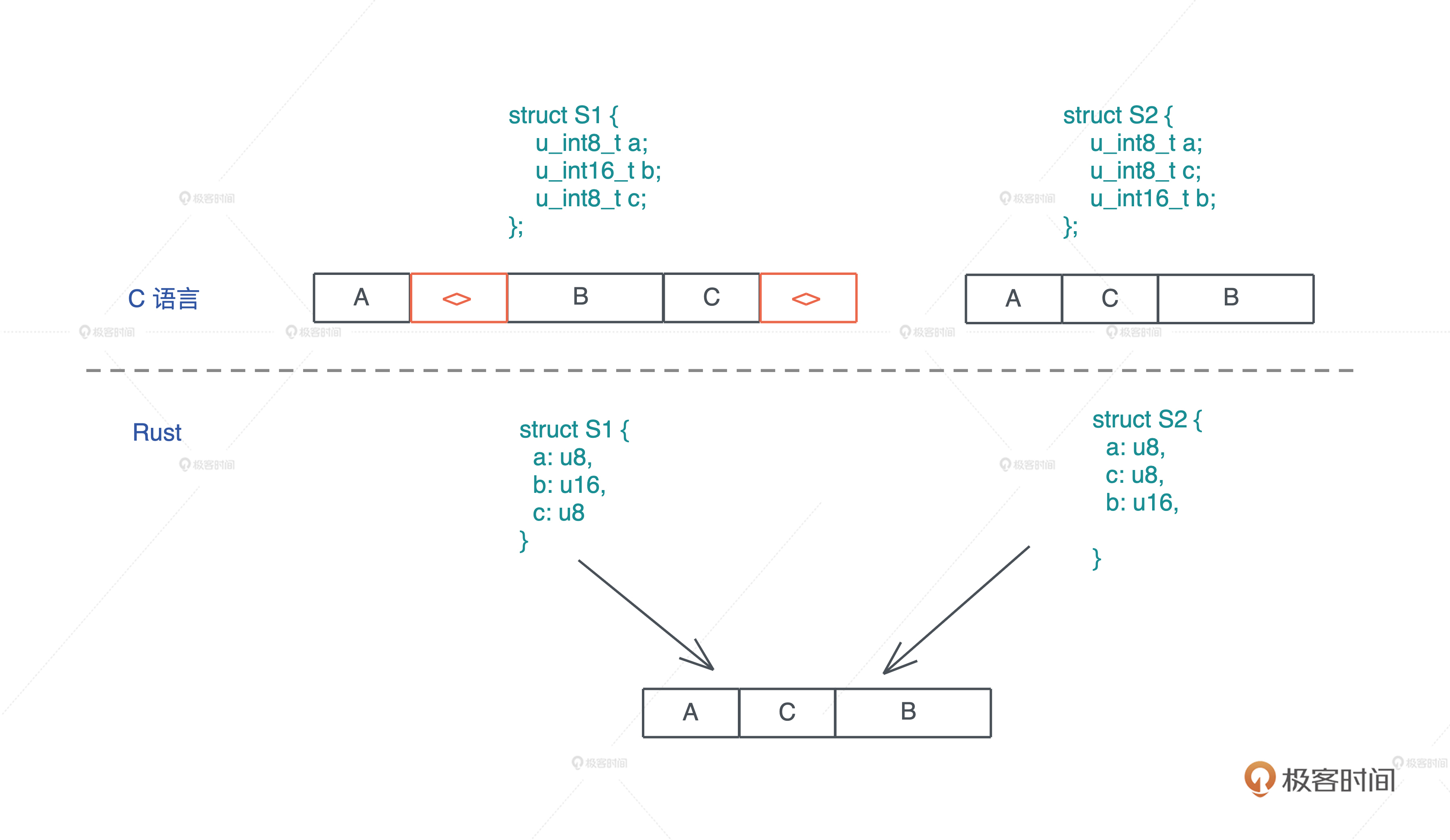

struct

代码对比rust和clang的内存布局优化

#include <stdio.h>

struct S1 {

u_int8_t a;

u_int16_t b;

u_int8_t c;

};

struct S2 {

u_int8_t a;

u_int8_t c;

u_int16_t b;

};

void main() {

printf("size of S1: %d, S2: %d", sizeof(struct S1), sizeof(struct S2));

}

use std::mem::{align_of, size_of}; #[allow(dead_code)] struct S1 { a: u8, b: u16, c: u8, } #[allow(dead_code)] struct S2 { a: u8, c: u8, b: u16, } fn main() { println!("sizeof S1: {}, S2: {}", size_of::<S1>(), size_of::<S2>()); println!("alignof S1: {}, S2: {}", align_of::<S1>(), align_of::<S2>()); }

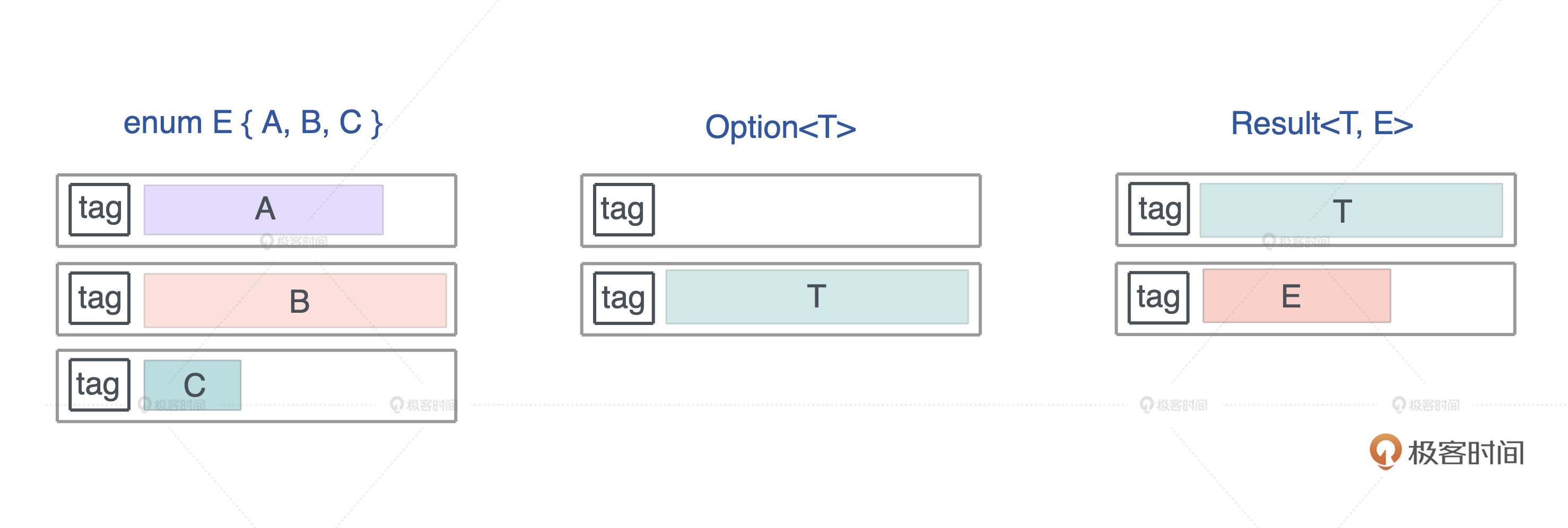

enum

Rust 编译器会对 enum 做一些额外的优化,让某些常用结构的内存布局更紧凑。

use std::collections::HashMap; use std::mem::size_of; #[allow(dead_code)] enum E { A(f64), B(HashMap<String, String>), C(Result<Vec<u8>, String>), } macro_rules! show_size { (header) => { println!( "{:<24} {:>4} {} {}", "Type", "T", "Option<T>", "Result<T, io::Error>" ); println!("{}", "-".repeat(64)); }; ($t:ty) => { println!( "{:<24} {:4} {:8} {:12}", stringify!($t), size_of::<$t>(), size_of::<Option<$t>>(), size_of::<Result<$t, std::io::Error>>(), ) }; } fn main() { show_size!(header); show_size!(u8); show_size!(f64); show_size!(&u8); show_size!(Box<u8>); show_size!(&[u8]); show_size!(String); show_size!(Vec<u8>); show_size!(HashMap<String, String>); show_size!(E); }

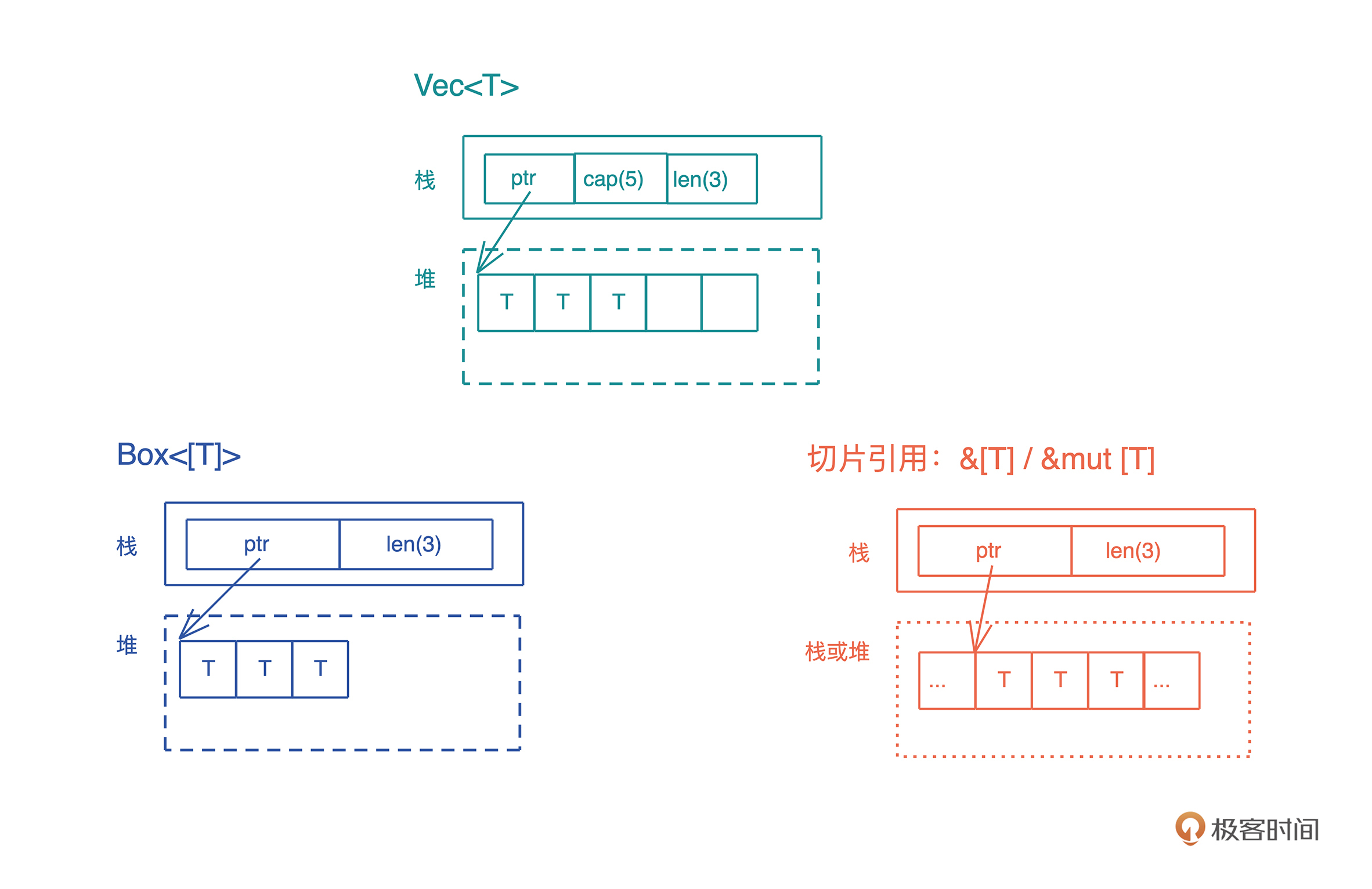

你会发现,Option 配合带有引用类型的数据结构,比如 &u8、Box、Vec、HashMap ,没有额外占用空间,这就很有意思了

Type T Option<T> Result<T, io::Error>

----------------------------------------------------------------

u8 1 2 24

f64 8 16 24

&u8 8 8 24

Box<u8> 8 8 24

&[u8] 16 16 24

String 24 24 32

Vec<u8> 24 24 32

HashMap<String, String> 48 48 56

E 56 56 64

Rust 是这么处理的:

- 我们知道,引用类型的第一个域是个指针,而指针是不可能等于 0 的,

- 但是我们可以复用这个指针:当其为 0 时,表示 None,否则是 Some,减少了内存占用,这是个非常巧妙的优化

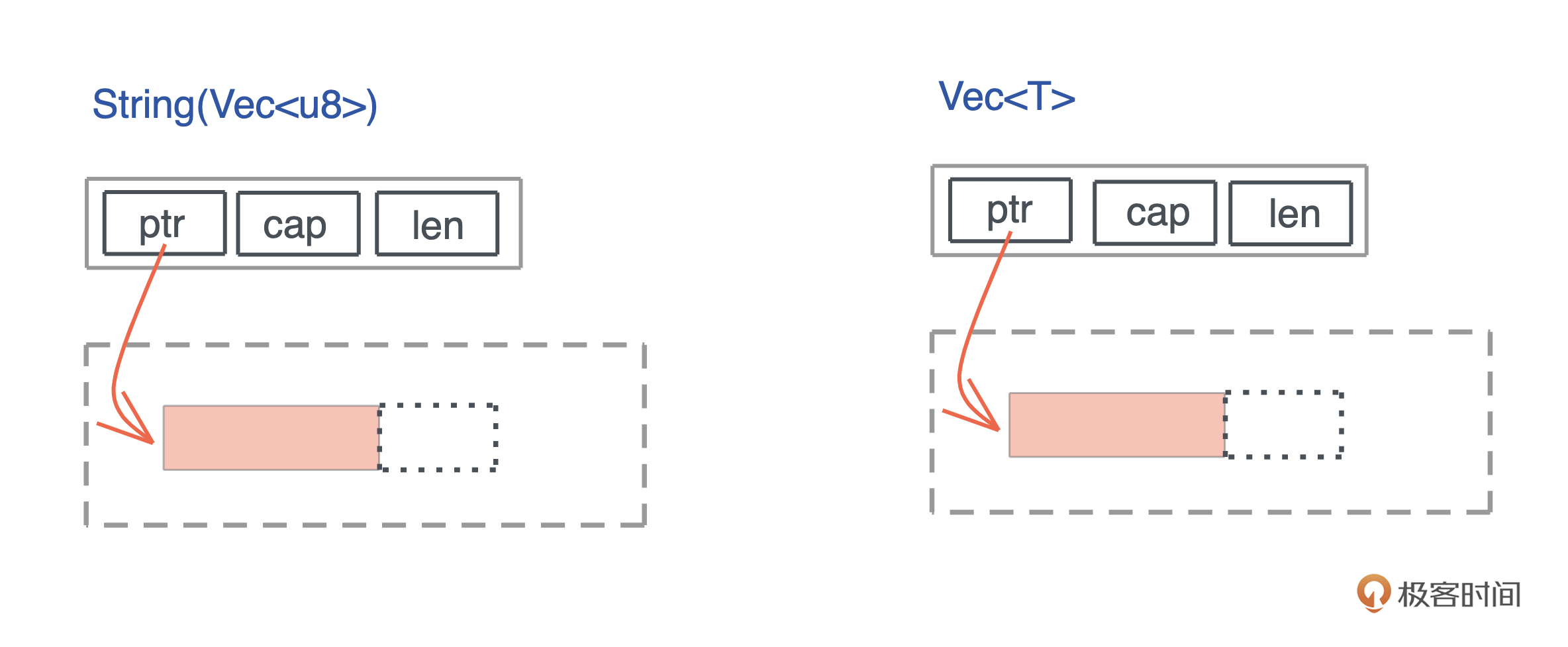

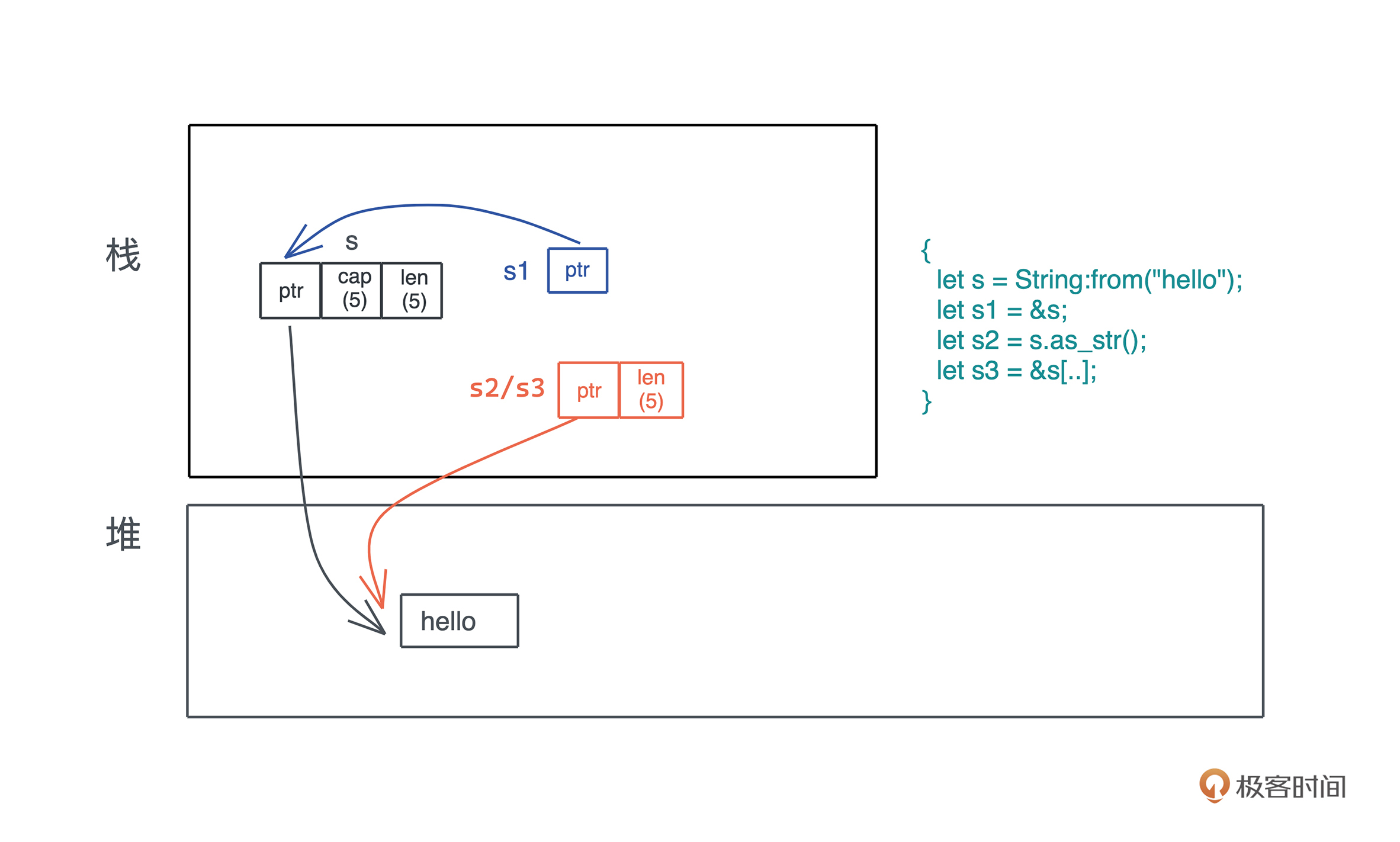

vec和String

String其实就是Vec

String 和 Vec 占用相同的大小,都是 24 个字节。其实,如果你打开 String 结构的源码,可以看到,它内部就是一个 Vec

引用类型的内存布局

更多可见cheats.rs

使用

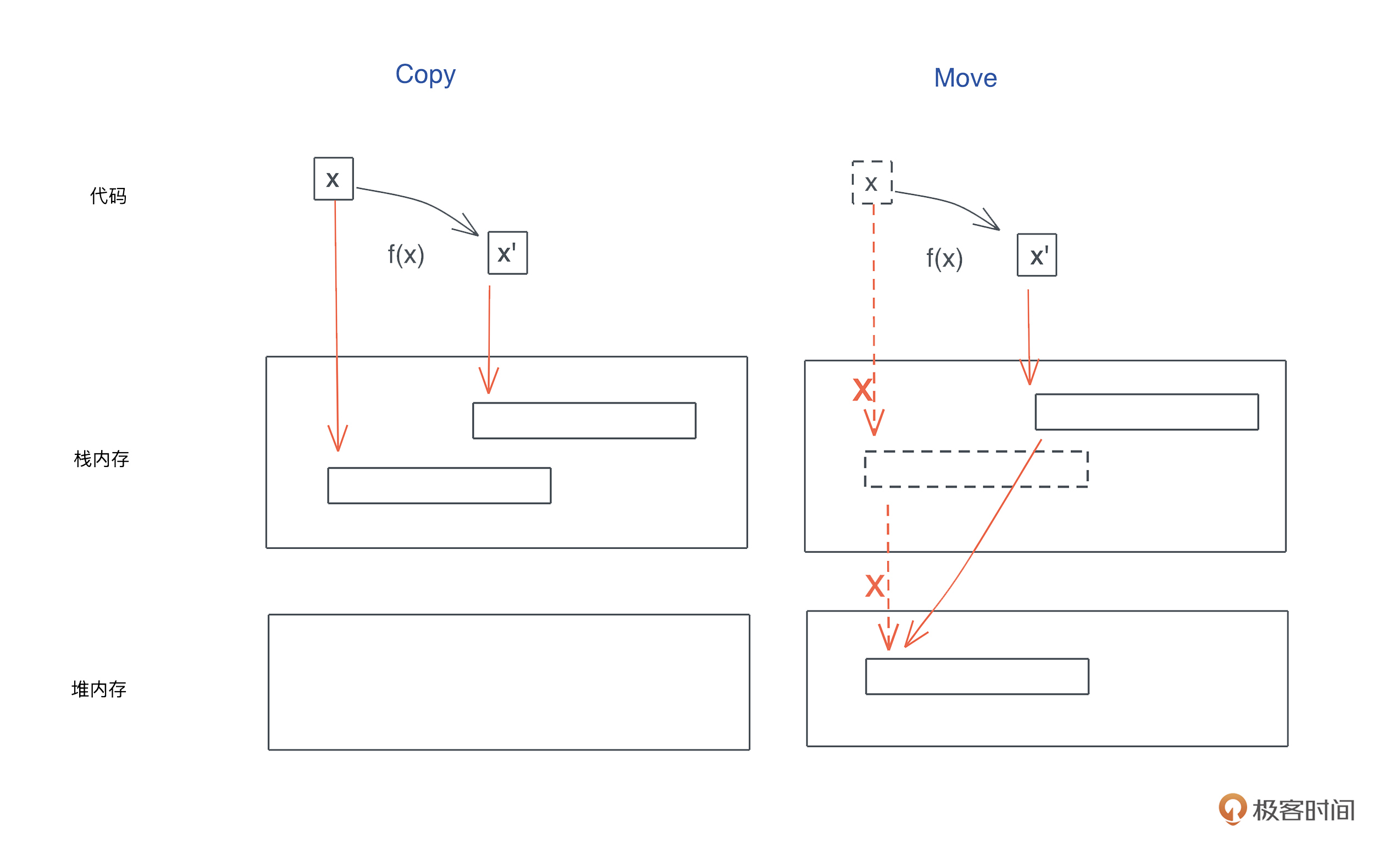

copy和move

销毁

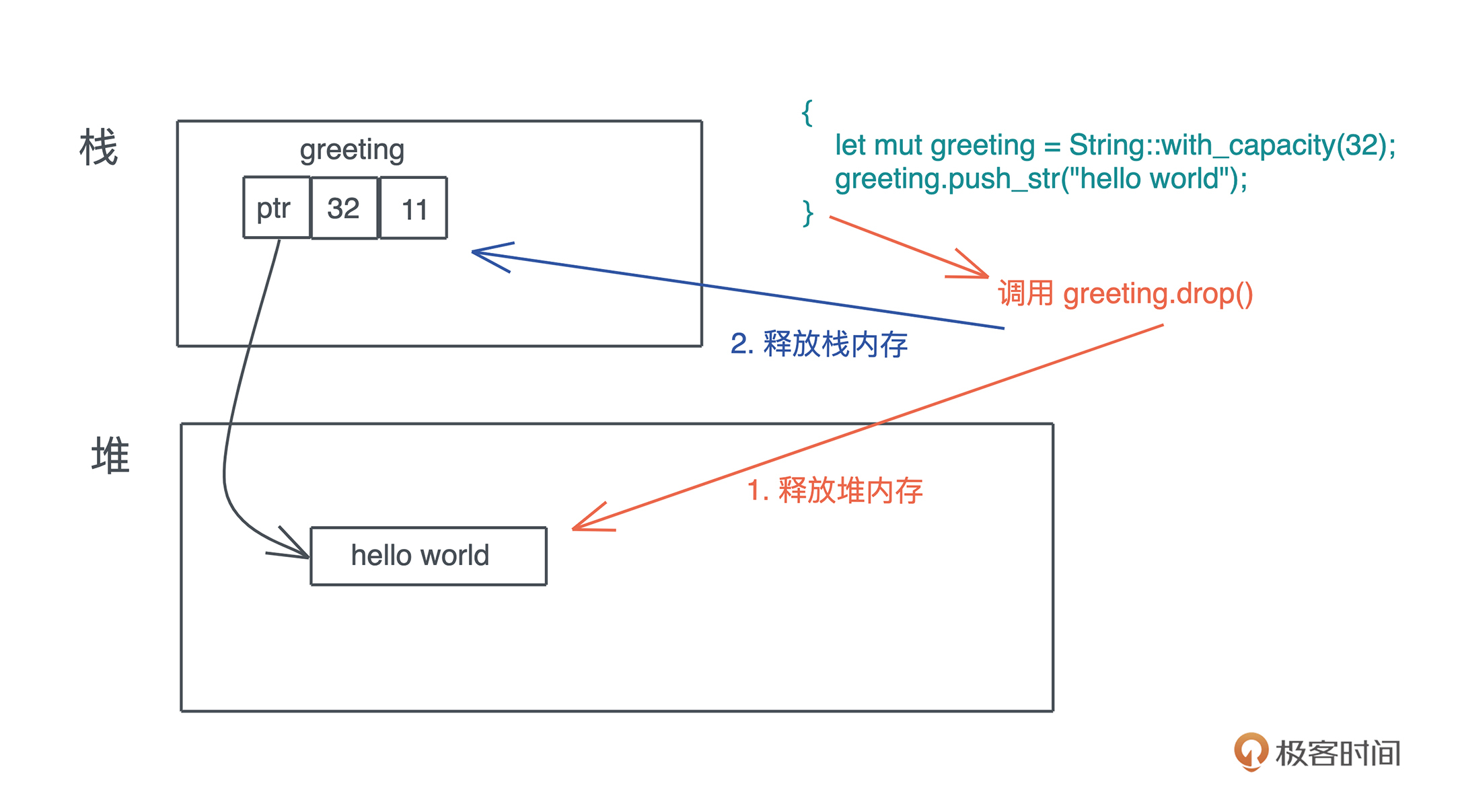

drop释放堆内存

当一个值被释放,其实就是调用它的drop方法

复杂结构递归调用drop